Hadoop-HDFS详解

[TOC]

Hadoop-HDFS详解 HDFS概述 HDFS产出背景 随着数据量越来越大,在一个操作系统存不下所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。

HDFS定义 HDFS (Hadoop Distributed File System),它是一个文件系统,用于存储文件,通过目录树来定位文件;其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS的使用场景:适合一次写入,多次读出的场景,且不支持文件的修改。适合用来做数据分析,并不适合用来做网盘应用。

HDFS优缺点 优点 高容错性

(1)数据自动保存多个副本。它通过增加副本的形式,提高容错性。

(2)某一个副本丢失以后,它可以自动恢复。

适合处理大数据

(1)数据规模:能够处理数据规模达到GB、TB、 甚至PB级别的数据。

(2)文件规模:能够处理百万规模以上的文件数量,数量相当之大。

(3)可构建在廉价机器上,通过多副本机制,提高可靠性。

缺点 不适合低延时数据访问,比如毫秒级的存储数据,是做不到的。 无法高效的对大量小文件进行存储。

(1)存储大量小文件的话,它会占用NameNode大量的内存来存储文件目录和块信息。这样是不可取的,因为NameNode的内 存总是有限的;

(2)小文件存储的寻址时间会超过读取时间,它违反了HDFS的设计目标。

不支持并发写入、文件随机修改。

(1)一个文件只能有一个写,不允许多个线程同时写;

(2)仅支持数据append (追加),不支持文件的随机修改。

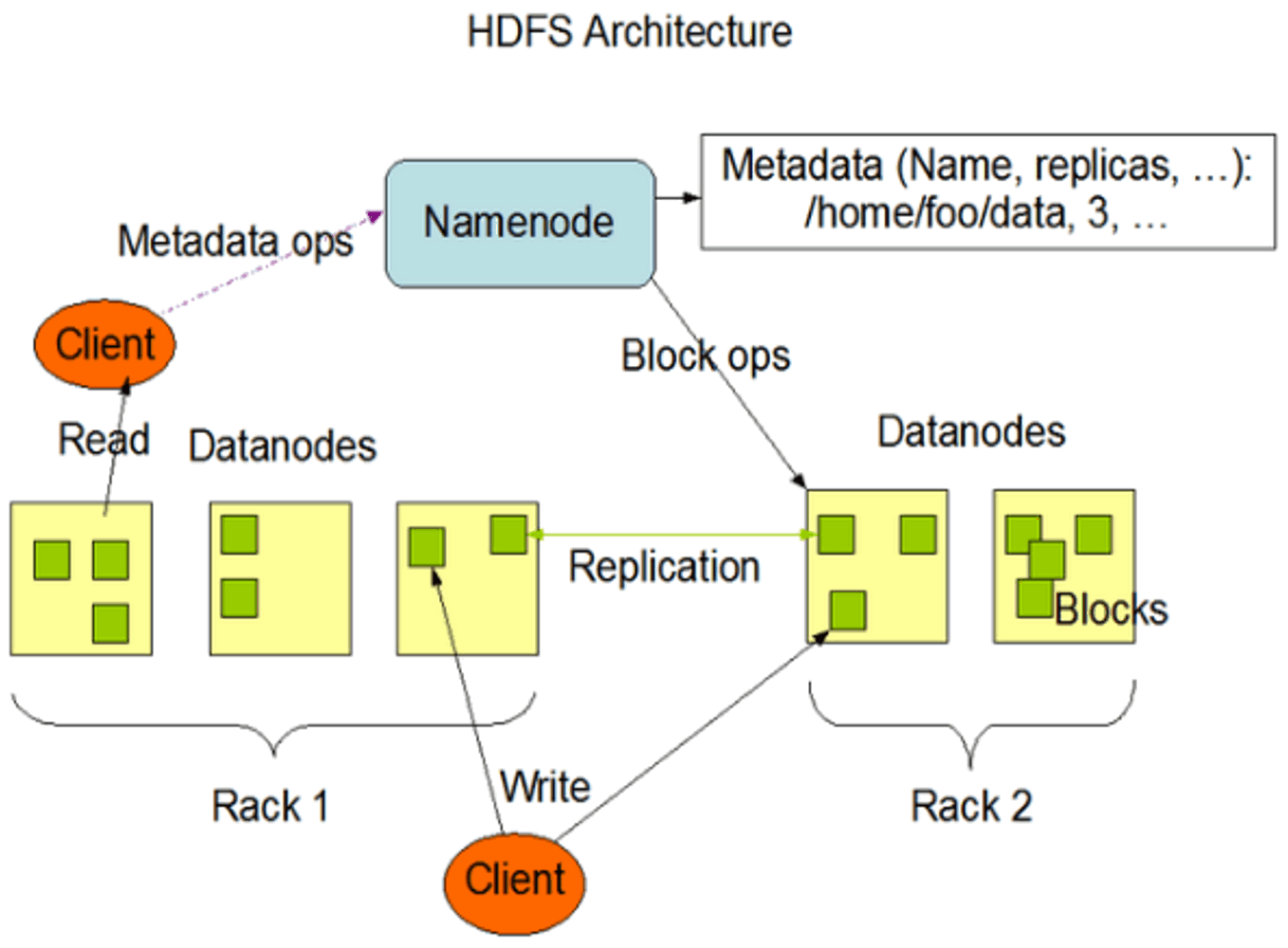

HDFS组成架构 NameNode(m) 就是Master,它是一个主管、管理者。

(1)管理HDFS的名称空间;

(2)配置副本策略;

(3)管理数据块(Block)映射信息;

(4)处理客户端读写请求。

DataNode 就是Slave。 NameNode下达命令, DataNode执行实际的操作。

(1)存储实际的数据块;

(2)执行数据块的读/写操作。

Client 就是客户端。

(1)文件切分。文件上传HDFS的时候,Client将文件切分成一个一个的Block(128M),然后进行上传;

(2)与NameNode交互, 获取文件的位置信息;

(3)与DataNode交互,读取或者写入数据;

(4)Client提供一些命令来管理HDFS,比如NameNode格式化;

(5)Client可以通过一些命令来访问HDFS,比如对HDFS增删查改操作;

Secondary NameNode 并非NameNode的热备。当NameNode挂掉的时候,它并不能马上替换NameNode并提供服务。

(1)辅助NameNode,分担其工作量,比如定期合并Fsimage(镜像文件)和Edits(编译日志),并推送给NameNode;

(2)在紧急情况下,可辅助恢复NameNode。

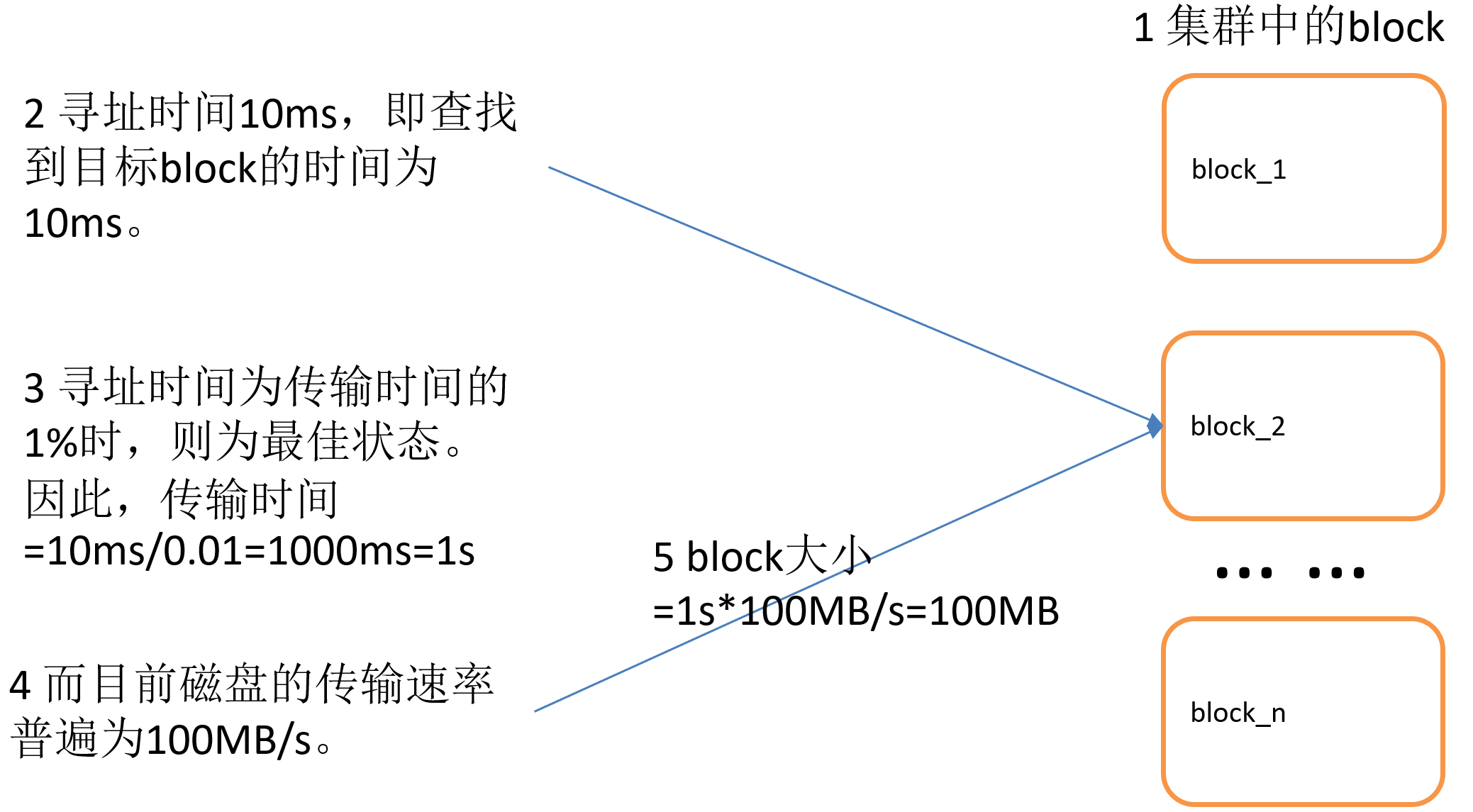

HDFS文件块大小※ HDFS中的文件在物理上是分块存储(Block) ,块的大小可以通过配置参数(dfs. blocksize)来规定,默认大小在Hadoop2.x版本中是128M,老版本中是64M。

1.集群中的block

2.寻址时间10ms,即查找到目标block的时间为10ms。

3.寻址时间为传输时间的1%时,则为最佳状态。因此,传输时间=10ms/0.01=1000ms=1s

4.而目前磁盘的传输速率普遍为100MB/s。(决定块大小,趋向256M)

5.block大小 = 1s * 100MB / s = 100MB

为什么块的大小不能设置太小,也不能设置太大?

HDFS的Shell操作※ 基本语法 1 2 3 4 5 $ bin/hadoop fs 具体命令 $ bin/hdfs dfs 具体命令 dfs是fs的实现类。

命令大全 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hadoop fs Usage: hadoop fs [generic options] [-appendToFile <localsrc> ... <dst>] [-cat [-ignoreCrc] <src> ...] [-checksum <src> ...] [-chgrp [-R] GROUP PATH...] [-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...] [-chown [-R] [OWNER][:[GROUP]] PATH...] [-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>] [-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>] [-count [-q] [-h] <path> ...] [-cp [-f] [-p | -p[topax]] <src> ... <dst>] [-createSnapshot <snapshotDir> [<snapshotName>]] [-deleteSnapshot <snapshotDir> <snapshotName>] [-df [-h] [<path> ...]] [-du [-s] [-h] <path> ...] [-expunge] [-find <path> ... <expression> ...] [-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>] [-getfacl [-R] <path>] [-getfattr [-R] {-n name | -d} [-e en] <path>] [-getmerge [-nl ] <src> <localdst>] [-help [cmd ...]] [-ls [-d] [-h] [-R] [<path> ...]] [-mkdir [-p] <path> ...] [-moveFromLocal <localsrc> ... <dst>] [-moveToLocal <src> <localdst>] [-mv <src> ... <dst>] [-put [-f] [-p] [-l] <localsrc> ... <dst>] [-renameSnapshot <snapshotDir> <oldName> <newName>] [-rm [-f] [-r|-R] [-skipTrash] <src> ...] [-rmdir [--ignore-fail-on-non-empty] <dir > ...] [-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]] [-setfattr {-n name [-v value] | -x name} <path>] [-setrep [-R] [-w] <rep> <path> ...] [-stat [format] <path> ...] [-tail [-f] <file>] [-test -[defsz] <path>] [-text [-ignoreCrc] <src> ...] [-touchz <path> ...] [-truncate [-w] <length> <path> ...] [-usage [cmd ...]] Generic options supported are -conf <configuration file> specify an application configuration file -D <property=value> use value for given property -fs <local |namenode:port> specify a namenode -jt <local |resourcemanager:port> specify a ResourceManager -files <comma separated list of files> specify comma separated files to be copied to the map reduce cluster -libjars <comma separated list of jars> specify comma separated jar files to include in the classpath. -archives <comma separated list of archives> specify comma separated archives to be unarchived on the compute machines. The general command line syntax is bin/hadoop command [genericOptions] [commandOptions]

常用命令实操

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh [atguigu@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh

1 2 3 4 5 6 7 8 9 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -help rm -rm [-f] [-r|-R] [-skipTrash] <src> ... : Delete all files that match the specified file pattern. Equivalent to the Unix command "rm <src>" -skipTrash option bypasses trash, if enabled, and immediately deletes <src> -f If the file does not exist, do not display a diagnostic message or modify the exit status to reflect an error. -[rR] Recursively deletes directories

1 2 3 4 5 6 7 8 9 10 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -ls / Found 1 items drwxr-xr-x - atguigu supergroup 0 2020-07-26 04:33 /user [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -ls -R drwxr-xr-x - atguigu supergroup 0 2020-07-26 05:32 input -rw-r--r-- 3 atguigu supergroup 1366 2020-07-26 05:29 input/README.txt -rw-r--r-- 3 atguigu supergroup 197657687 2020-07-26 05:32 input/hadoop-2.7.2.tar.gz

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -mkdir -p /sanguo/shuguo

多级目录创建需要加-p。

(4)-moveFromLocal:从本地剪切粘贴到HDFS

1 2 3 4 [atguigu@hadoop102 hadoop-2.7.2]$ touch kongming.txt [atguigu@hadoop102 hadoop-2.7.2]$ vim kongming.txt wo shi zhu ge liang [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -moveFromLocal ./kongming.txt /sanguo/shuguo

(5)-appendToFile:追加一个文件到已经存在的文件末尾

hdfs只支持追加不支持修改。

1 2 3 4 [atguigu@hadoop102 hadoop-2.7.2]$ touch liubei.txt [atguigu@hadoop102 hadoop-2.7.2]$ vim liubei.txt san gu mao lu [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -appendToFile liubei.txt /sanguo/shuguo/kongming.txt

1 2 3 4 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -cat /sanguo/shuguo/kongming.txt wo shi zhu ge liang san gu mao lu

(7)-chgrp 、-chmod、-chown:Linux文件系统中的用法一样,修改文件所属权限

更改组、权限、拥有者

1 2 3 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -chgrp atguigu /sanguo/shuguo/kongming.txt [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -chmod 666 /sanguo/shuguo/kongming.txt [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -chown atguigu:atguigu /sanguo/shuguo/kongming.txt

(8)-copyFromLocal:从本地文件系统中拷贝文件到HDFS路径去

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -copyFromLocal README.txt /

(9)-copyToLocal:从HDFS拷贝到本地

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -copyToLocal /sanguo/shuguo/kongming.txt ./

(10)-cp :从HDFS的一个路径拷贝到HDFS的另一个路径

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -cp /sanguo/shuguo/kongming.txt /zhuge.txt

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -mv /zhuge.txt /sanguo/shuguo/

(12)-get:等同于copyToLocal,就是从HDFS下载文件到本地

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -get /sanguo/shuguo/kongming.txt ./

(13)-getmerge:合并下载多个文件,比如HDFS的目录 /user/atguigu/test下有多个文件:log.1, log.2,log.3,...

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -getmerge /user/atguigu/test/* ./zaiyiqi.txt

(14)-put:等同于copyFromLocal

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -put ./zaiyiqi.txt /user/atguigu/test/

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -tail /sanguo/shuguo/kongming.txt

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -rm /user/atguigu/test/jinlian2.txt

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -mkdir /test [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -rmdir /test

1 2 3 4 5 6 7 8 9 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -du -s -h /user/atguigu/test 2.7 K /user/atguigu/test [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -du -h /user/atguigu/test 1.3 K /user/atguigu/test/README.txt 15 /user/atguigu/test/jinlian.txt 1.4 K /user/atguigu/test/zaiyiqi.txt

(19)-setrep:设置HDFS中文件的副本数量

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -setrep 10 /sanguo/shuguo/kongming.txt

这里设置的副本数只是记录在NameNode的元数据中,是否真的会有这么多副本,还得看DataNode的数量。因为目前只有3台设备,最多也就3个副本,只有节点数的增加到10台时,副本数才能达到10。

HDFS客户端操作※ HDFS客户端环境准备

1 HADOOP_HOME=E:\hadoop-2.7.2

JAVA_HOME路径不允许有空格。

将$HADOOP_HOME/etc/hadoop/hadoop-env.cmd文件中的set JAVA_HOME=C:\Program Files\Java\jdk1.8.0_191 修改为 set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_191 保存

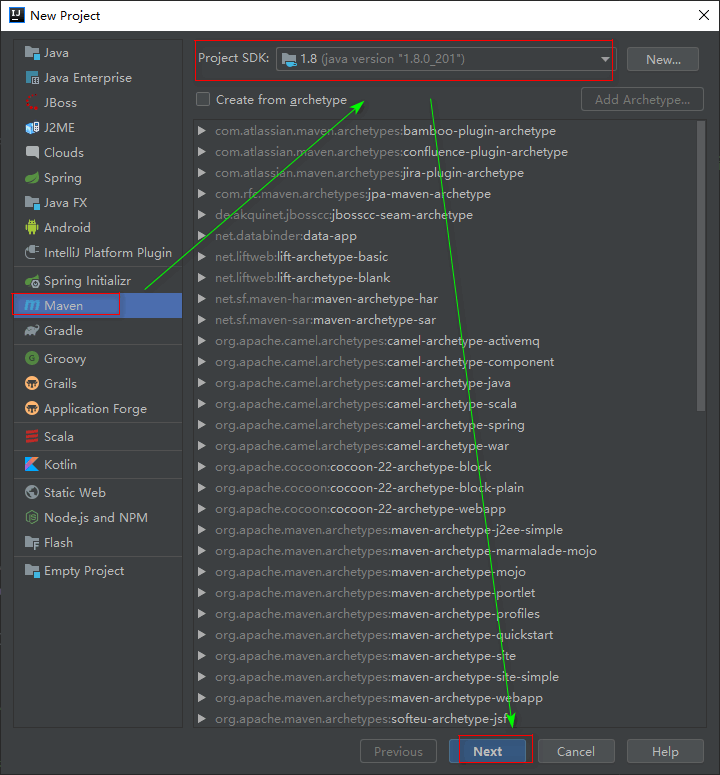

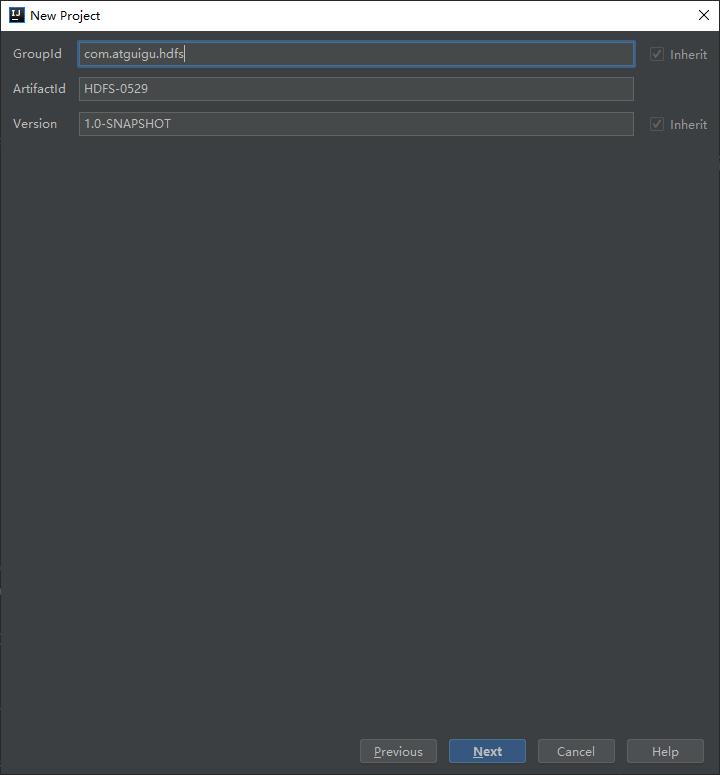

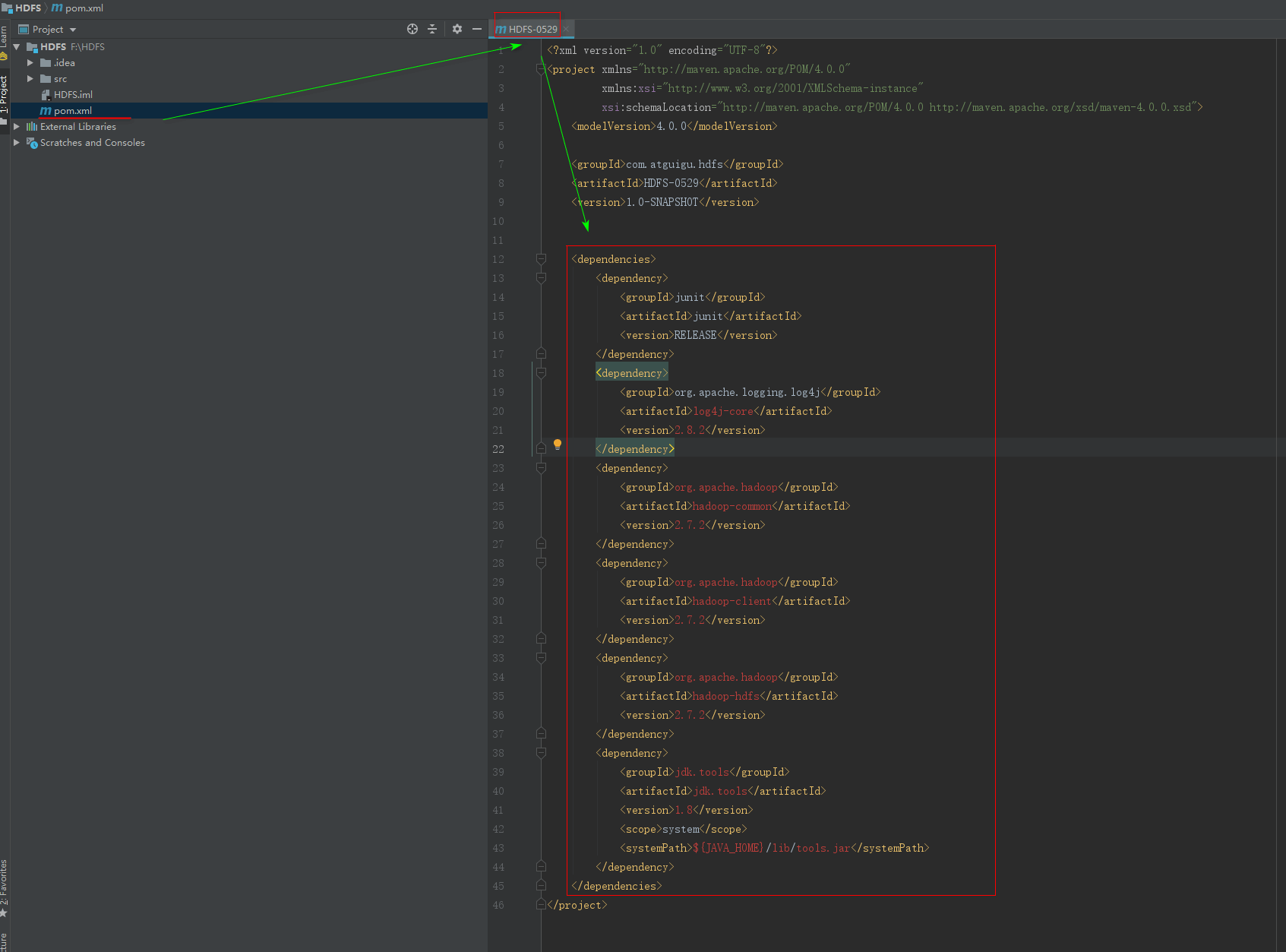

创建一个Maven工程HdfsClientDemo

包名称:com.atguigu.hdfs

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 <dependencies > <dependency > <groupId > junit</groupId > <artifactId > junit</artifactId > <version > RELEASE</version > </dependency > <dependency > <groupId > org.apache.logging.log4j</groupId > <artifactId > log4j-core</artifactId > <version > 2.8.2</version > </dependency > <dependency > <groupId > org.apache.hadoop</groupId > <artifactId > hadoop-common</artifactId > <version > 2.7.2</version > </dependency > <dependency > <groupId > org.apache.hadoop</groupId > <artifactId > hadoop-client</artifactId > <version > 2.7.2</version > </dependency > <dependency > <groupId > org.apache.hadoop</groupId > <artifactId > hadoop-hdfs</artifactId > <version > 2.7.2</version > </dependency > <dependency > <groupId > jdk.tools</groupId > <artifactId > jdk.tools</artifactId > <version > 1.8</version > <scope > system</scope > <systemPath > ${JAVA_HOME}/lib/tools.jar</systemPath > </dependency > </dependencies >

在包com.atguigu.hdfs里创建

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 package com.atguigu.hdfs;import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.FileSystem;import org.apache.hadoop.fs.Path;import org.junit.Test;import java.io.IOException;import java.net.URI;import java.net.URISyntaxException;public class HdfsClient { @Test public void testMkdirs () throws IOException, InterruptedException, URISyntaxException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); fs.mkdirs(new Path ("/1108/daxian/banzhang" )); fs.close(); } }

需要在项目的src/main/resources目录下,新建一个文件,命名为“log4j.properties”,在文件中填入

1 2 3 4 5 6 7 8 log4j.rootLogger=INFO, stdout log4j.appender.stdout=org.apache.log4j.ConsoleAppender log4j.appender.stdout.layout=org.apache.log4j.PatternLayout log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n log4j.appender.logfile=org.apache.log4j.FileAppender log4j.appender.logfile.File=target/spring.log log4j.appender.logfile.layout=org.apache.log4j.PatternLayout log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

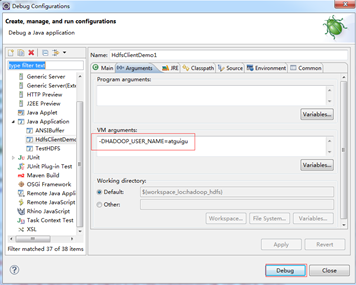

HDFS客户端测试 如果使用eclipse打开项目,运行时需要配置用户名称。

客户端去操作HDFS时,是有一个用户身份的。默认情况下,HDFS客户端API会从JVM中获取一个参数来作为自己的用户身份:-DHADOOP_USER_NAME=atguigu,atguigu为用户名称。

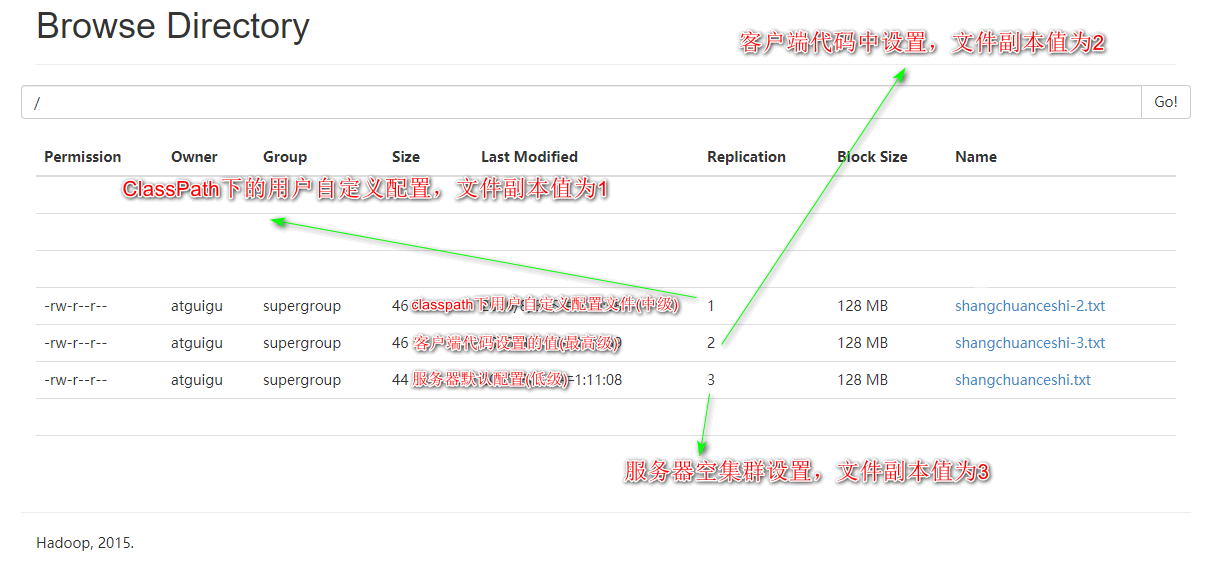

HDFS的API操作 HDFS文件上传(测试参数优先级)

继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 @Test public void testCopyFromLocalFile () throws IOException, InterruptedException, URISyntaxException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); fs.copyFromLocalFile(new Path ("e:/shangchuanceshi.txt" ), new Path ("/shangchuanceshi.txt" )); fs.close(); }

在resources文件夹下创建hdfs-site.xml文件

1 2 3 4 5 6 7 8 9 <?xml version="1.0" encoding="UTF-8" ?> <?xml-stylesheet type="text/xsl" href="configuration.xsl" ?> <configuration > <property > <name > dfs.replication</name > <value > 1</value > </property > </configuration >

再次执行:

1 2 fs.copyFromLocalFile(new Path ("e:/shangchuanceshi-2.txt" ), new Path ("/shangchuanceshi-2.txt" ));

服务器副本数变为1。

再次执行:

1 2 3 4 5 6 Configuration configuration = new Configuration ();configuration.set("dfs.replication" , "2" ); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" );fs.copyFromLocalFile(new Path ("e:/shangchuanceshi-3.txt" ), new Path ("/shangchuanceshi-3.txt" ));

服务器副本数变为1。

参数优先级排序:

(1)客户端代码中设置的值 >(2)ClassPath下的用户自定义配置文件 >(3)然后是服务器的默认配置

HDFS文件下载 继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 @Test public void testCopyToLocalFile () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); fs.copyToLocalFile(new Path ("/shangchuanceshi.txt" ),new Path ("e:/shangchuanceshi-xiazai.txt" )); fs.close(); }

服务器上shangchuanceshi.txt保留;本地出现shangchuanceshi-xiazai.txt和.shangchuanceshi-xiazai.txt.crc两个文件。

再次执行方法:

1 2 fs.copyToLocalFile(true ,new Path ("/shangchuanceshi.txt" ),new Path ("e:/shangchuanceshi-xiazai2.txt" ));

服务器上shangchuanceshi.txt被删除;本地出现.shangchuanceshi-xiazai2.txt和.shangchuanceshi-xiazai2.txt.crc两个文件。

再次执行方法:

1 2 fs.copyToLocalFile(false ,new Path ("/shangchuanceshi-2.txt" ),new Path ("e:/shangchuanceshi-xiazai3.txt" ),true );

服务器上shangchuanceshi-2.txt没有被删除;本地出现shangchuanceshi-xiazai3.txt一个文件。

直接下载文件会出现同名文件的.crc后缀,使用本地文件模式就可以解决此问题。

HDFS文件删除 继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 @Test public void testDelete () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); fs.delete(new Path ("/0529" ), true ); fs.close(); }

HDFS文件更名 继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 @Test public void testRename () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); fs.rename(new Path ("/shangchuanceshi-2.txt" ), new Path ("/shangchuanceshi-2-rename.txt" )); fs.close(); }

HDFS文件详情查看 查看文件名称、权限、长度、块信息

继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 @Test public void testListFiles () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path ("/" ), true ); while (listFiles.hasNext()) { LocatedFileStatus status = listFiles.next(); System.out.print(status.getPath().getName()); System.out.print("\t" ); System.out.print(status.getPermission()); System.out.print("\t" ); System.out.print(status.getLen()); System.out.print("\t" ); BlockLocation[] blockLocations = status.getBlockLocations(); for (BlockLocation blockLocation : blockLocations) { String[] hosts = blockLocation.getHosts(); for (String host : hosts) { System.out.print(host); System.out.print("\t" ); } } System.out.println(); System.out.println("------------" ); } fs.close(); }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 README.txt rw-r--r-- 1366 hadoop103 hadoop102 hadoop104 ------------ kongming.txt rw-r--r-- 34 hadoop103 hadoop102 hadoop104 ------------ shangchuanceshi-2-rename.txt rw-r--r-- 46 hadoop102 ------------ shangchuanceshi-3.txt rw-r--r-- 46 hadoop102 hadoop104 ------------ README.txt rw-r--r-- 1366 hadoop103 hadoop102 hadoop104 ------------ hadoop-2.7.2.tar.gz rw-r--r-- 197657687 hadoop103 hadoop102 hadoop104 hadoop103 hadoop102 hadoop104 ------------ zhuge.txt rw-r--r-- 34 hadoop103 hadoop102 hadoop104 ------------

HDFS文件和文件夹判断 继续在HDFSCilent.java中书写方法

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 @Test public void testListStatus () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); FileStatus[] listStatues = fs.listStatus(new Path ("/" )); for (FileStatus fileStatus : listStatues) { if (fileStatus.isFile()) { System.out.println("f:" + fileStatus.getPath().getName()); } else { System.out.println("d:" + fileStatus.getPath().getName()); } } fs.close(); }

1 2 3 4 5 6 f:README.txt d:sanguo f:shangchuanceshi-2-rename.txt f:shangchuanceshi-3.txt d:user f:zhuge.txt

HDFS的I/O流操作 上面我们学的API操作HDFS系统都是框架封装好的。那么如果我们想自己实现上述API的操作该怎么实现呢?

我们可以采用IO流的方式实现数据的上传和下载。

HDFS文件上传IO 需求 把本地e盘上的IO-shangchuan.txt文件上传到HDFS根目录

编写代码 新建HDFSIO.java文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 @Test public void putFileToHDFS () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); FileInputStream fileInputStream = new FileInputStream (new File ("e:/IO-shangchuan.txt" )); FSDataOutputStream fsDataOutputStream = fs.create(new Path ("/IO-shangchuan-shangchuan.txt" )); IOUtils.copyBytes(fileInputStream, fsDataOutputStream, configuration); IOUtils.closeStream(fsDataOutputStream); IOUtils.closeStream(fileInputStream); fs.close(); }

HDFS文件下载IO 需求 从HDFS上下载IO-shangchuan-shangchuan.txt文件到本地e盘上

编写代码 继续在HDFSIO.java文件中书写

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 @Test public void getFileFormHDFS () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); FSDataInputStream fsDataInputStream = fs.open(new Path ("/IO-shangchuan-shangchuan.txt" )); FileOutputStream fileOutputStream = new FileOutputStream (new File ("e:/IO-shangchuan-xiazai.txt" )); IOUtils.copyBytes(fsDataInputStream, fileOutputStream, configuration); IOUtils.closeStream(fsDataInputStream); IOUtils.closeStream(fileOutputStream); fs.close(); }

IO流传输不会产生.crc文件。

HDFS文件定位读取IO 需求 分块读取HDFS上的大文件,比如根目录下的/hadoop-2.7.2.tar.gz。

1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -put /opt/software/hadoop-2.7.2.tar.gz /

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 Block 0 Block ID: 1073741838 Block Pool ID: BP-1347968132-192.168.228.102-1595708538420 Generation Stamp: 1019 Size: 134217728 Availability: hadoop103 hadoop104 hadoop102 Block 1 Block ID: 1073741839 Block Pool ID: BP-1347968132-192.168.228.102-1595708538420 Generation Stamp: 1020 Size: 63439959 Availability: hadoop103 hadoop102 hadoop104

网页端点击Download时候会下载完整文件。

如果对于大日志文件10G,我只想下载最新block或者查看一部分block,没有必要下载全部文件。

编写代码 继续在HDFSIO.java文件中书写

下载前128M文件。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 @Test public void readFileSeek1 () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); FSDataInputStream fsDataInputStream = fs.open(new Path ("/hadoop-2.7.2.tar.gz" )); FileOutputStream fileOutputStream = new FileOutputStream (new File ("e:/hadoop-2.7.2-xiazai.tar.gz.part1" )); byte [] buf = new byte [1024 ]; for (int i = 0 ; i < 1024 * 128 ; i++) { fsDataInputStream.read(buf); fileOutputStream.write(buf); } IOUtils.closeStream(fsDataInputStream); IOUtils.closeStream(fileOutputStream); fs.close(); }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 @Test public void readFileSeek2 () throws URISyntaxException, IOException, InterruptedException { Configuration configuration = new Configuration (); FileSystem fs = FileSystem.get(new URI ("hdfs://hadoop102:9000" ), configuration, "atguigu" ); FSDataInputStream fsDataInputStream = fs.open(new Path ("/hadoop-2.7.2.tar.gz" )); fsDataInputStream.seek(1024 * 1024 * 128 ); FileOutputStream fileOutputStream = new FileOutputStream (new File ("e:/hadoop-2.7.2-xiazai.tar.gz.part2" )); IOUtils.copyBytes(fsDataInputStream, fileOutputStream, configuration); IOUtils.closeStream(fsDataInputStream); IOUtils.closeStream(fileOutputStream); fs.close(); }

打开e盘目录发现出现两个文件

1 2 hadoop-2.7.2-xiazai.tar.gz.part2 61954KB hadoop-2.7.2-xiazai.tar.gz.part1 131072KB

文件资源管理器输入cmd

1 E:\>type hadoop-2.7.2-xiazai.tar.gz.part2 >> hadoop-2.7.2-xiazai.tar.gz.part1

合并完成后修改hadoop-2.7.2-xiazai.tar.gz.part1 1932026KB后缀名为hadoop-2.7.2-xiazai.tar.gz,解压检查。

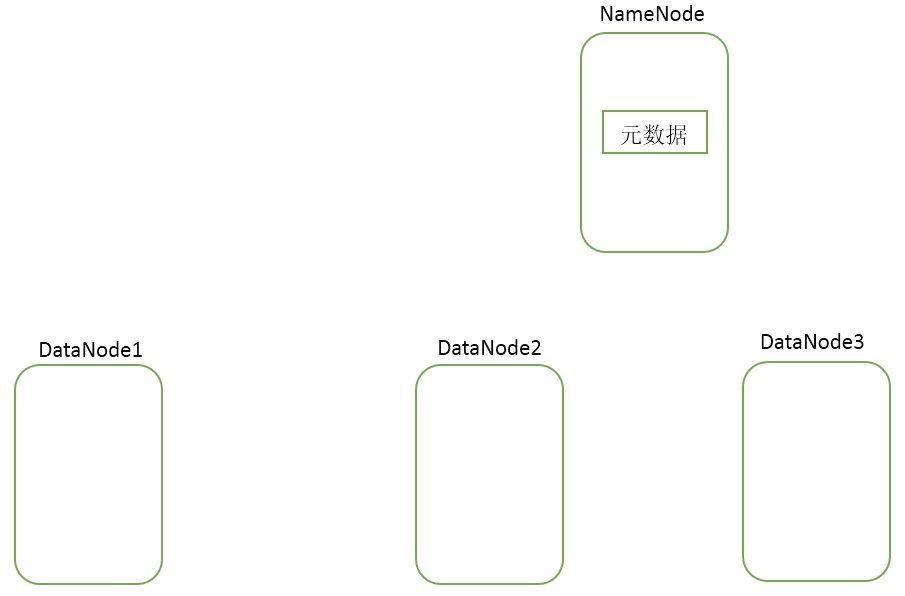

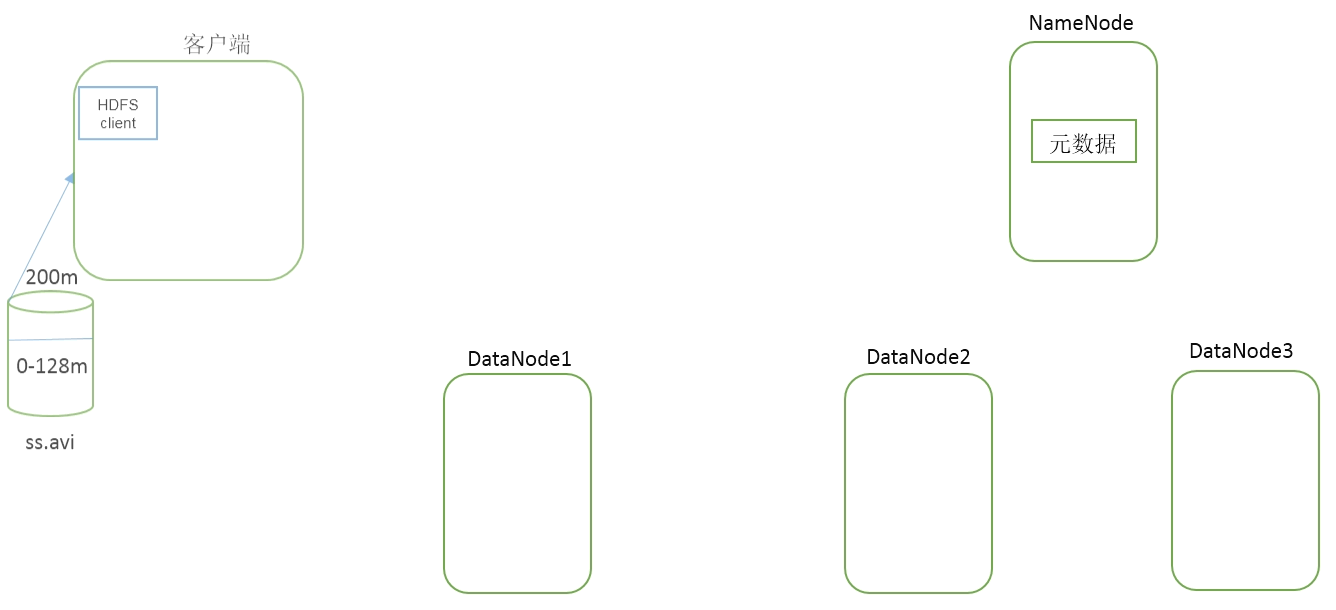

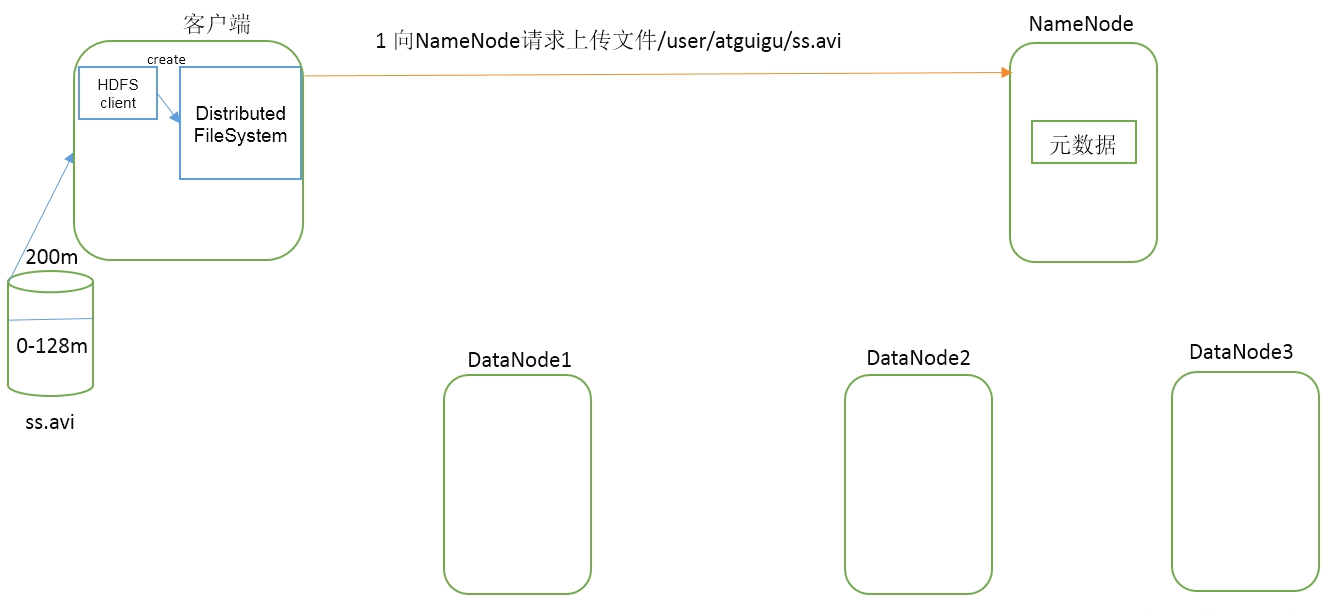

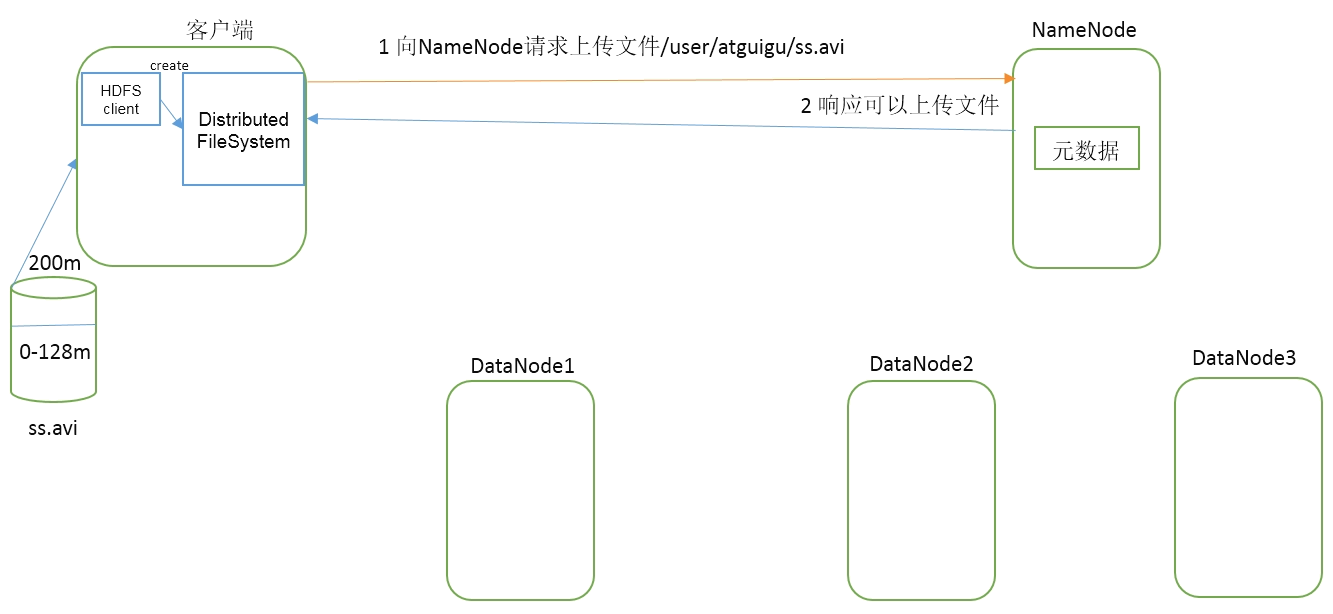

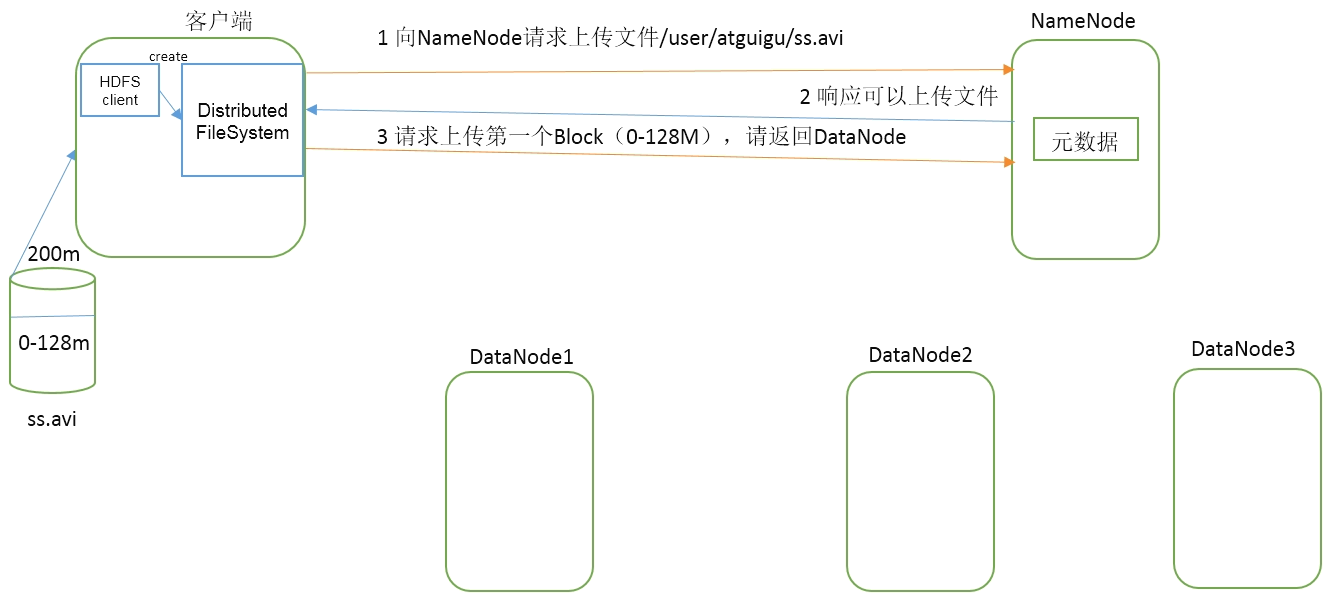

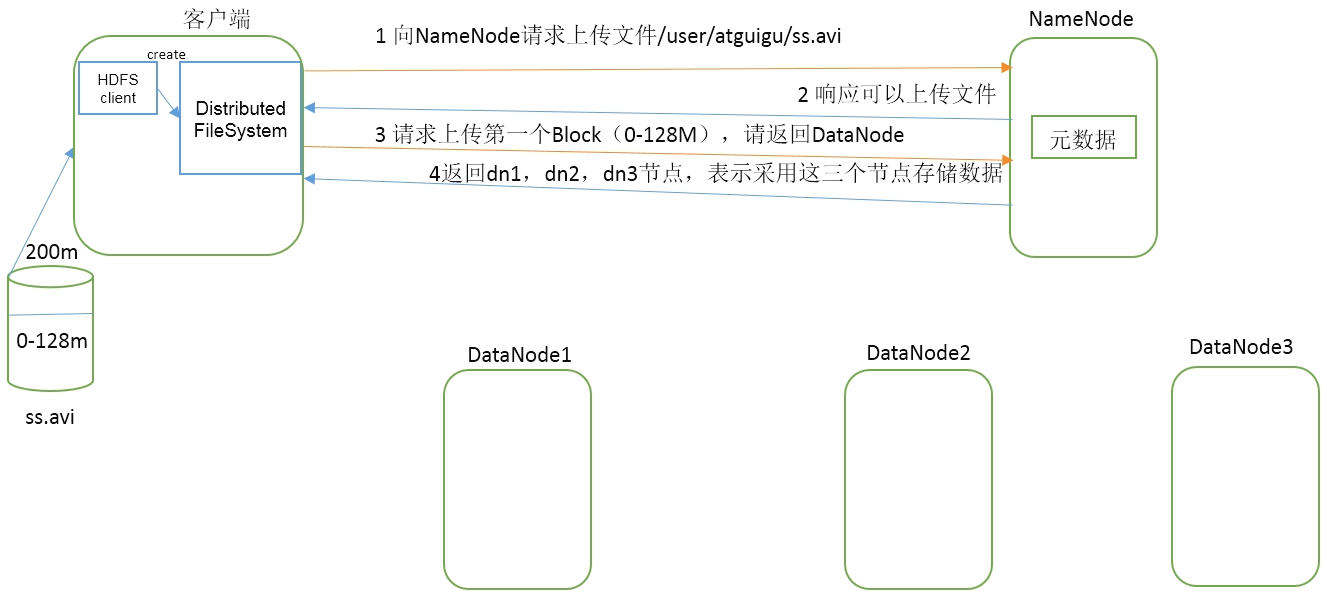

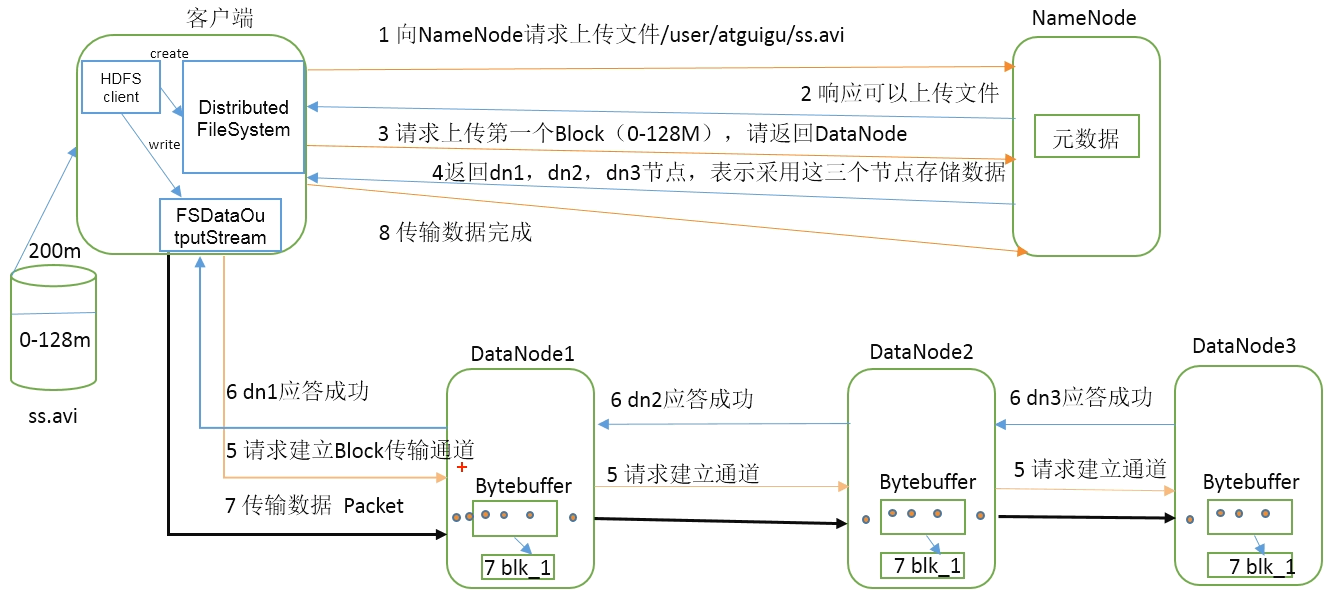

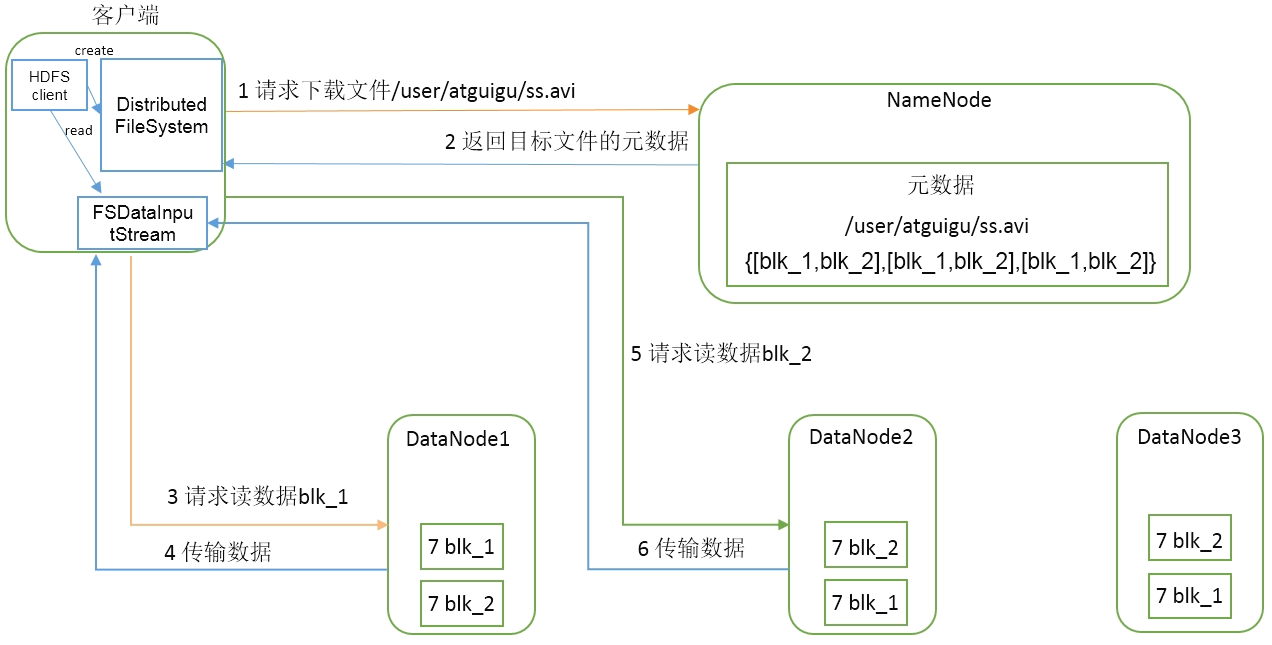

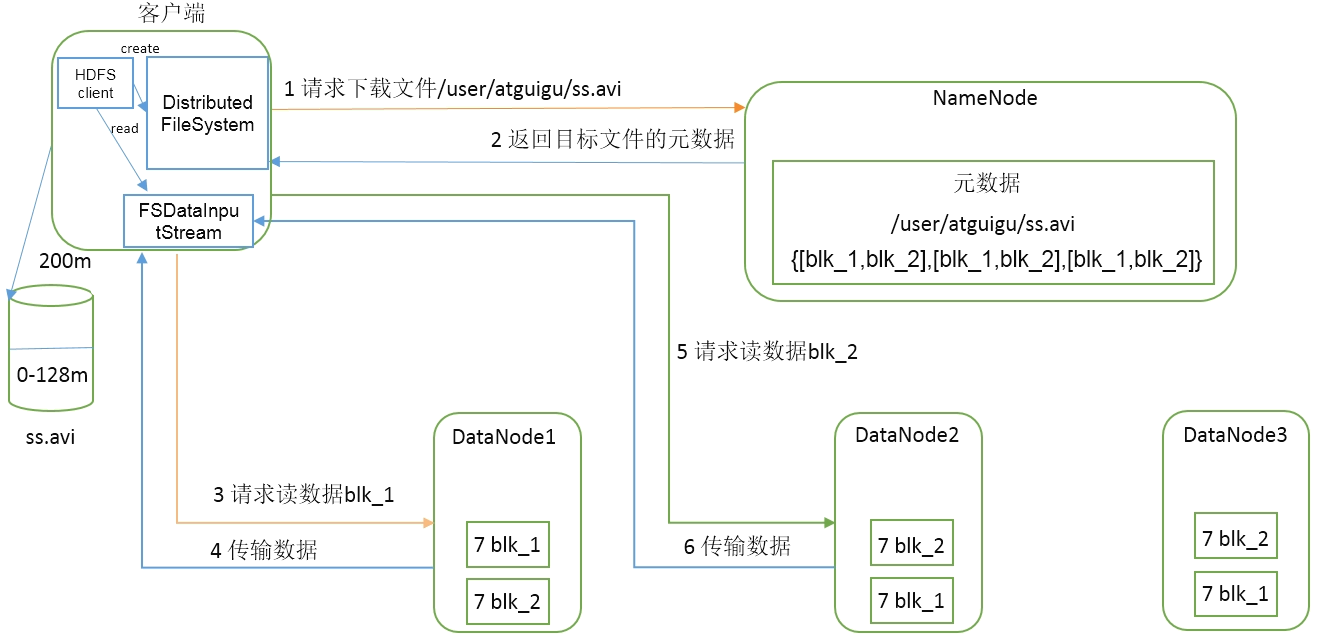

HDFS的数据流※ HDFS写数据流程 剖析文件写入 HDFS写数据流程

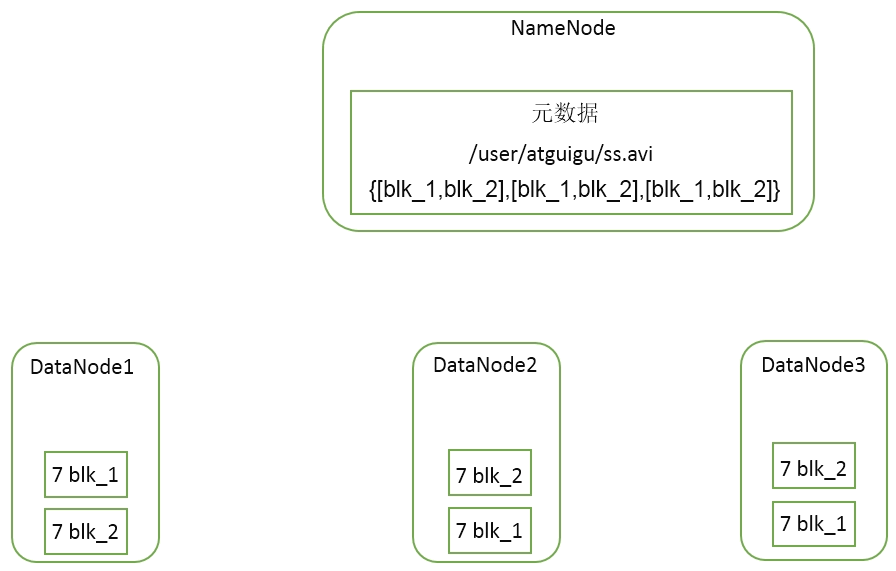

现有集群如下:

有客户端:

要将200M的ss.avi文件通过客户端上传到集群。

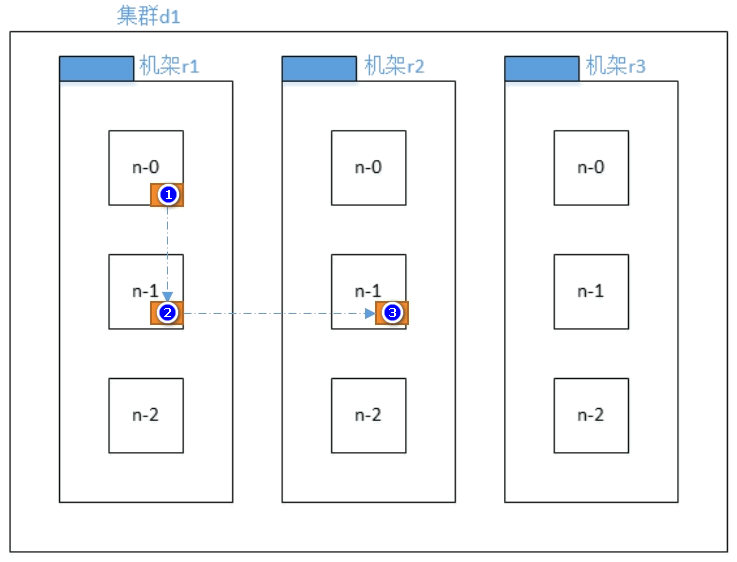

1)客户端通过Distributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否已存在,父目录是否存在。

3)客户端请求第一个 Block上传到哪几个DataNode服务器上。

4)NameNode返回3个DataNode节点,分别为dn1、dn2、dn3。

根据节点距离、负载决定节点。(谁离客户端越近,就优先选谁。)

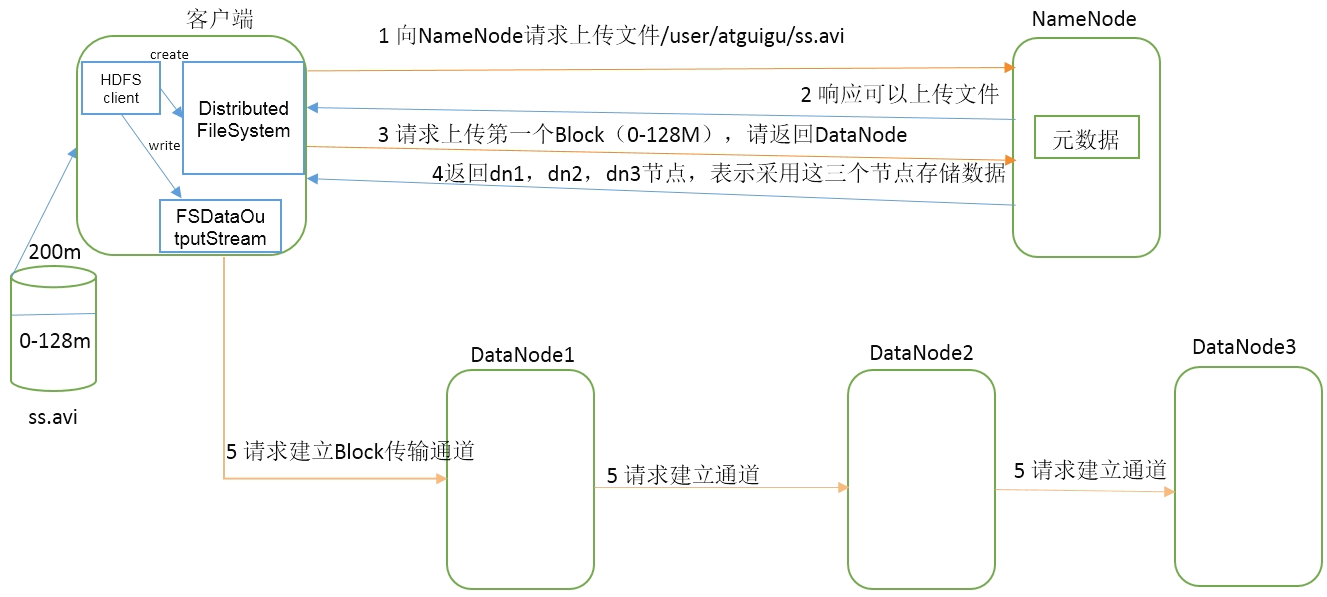

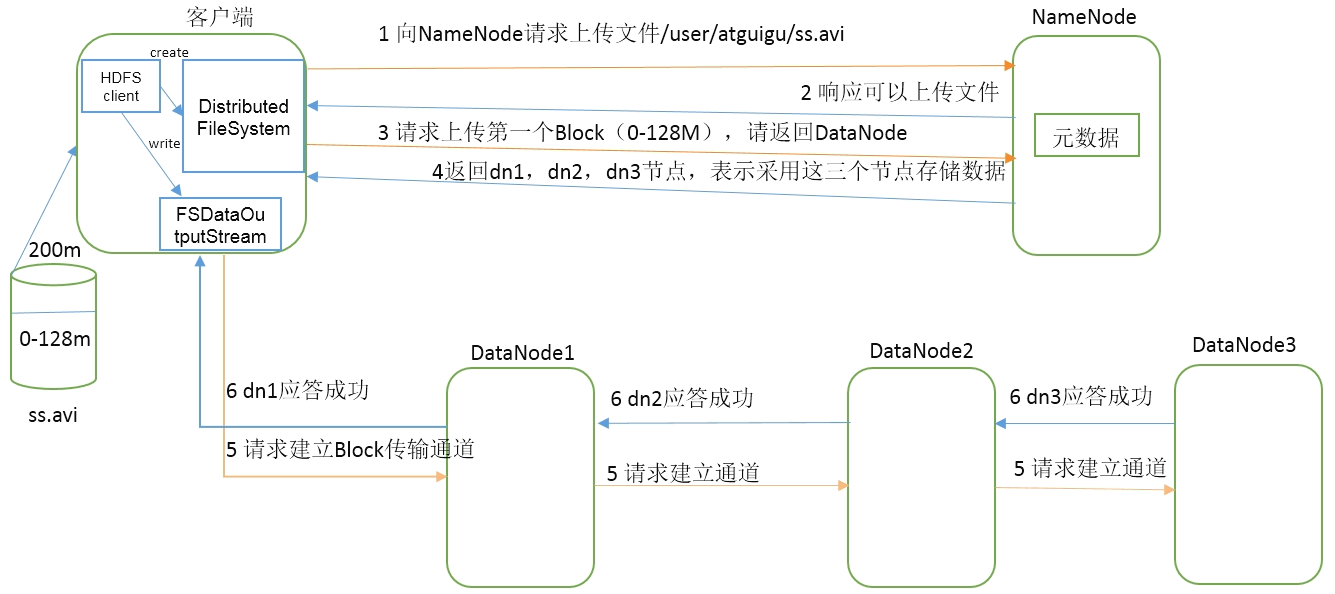

5)客户端通过FSDataOutputStream模块请求dn1上传数据,dn1收到请求会继续调用dn2,然后dn2调用dn3,将这个通信管道建立完成。

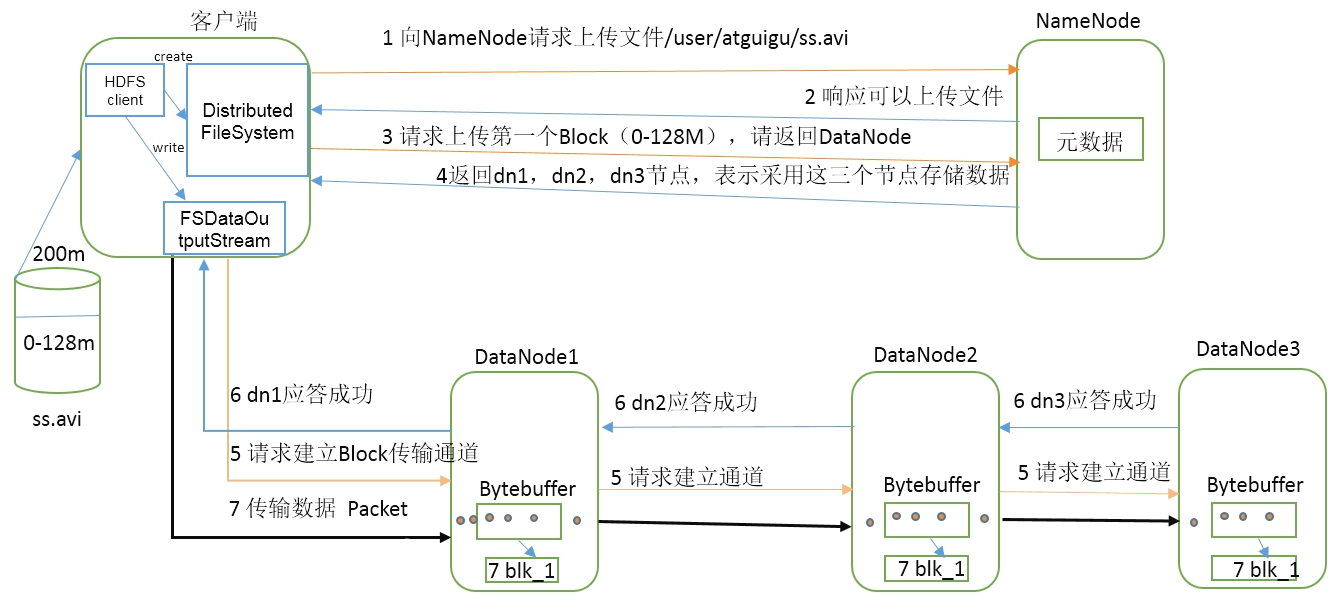

7)客户端开始往dn1上传第一个Block(先从磁盘读取数据放到一个本地内存缓存),以Packet为单位,dn1收到一个Packet就会传给dn2,dn2传给dn3;dn1每传一个packet会放入一个应答队列等待应答。

8)当一个Block传输完成之后,客户端再次请求NameNode上传第二个Block的服务器。(重复执行3-7步)。

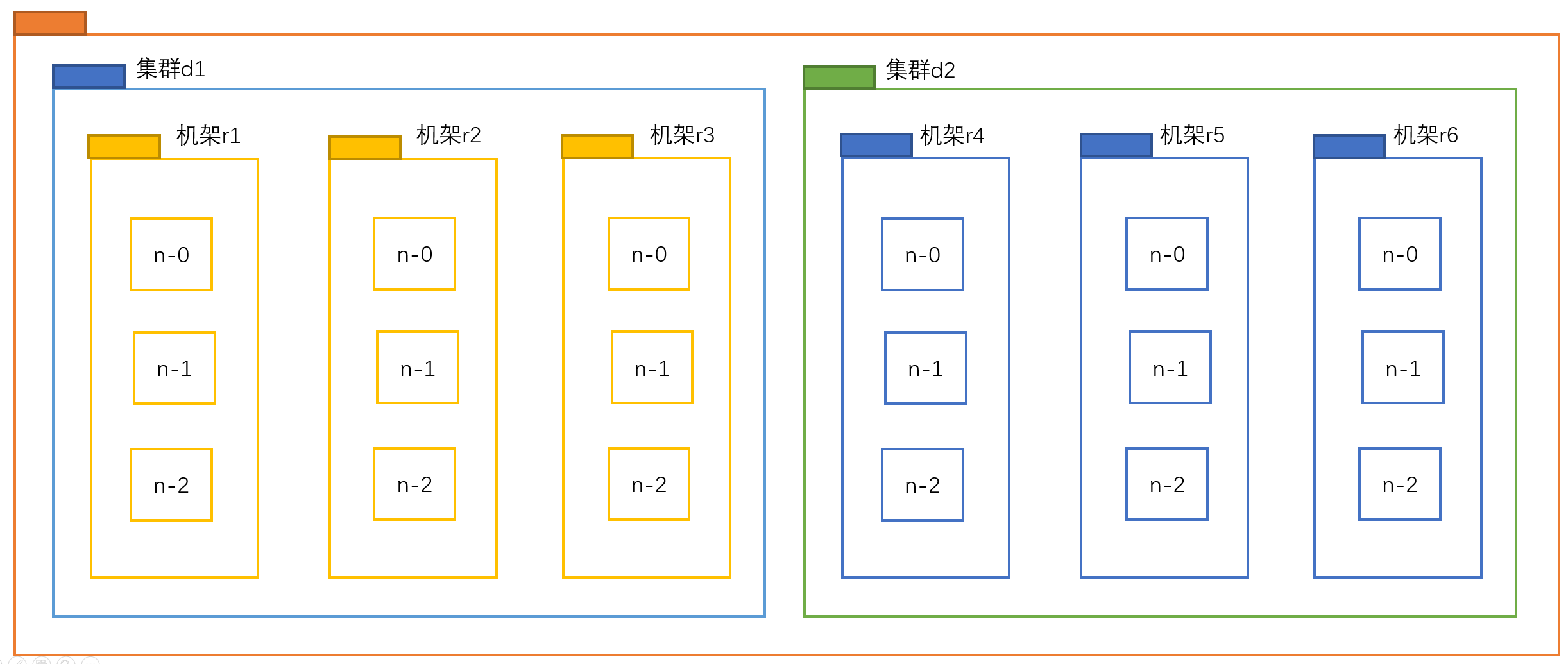

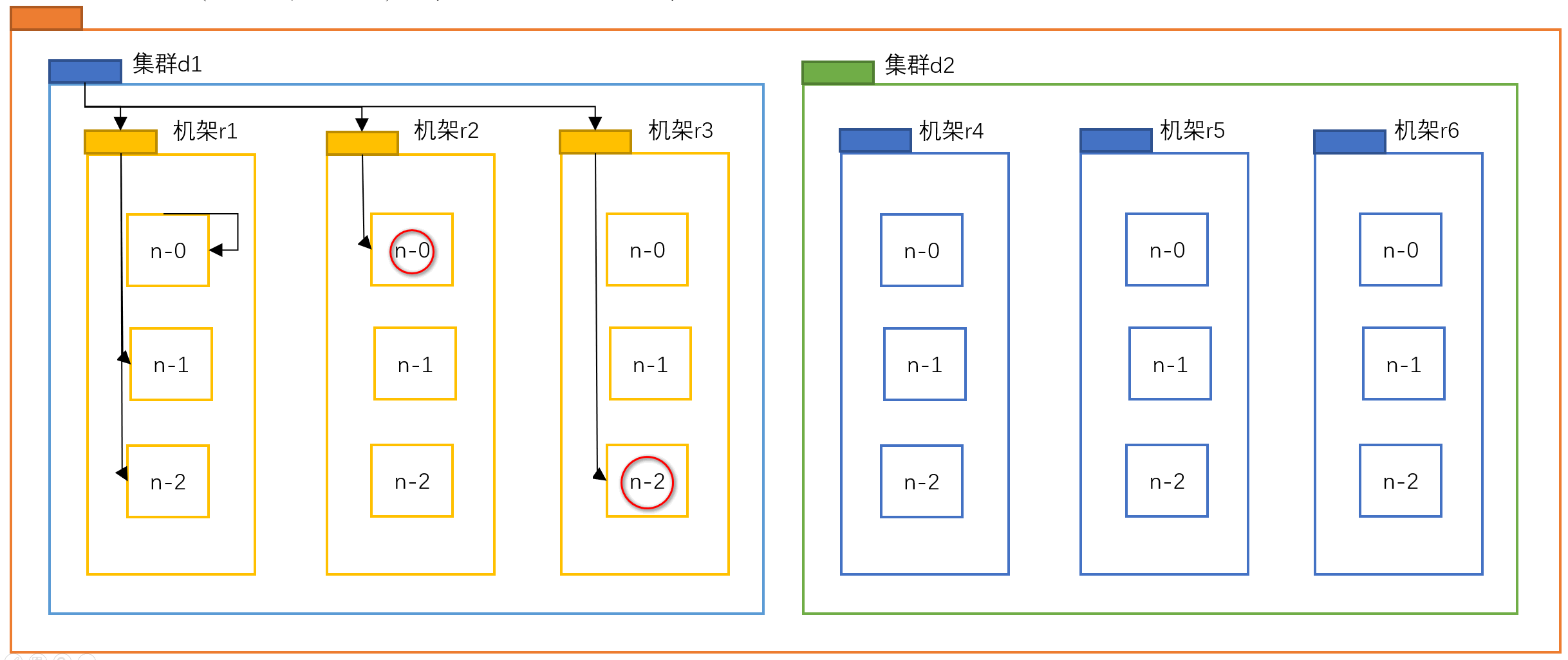

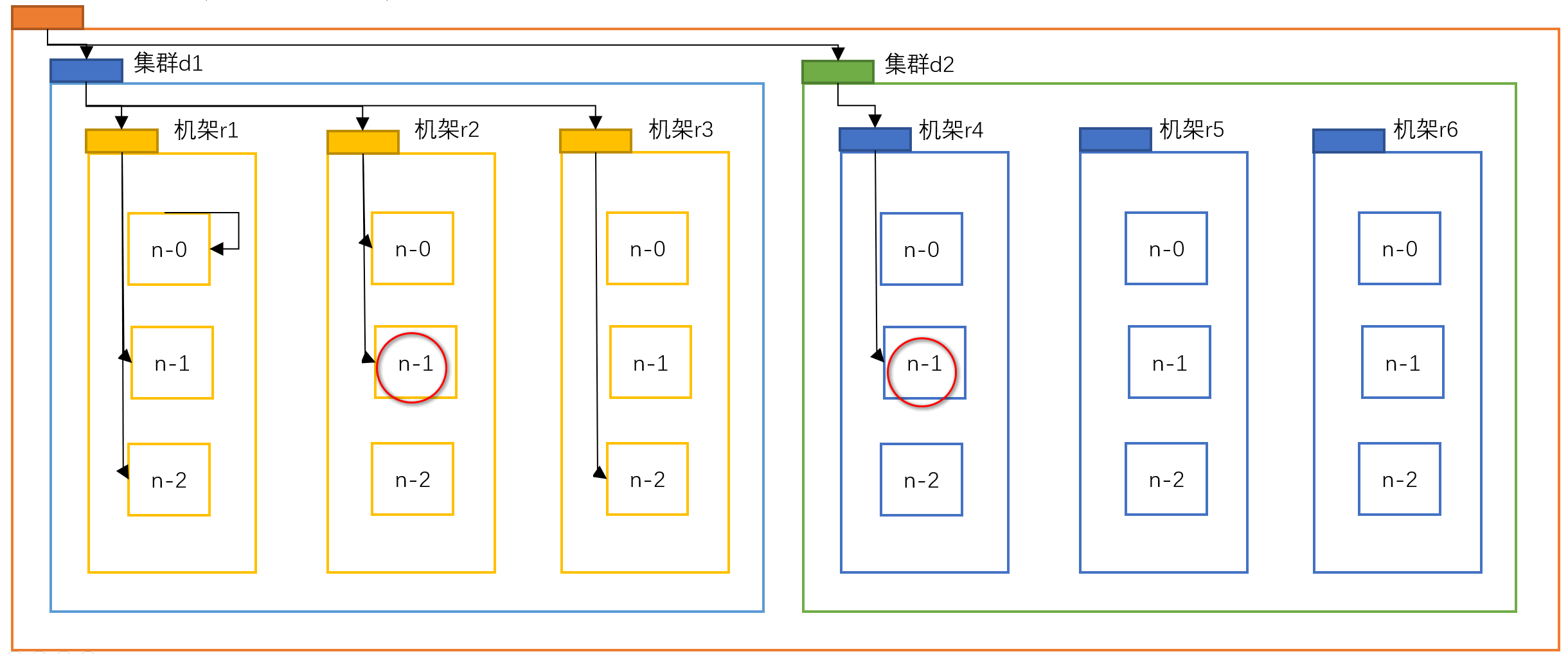

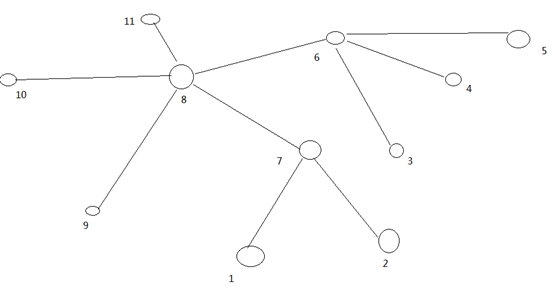

网络拓扑-节点距离计算 在HDFS写数据的过程中,NameNode会选择距离待上传数据最近距离的DataNode接收数据。那么这个最近距离怎么计算呢?

节点距离 :两个节点到达最近的共同祖先的距离总和。

Distance(/d1/r1/n0, /d1/r1/n0)=0(同一节点上的进程)

共同祖先是自己,0

Distance(/d1/r1/n1, /d1/r1/n2)=2(同一机架上的不同节点)

共同祖先是r1,n-1向上有1到r1,n-2向上有1到r2;1+1=2

Distance(/d1/r2/n0, /d1/r3/n2)=4(同一数据中心不同机架上的节点)

共同祖先是d1,n-0向上有2,n-2向上有2;2+2=4

Distance(/d1/r2/n1, /d2/r4/n1)=6(不同数据中心的节点)

共同祖先是数据中心,n-1向上有3到数据中心,n-1向上有3到数据中心;3+3=6

上图显示9和5之间的距离可以用线段数来表示,9到8为1,5到8为2;1+2=3

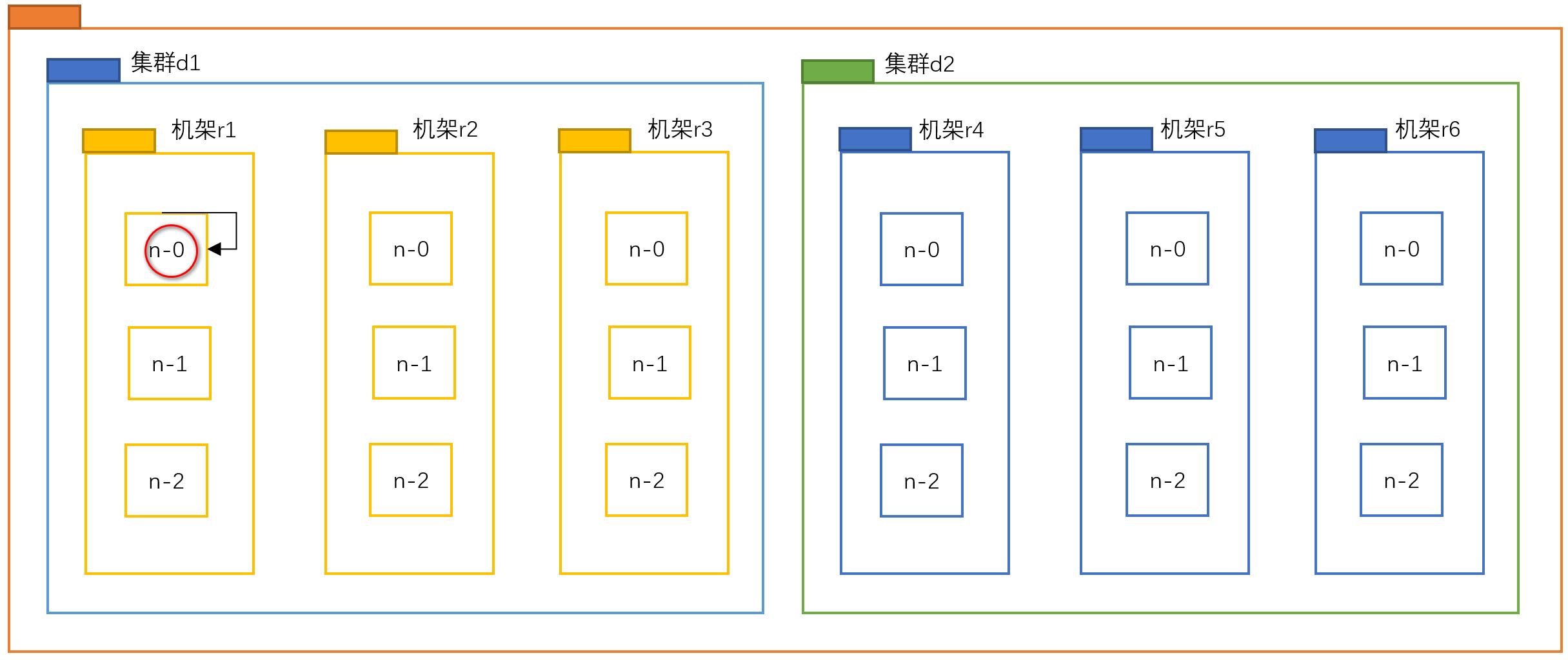

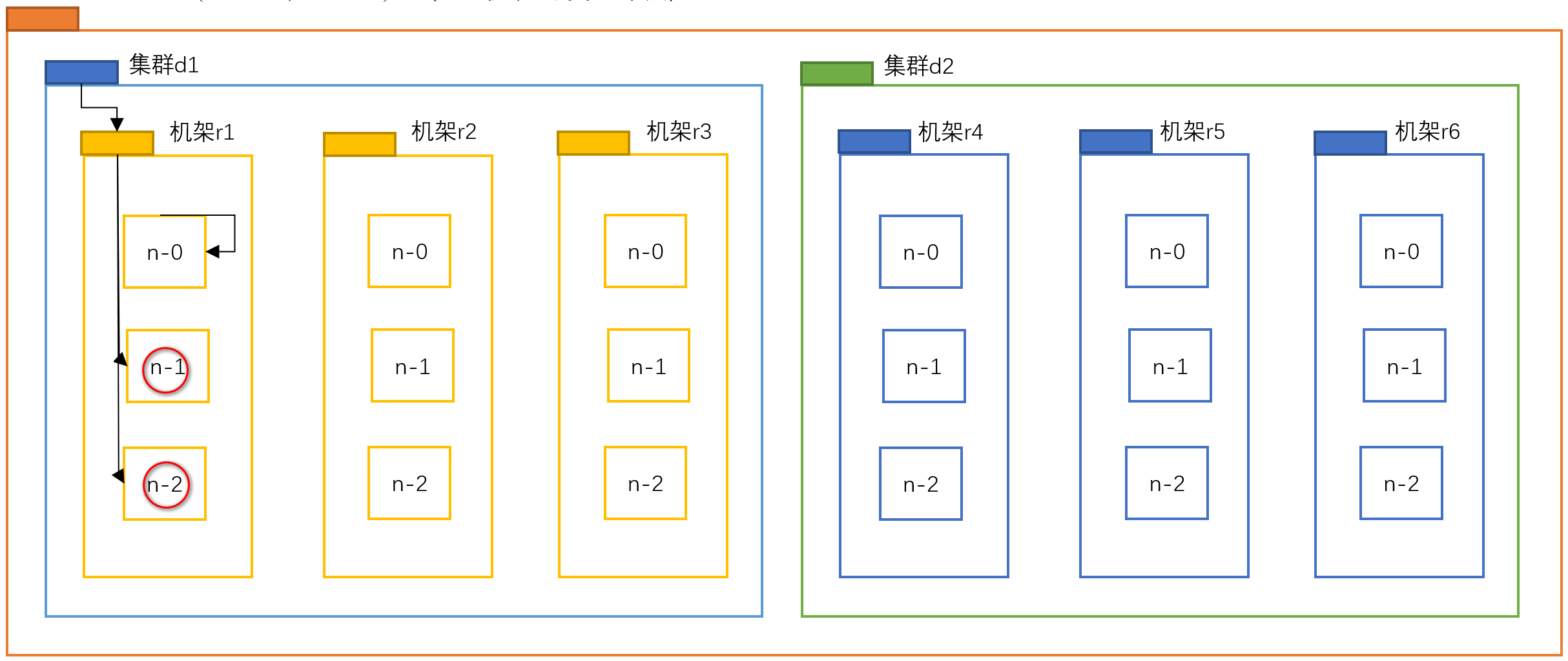

机架感知(副本存储节点选择)

hadoop-机架

第一个副本在Client所处的节点上。如果客户端在集群外,随机选一个。

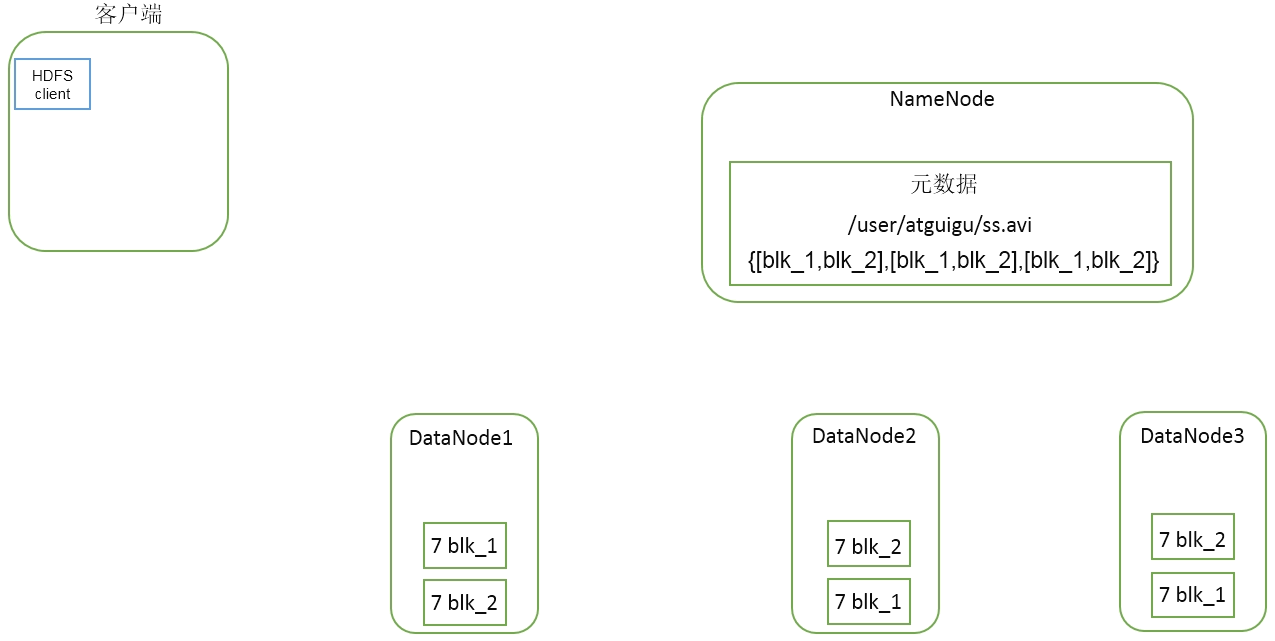

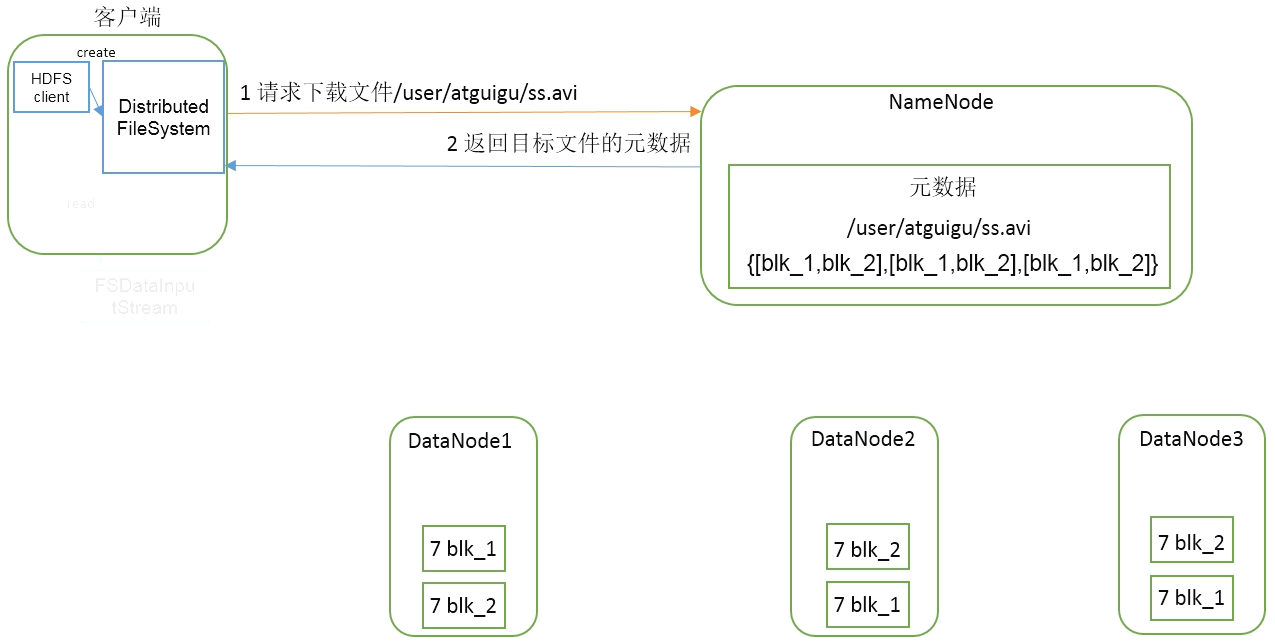

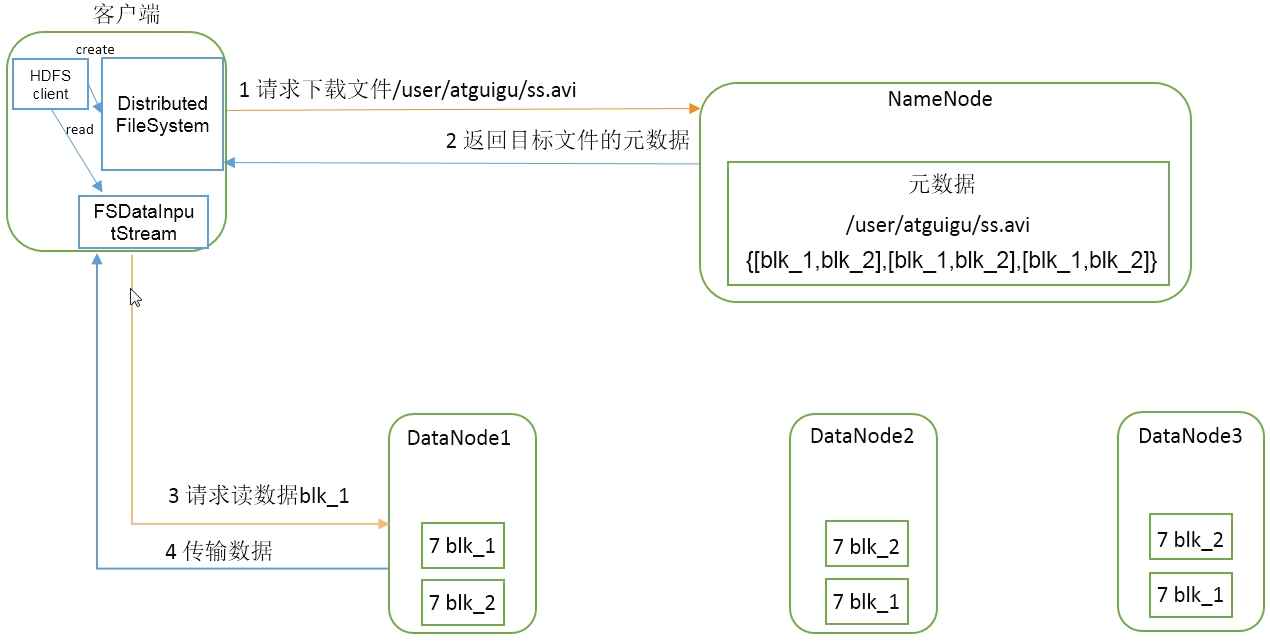

HDFS读数据流程 现有集群如下:

有客户端:

1)客户端通过Distributed FileSystem向NameNode请求下载文件,NameNode通过查询元数据,找到文件块所在的DataNode地址。

2)挑选一台DataNode(就近原则,然后随机)服务器,请求读取数据。

3)DataNode开始传输数据给客户端(从磁盘里面读取数据输入流,以Packet为单位来做校验)。

4)客户端以Packet为单位接收,先在本地缓存,然后写入目标文件。

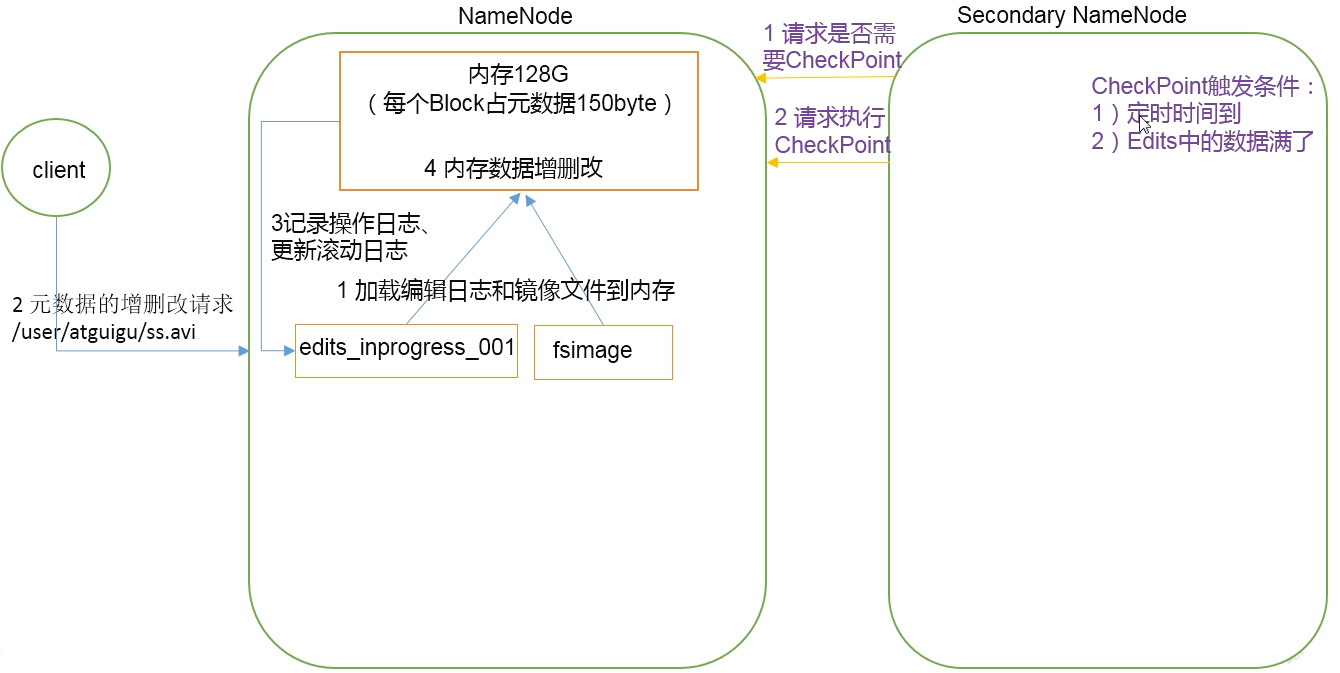

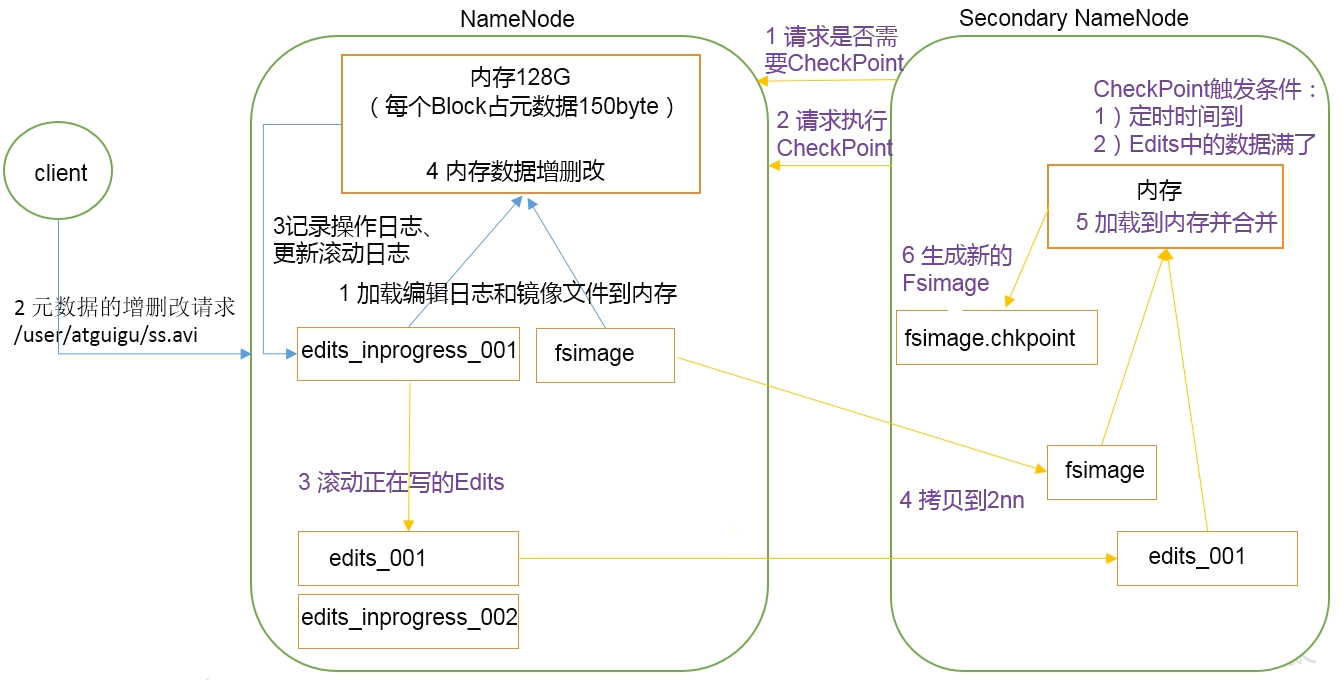

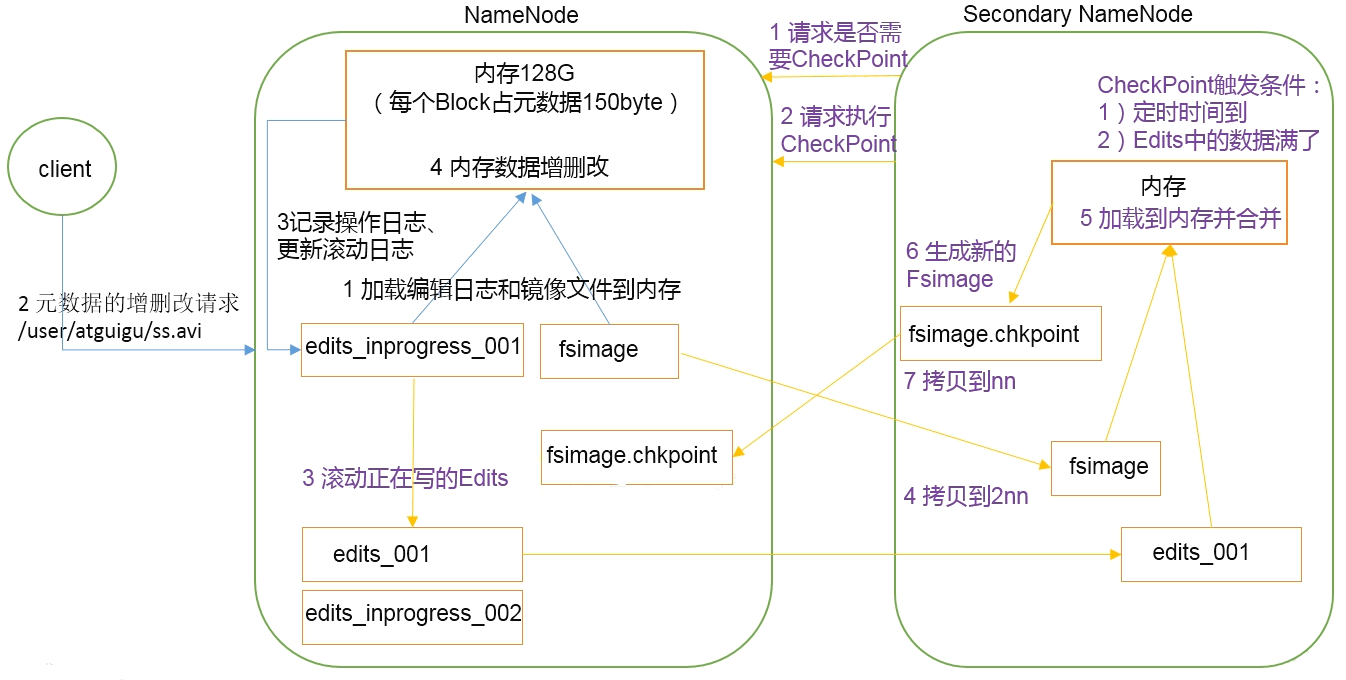

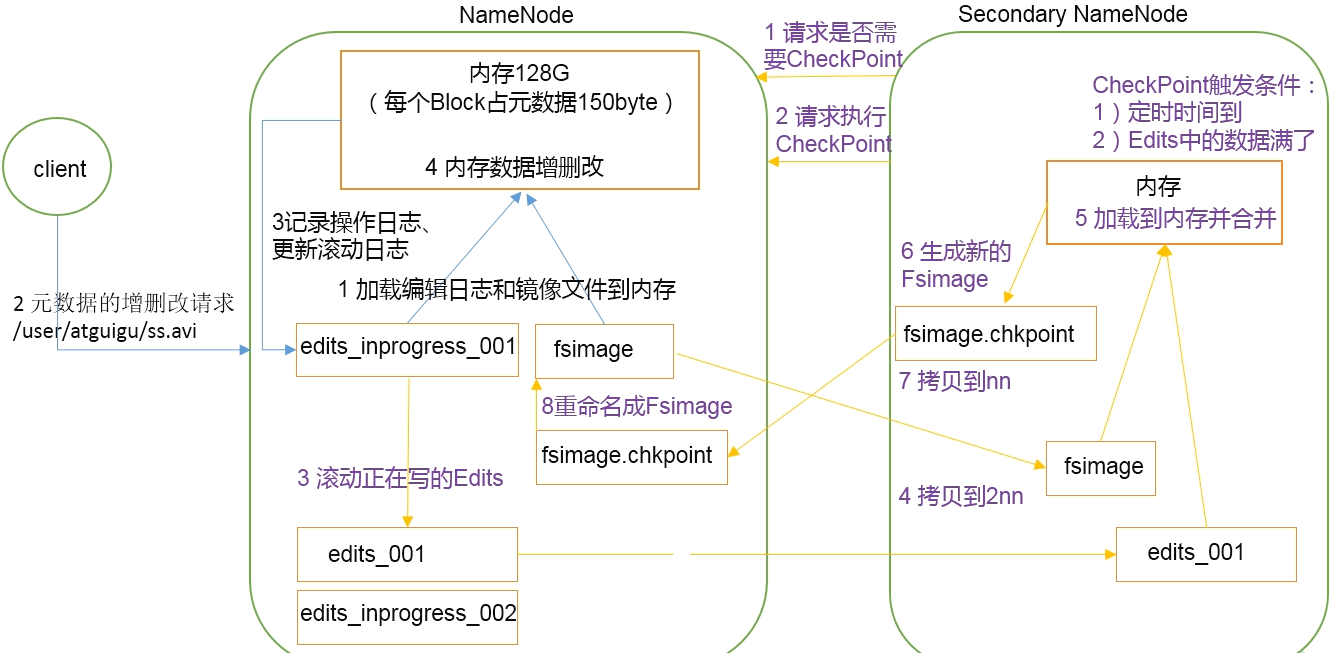

NameNode和SecondaryNameNode※ NN和2NN工作机制

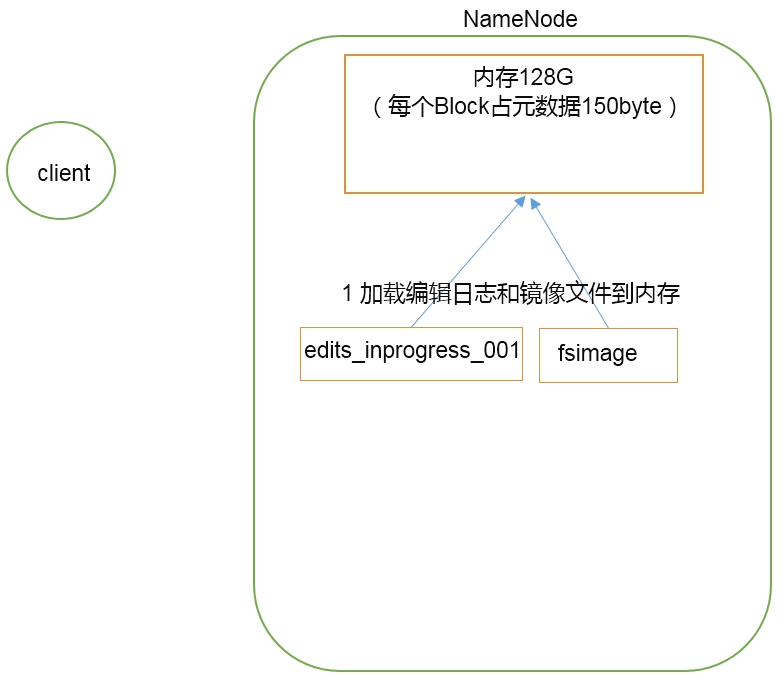

首先,我们做个假设,如果存储在NameNode节点的磁盘中,因为经常需要进行随机访问,还有响应客户请求,必然是效率过低。因此,元数据需要存放在内存中。但如果只存在内存中,一旦断电,元数据丢失,整个集群就无法工作了。因此产生在磁盘中备份元数据的FsImage。(可靠)

这样又会带来新的问题,当在内存中的元数据更新时,如果同时更新FsImage,就会导致效率过低,但如果不更新,就会发生一致性问题,一旦NameNode节点断电,就会产生数据丢失。因此,引入Edits文件(只进行追加操作,效率很高)。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到Edits中。这样,一旦NameNode节点断电,可以通过FsImage和Edits的合并,合成元数据。(效率)

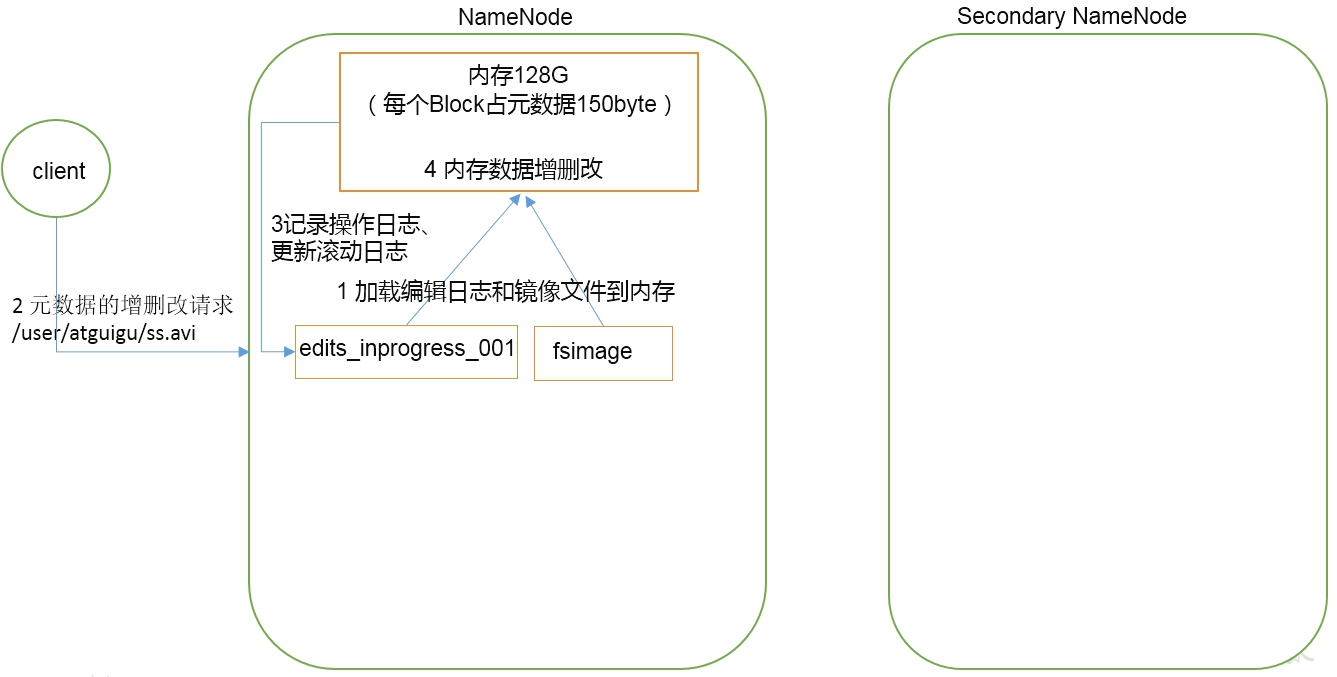

但是,如果长时间添加数据到Edits中,会导致该文件数据过大,效率降低,而且一旦断电,恢复元数据需要的时间过长。因此,需要定期进行FsImage和Edits的合并,如果这个操作由NameNode节点完成,又会效率过低。因此,引入一个新的节点SecondaryNamenode,专门用于FsImage和Edits的合并。(FsImage+Edits=集群)

NN和2NN工作原理图 现有集群和客户端:

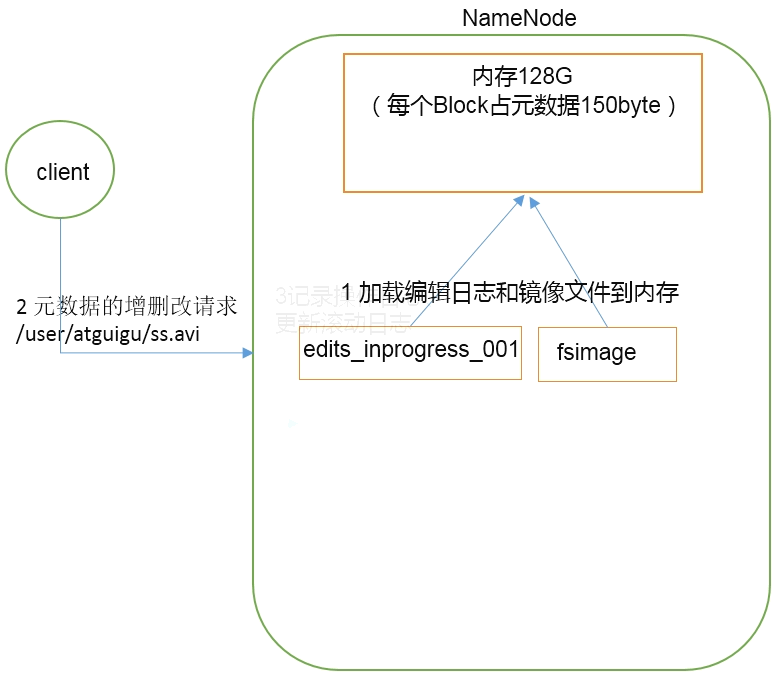

第一阶段:NameNode启动

(1)第一次启动NameNode格式化后,创建Fsimage和Edits文件。如果不是第一次启动,直接加载编辑日志和镜像文件到内存。

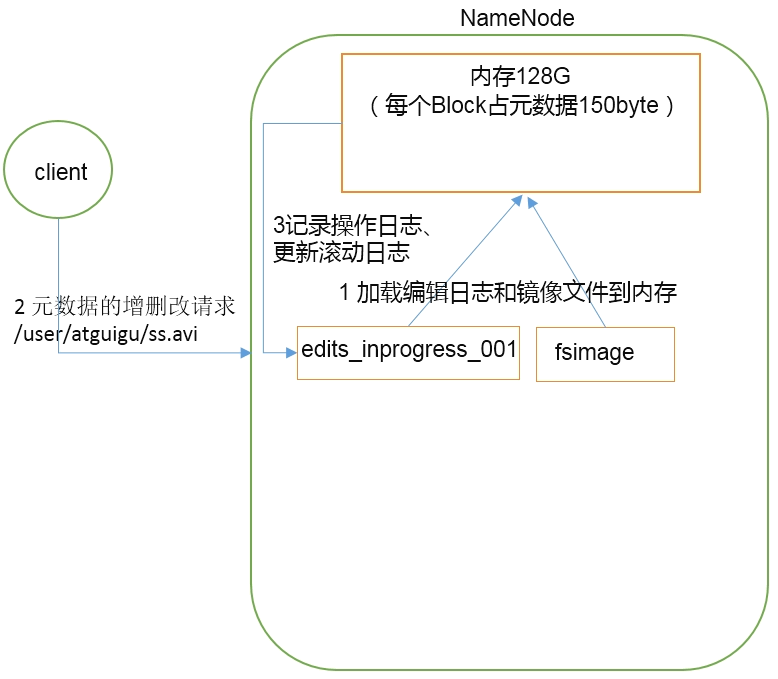

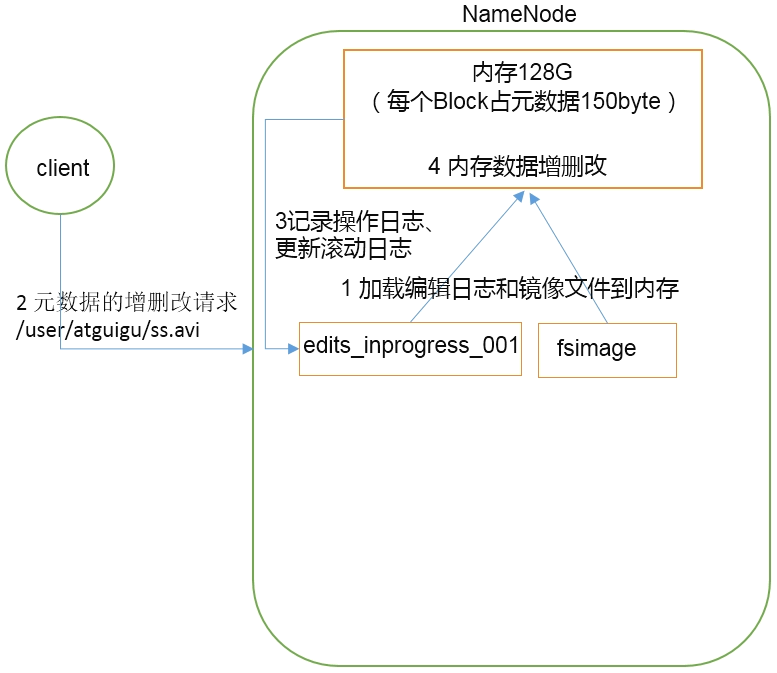

(3)NameNode记录操作日志,更新滚动日志。

先记录操作日志然后更新内存数据。

第二阶段:Secondary NameNode工作

(1)Secondary NameNode询问NameNode是否需要CheckPoint。直接带回NameNode是否检查结果。

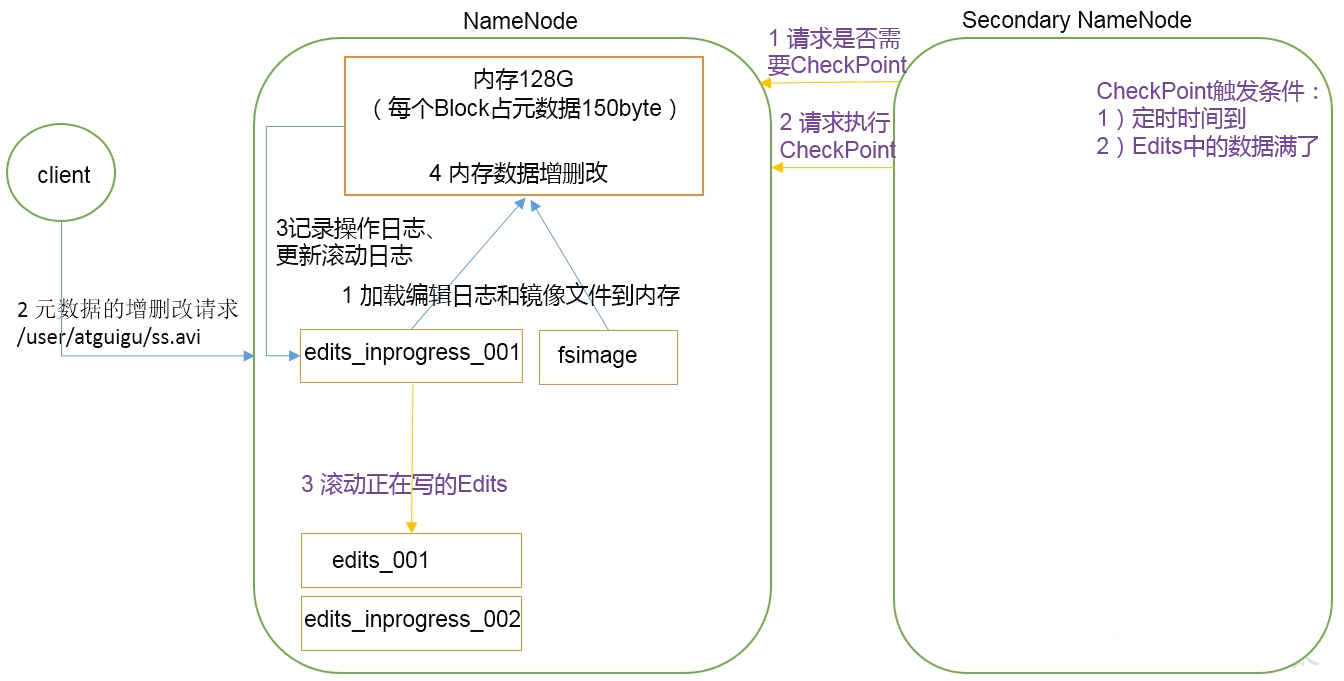

定时1小时 || Edits数据达到100万条 ==> 执行合并操作

回滚原来edits保存,然后生成空的edits写入

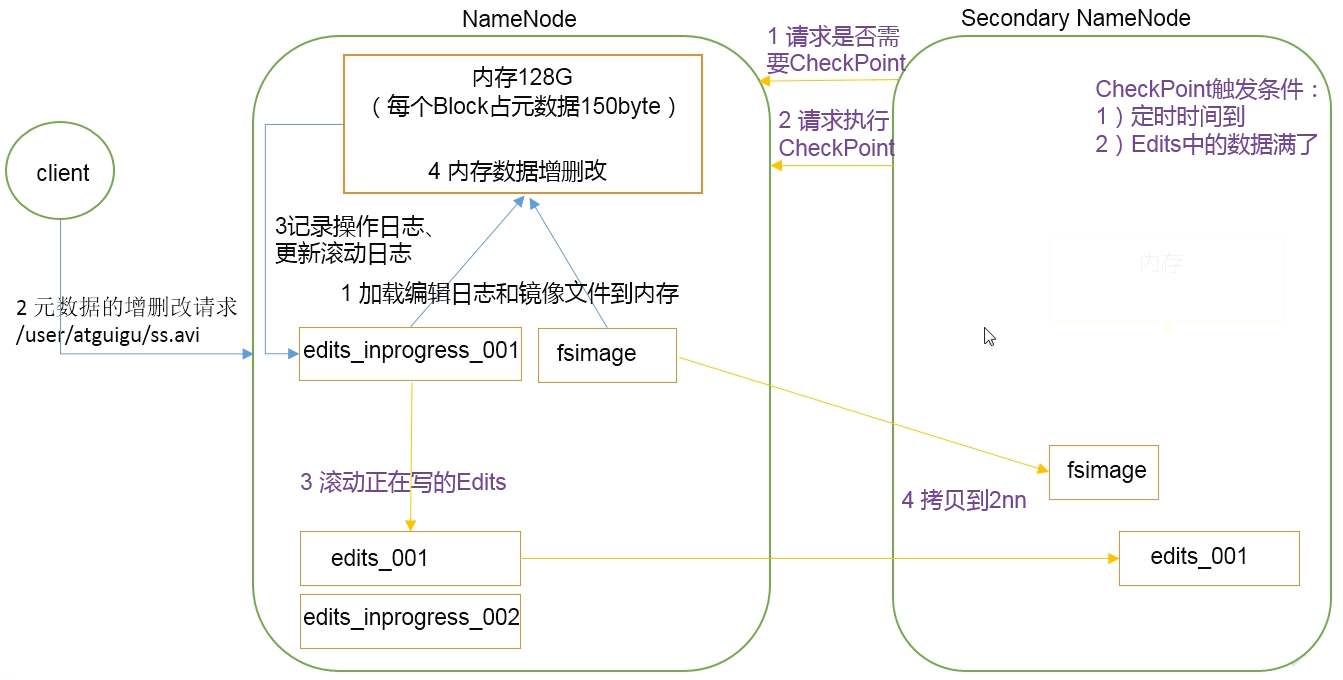

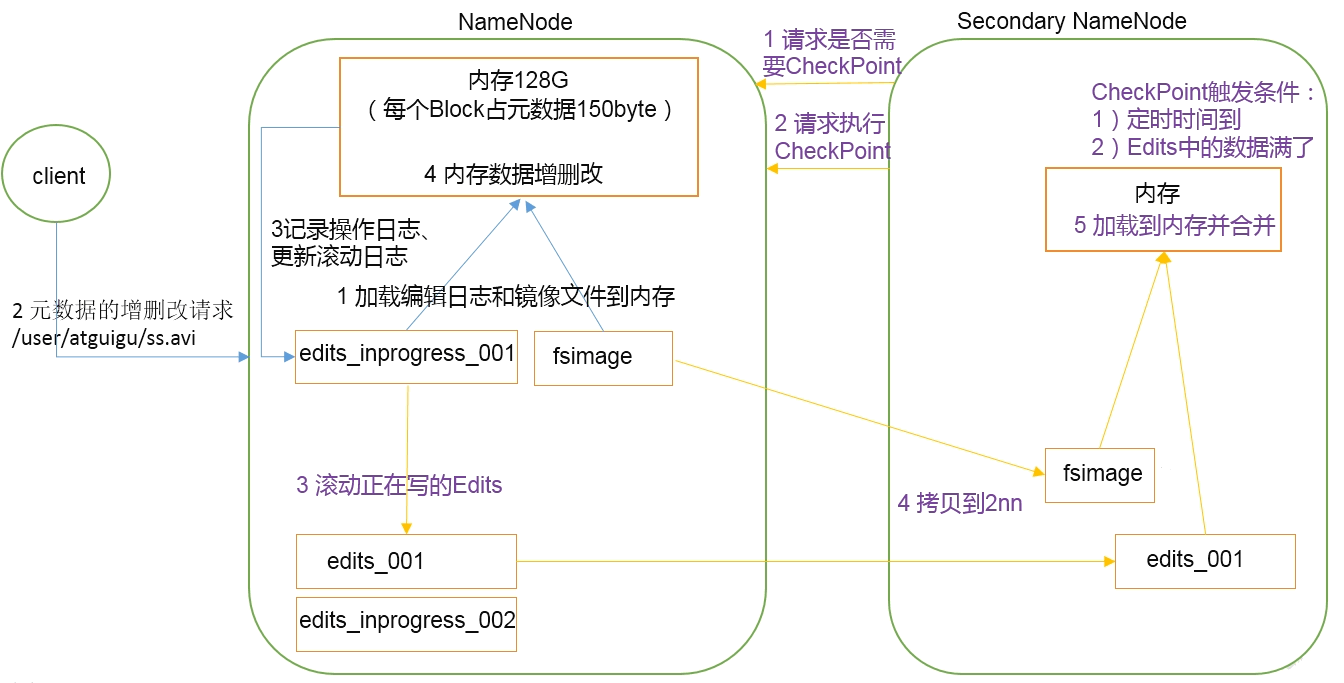

(4)将滚动前的编辑日志和镜像文件拷贝到Secondary NameNode。

(5)Secondary NameNode加载编辑日志和镜像文件到内存,并合并。

(6)生成新的镜像文件fsimage.chkpoint。

(7)拷贝fsimage.chkpoint到NameNode。

(8)NameNode将fsimage.chkpoint重新命名成fsimage。

NN和2NN工作机制详解: Fsimage:NameNode内存中元数据序列化后形成的文件。Edits:记录客户端更新元数据信息的每一步操作(可通过Edits运算出元数据)。

NameNode启动时,先滚动Edits并生成一个空的edits.inprogress,然后加载Edits和Fsimage到内存中,此时NameNode内存就持有最新的元数据信息。Client开始对NameNode发送元数据的增删改的请求,这些请求的操作首先会被记录到edits.inprogress中(查询元数据的操作不会被记录在Edits中,因为查询操作不会更改元数据信息),如果此时NameNode挂掉,重启后会从Edits中读取元数据的信息。然后,NameNode会在内存中执行元数据的增删改的操作。

由于Edits中记录的操作会越来越多,Edits文件会越来越大,导致NameNode在启动加载Edits时会很慢,所以需要对Edits和Fsimage进行合并(所谓合并,就是将Edits和Fsimage加载到内存中,照着Edits中的操作一步步执行,最终形成新的Fsimage)。SecondaryNameNode的作用就是帮助NameNode进行Edits和Fsimage的合并工作。

SecondaryNameNode首先会询问NameNode是否需要CheckPoint(触发CheckPoint需要满足两个条件中的任意一个,定时时间到和Edits中数据写满了)。直接带回NameNode是否检查结果。SecondaryNameNode执行CheckPoint操作,首先会让NameNode滚动Edits并生成一个空的edits.inprogress,滚动Edits的目的是给Edits打个标记,以后所有新的操作都写入edits.inprogress,其他未合并的Edits和Fsimage会拷贝到SecondaryNameNode的本地,然后将拷贝的Edits和Fsimage加载到内存中进行合并,生成fsimage.chkpoint,然后将fsimage.chkpoint拷贝给NameNode,重命名为Fsimage后替换掉原来的Fsimage。NameNode在启动时就只需要加载之前未合并的Edits和Fsimage即可,因为合并过的Edits中的元数据信息已经被记录在Fsimage中。

Fsimage和Edits解析 概念 NameNode被格式化之后,将在/opt/module/hadoop-2.7.2/data/tmp/dfs/name/current目录产生如下文件

1 2 3 4 fsimage_0000000000000000000.md5 fsimage_0000000000000000000.md5 seen_txid VERSION

(1) Fsimage文件: HDFS文件系统元数据的一个永久性的检查点,其中包含HDFS文件系统的所有目录和文件inode的序列化信息。

(2) Edits文件:存放HDFS文件系统的所有更新操作的路径,文件系统客户端执行的所有写操作首先会被记录到Edits文件中。

(3) seentxid 文件保存的是一个数字,就是最后一个edits 的数字。

(4)每次NameNode 启动的时候都会将Fsimage文件读入内存,加载Edits里 面的更新操作,保证内存中的元数据信息是最新的、同步的,可以看成NameNode 启动的时候就将Fsimage和Edits文件进行了合并。

将三个集群服务停止然后删除data和logs文件夹。格式化namenode。然后启动hdfs,出现新edit_inprogress_000000000000001。创建文件夹然后上传文件,

1 2 3 4 5 6 7 8 9 10 11 12 [atguigu@hadoop102 current]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs/name/current [atguigu@hadoop102 current]$ ll 总用量 1052 -rw-rw-r--. 1 atguigu atguigu 42 8月 4 15:44 edits_0000000000000000001-0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 1048576 8月 4 15:45 edits_inprogress_0000000000000000003 -rw-rw-r--. 1 atguigu atguigu 354 8月 4 15:42 fsimage_0000000000000000000 -rw-rw-r--. 1 atguigu atguigu 62 8月 4 15:42 fsimage_0000000000000000000.md5 -rw-rw-r--. 1 atguigu atguigu 354 8月 4 15:44 fsimage_0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 62 8月 4 15:44 fsimage_0000000000000000002.md5 -rw-rw-r--. 1 atguigu atguigu 2 8月 4 15:44 seen_txid -rw-rw-r--. 1 atguigu atguigu 208 8月 4 15:42 VERSION

直接使用cat查看出现乱码,因为是序列化文件。

oiv查看Fsimage文件 查看oiv和oev命令 1 2 3 [atguigu@hadoop102 current]$ hdfs oiv apply the offline fsimage viewer to an fsimage oev apply the offline edits viewer to an edits file

基本语法 1 hdfs oiv -p 文件类型 -i 镜像文件 -o 转换后文件输出路径

实操案例 1 2 [atguigu@hadoop102 current]$ hdfs oiv -p XML -i fsimage_0000000000000000000 -o fsimage-1.xml [atguigu@hadoop102 current]$ cat fsimage-1.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 <?xml version="1.0" ?> <fsimage > <NameSection > <genstampV1 > 1000</genstampV1 > <genstampV2 > 1000</genstampV2 > <genstampV1Limit > 0</genstampV1Limit > <lastAllocatedBlockId > 1073741824</lastAllocatedBlockId > <txid > 0</txid > </NameSection > <INodeSection > <lastInodeId > 16385</lastInodeId > <inode > <id > 16385</id > <type > DIRECTORY</type > <name > </name > <mtime > 0</mtime > <permission > atguigu:supergroup:rwxr-xr-x</permission > <nsquota > 9223372036854775807</nsquota > <dsquota > -1</dsquota > </inode > </INodeSection > <INodeReferenceSection > </INodeReferenceSection > <SnapshotSection > <snapshotCounter > 0</snapshotCounter > </SnapshotSection > <INodeDirectorySection > </INodeDirectorySection > <FileUnderConstructionSection > </FileUnderConstructionSection > <SnapshotDiffSection > <diff > <inodeid > 16385</inodeid > </diff > </SnapshotDiffSection > <SecretManagerSection > <currentId > 0</currentId > <tokenSequenceNumber > 0</tokenSequenceNumber > </SecretManagerSection > <CacheManagerSection > <nextDirectiveId > 1</nextDirectiveId > </CacheManagerSection > </fsimage >

此时只有一个目录的路径,没有刚才上传的文件状态。说明文件现在在edits日志文件中。

可以看出,Fsimage中没有记录块所对应DataNode。

oev查看Edits文件 基本语法 1 hdfs oev -p 文件类型 -i 编辑日记 -o 转换后后文件输出路径

案例实操 接上个案例

1 2 [atguigu@hadoop102 current]$ hdfs oev -p XML -i edits_inprogress_0000000000000000003 -o edits-1.xml [atguigu@hadoop102 current]$ cat edits-1.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 <?xml version="1.0" encoding="UTF-8" ?> <EDITS > <EDITS_VERSION > -63</EDITS_VERSION > <RECORD > <OPCODE > OP_START_LOG_SEGMENT</OPCODE > <DATA > <TXID > 3</TXID > </DATA > </RECORD > <RECORD > <OPCODE > OP_MKDIR</OPCODE > <DATA > <TXID > 4</TXID > <LENGTH > 0</LENGTH > <INODEID > 16386</INODEID > <PATH > /user</PATH > <TIMESTAMP > 1596527114560</TIMESTAMP > <PERMISSION_STATUS > <USERNAME > atguigu</USERNAME > <GROUPNAME > supergroup</GROUPNAME > <MODE > 493</MODE > </PERMISSION_STATUS > </DATA > </RECORD > <RECORD > <OPCODE > OP_MKDIR</OPCODE > <DATA > <TXID > 5</TXID > <LENGTH > 0</LENGTH > <INODEID > 16387</INODEID > <PATH > /user/atguigu</PATH > <TIMESTAMP > 1596527114570</TIMESTAMP > <PERMISSION_STATUS > <USERNAME > atguigu</USERNAME > <GROUPNAME > supergroup</GROUPNAME > <MODE > 493</MODE > </PERMISSION_STATUS > </DATA > </RECORD > <RECORD > <OPCODE > OP_MKDIR</OPCODE > <DATA > <TXID > 6</TXID > <LENGTH > 0</LENGTH > <INODEID > 16388</INODEID > <PATH > /user/atguigu/input</PATH > <TIMESTAMP > 1596527114571</TIMESTAMP > <PERMISSION_STATUS > <USERNAME > atguigu</USERNAME > <GROUPNAME > supergroup</GROUPNAME > <MODE > 493</MODE > </PERMISSION_STATUS > </DATA > </RECORD > <RECORD > <OPCODE > OP_ADD</OPCODE > <DATA > <TXID > 7</TXID > <LENGTH > 0</LENGTH > <INODEID > 16389</INODEID > <PATH > /user/atguigu/input/README.txt._COPYING_</PATH > <REPLICATION > 3</REPLICATION > <MTIME > 1596527135651</MTIME > <ATIME > 1596527135651</ATIME > <BLOCKSIZE > 134217728</BLOCKSIZE > <CLIENT_NAME > DFSClient_NONMAPREDUCE_-99231412_1</CLIENT_NAME > <CLIENT_MACHINE > 192.168.228.102</CLIENT_MACHINE > <OVERWRITE > true</OVERWRITE > <PERMISSION_STATUS > <USERNAME > atguigu</USERNAME > <GROUPNAME > supergroup</GROUPNAME > <MODE > 420</MODE > </PERMISSION_STATUS > <RPC_CLIENTID > f3c4b912-3a97-4d18-af16-e47a4ad530eb</RPC_CLIENTID > <RPC_CALLID > 3</RPC_CALLID > </DATA > </RECORD > <RECORD > <OPCODE > OP_ALLOCATE_BLOCK_ID</OPCODE > <DATA > <TXID > 8</TXID > <BLOCK_ID > 1073741825</BLOCK_ID > </DATA > </RECORD > <RECORD > <OPCODE > OP_SET_GENSTAMP_V2</OPCODE > <DATA > <TXID > 9</TXID > <GENSTAMPV2 > 1001</GENSTAMPV2 > </DATA > </RECORD > <RECORD > <OPCODE > OP_ADD_BLOCK</OPCODE > <DATA > <TXID > 10</TXID > <PATH > /user/atguigu/input/README.txt._COPYING_</PATH > <BLOCK > <BLOCK_ID > 1073741825</BLOCK_ID > <NUM_BYTES > 0</NUM_BYTES > <GENSTAMP > 1001</GENSTAMP > </BLOCK > <RPC_CLIENTID > </RPC_CLIENTID > <RPC_CALLID > -2</RPC_CALLID > </DATA > </RECORD > <RECORD > <OPCODE > OP_CLOSE</OPCODE > <DATA > <TXID > 11</TXID > <LENGTH > 0</LENGTH > <INODEID > 0</INODEID > <PATH > /user/atguigu/input/README.txt._COPYING_</PATH > <REPLICATION > 3</REPLICATION > <MTIME > 1596527136685</MTIME > <ATIME > 1596527135651</ATIME > <BLOCKSIZE > 134217728</BLOCKSIZE > <CLIENT_NAME > </CLIENT_NAME > <CLIENT_MACHINE > </CLIENT_MACHINE > <OVERWRITE > false</OVERWRITE > <BLOCK > <BLOCK_ID > 1073741825</BLOCK_ID > <NUM_BYTES > 1366</NUM_BYTES > <GENSTAMP > 1001</GENSTAMP > </BLOCK > <PERMISSION_STATUS > <USERNAME > atguigu</USERNAME > <GROUPNAME > supergroup</GROUPNAME > <MODE > 420</MODE > </PERMISSION_STATUS > </DATA > </RECORD > <RECORD > <OPCODE > OP_RENAME_OLD</OPCODE > <DATA > <TXID > 12</TXID > <LENGTH > 0</LENGTH > <SRC > /user/atguigu/input/README.txt._COPYING_</SRC > <DST > /user/atguigu/input/README.txt</DST > <TIMESTAMP > 1596527136694</TIMESTAMP > <RPC_CLIENTID > f3c4b912-3a97-4d18-af16-e47a4ad530eb</RPC_CLIENTID > <RPC_CALLID > 9</RPC_CALLID > </DATA > </RECORD > </EDITS >

可以看到创建文件夹和上传文件命令。OP_ADD,OP_ALLOCATE_BLOCK_ID,OP_SET_GENSTAMP_V2,OP_ADD_BLOCK,OP_CLOSE,OP_RENAME_OLD。

NameNode如何确定下次开机启动的时候合并哪些Edits?seen_txid记录最新的edits。

CheckPoint时间设置

(1)通常情况下,SecondaryNameNode每隔一小时执行一次。

hdfs-default.xml

1 2 3 4 <property > <name > dfs.namenode.checkpoint.period</name > <value > 3600</value > </property >

(2)一分钟检查一次操作次数,3当操作次数达到1百万时,SecondaryNameNode执行一次。

1 2 3 4 5 6 7 8 9 10 11 <property > <name > dfs.namenode.checkpoint.txns</name > <value > 1000000</value > <description > 操作动作次数</description > </property > <property > <name > dfs.namenode.checkpoint.check.period</name > <value > 60</value > <description > 1分钟检查一次操作次数</description > </property >

NameNode故障处理 NameNode故障后,可以采用如下两种方法恢复数据。

方法一:将SecondaryNameNode中数据拷贝到NameNode存储数据的目录;

1 2 3 4 5 6 7 8 9 10 [atguigu@hadoop102 sbin]$ jps 3745 NameNode 3893 DataNode 4359 Jps 4233 NodeManager [atguigu@hadoop102 sbin]$ kill -9 3745 [atguigu@hadoop102 sbin]$ jps 4371 Jps 3893 DataNode 4233 NodeManager

删除NameNode存储的数据(/opt/module/hadoop-2.7.2/data/tmp/dfs/name)

1 [atguigu@hadoop102 hadoop-2.7.2]$ rm -rf /opt/module/hadoop-2.7.2/data/tmp/dfs/name/*

拷贝SecondaryNameNode中数据到原NameNode存储数据目录

1 2 3 [atguigu@hadoop102 name]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs/name [atguigu@hadoop102 name]$ scp -r atguigu@hadoop104:/opt/module/hadoop-2.7.2/data/tmp/dfs/namesecondary/* ./

1 [atguigu@hadoop102 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start namenode

方法二:使用-importCheckpoint选项启动NameNode守护进程,从而将SecondaryNameNode中数据拷贝到NameNode目录中。

1 [atguigu@hadoop102 hadoop-2.7.2]$ vim etc/hadoop/hdfs-site.xml

减少存盘检查时间

1 2 3 4 5 6 7 8 9 <property > <name > dfs.namenode.checkpoint.period</name > <value > 120</value > </property > <property > <name > dfs.namenode.name.dir</name > <value > /opt/module/hadoop-2.7.2/data/tmp/dfs/name</value > </property >

1 [atguigu@hadoop102 hadoop-2.7.2]$ xsync etc/hadoop/

1 2 3 4 5 6 7 8 9 10 [atguigu@hadoop102 hadoop-2.7.2]$ jps 6962 Jps 3893 DataNode 4424 NameNode 4233 NodeManager [atguigu@hadoop102 hadoop-2.7.2]$ kill -9 3893 [atguigu@hadoop102 hadoop-2.7.2]$ jps 4424 NameNode 4233 NodeManager 6974 Jps

3.删除NameNode存储的数据(/opt/module/hadoop-2.7.2/data/tmp/dfs/name)

1 [atguigu@hadoop102 hadoop-2.7.2]$ rm -rf /opt/module/hadoop-2.7.2/data/tmp/dfs/name/*

4.如果SecondaryNameNode不和NameNode在一个主机节点上,需要将SecondaryNameNode存储数据的目录拷贝到NameNode存储数据的平级目录,并删除in_use.lock文件

1 2 3 4 5 6 7 8 9 10 11 12 13 [atguigu@hadoop102 dfs]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs [atguigu@hadoop102 dfs]$ scp -r atguigu@hadoop104:/opt/module/hadoop-2.7.2/data/tmp/dfs/namesecondary ./ [atguigu@hadoop102 namesecondary]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs/namesecondary [atguigu@hadoop102 namesecondary]$ rm -rf in_use.lock [atguigu@hadoop102 dfs]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs [atguigu@hadoop102 dfs]$ ls data name namesecondary

1 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hdfs namenode -importCheckpoint

1 [atguigu@hadoop102 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start namenode

集群安全模式 概述 1、NameNode启动

NameNode启动时,首先将镜像文件(Fsimage) 载入内存,并执行编辑日志(Edits) 中的各项操作。一旦在内存中成功建立文件系统元数据的映像,则创建一个新的Fsimage文件和一个空的编辑日志。此时,NameNode开始监听DataNode请求。

2、DataNode启动

系统中的数据块的位置并不是由NameNode维护的,而是以块列表的形式存储在DataNode中。

3、安全模式退出判断

如果满足“最小副本条件”,NameNode会在30秒钟之后就退出安全模式。

基本语法 集群处于安全模式,不能执行重要操作(写操作)。集群启动完成后,自动退出安全模式。

(1)bin/hdfs dfsadmin -safemode get (功能描述:查看安全模式状态)bin/hdfs dfsadmin -safemode enter (功能描述:进入安全模式状态)bin/hdfs dfsadmin -safemode leave (功能描述:离开安全模式状态)bin/hdfs dfsadmin -safemode wait (功能描述:等待安全模式状态)

案例 模拟等待安全模式

退出安全模式之后立马干一些事情。

可在http://hadoop102:50070/dfshealth.html#tab-overview浏览器端查看Safemode状态。

(1)查看当前模式

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfsadmin -safemode get Safe mode is OFF

(2)先进入安全模式

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hdfs dfsadmin -safemode enter Safe mode is ON

安全模式下不允许上传

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hdfs dfs -put README.txt / put: Cannot create file/README.txt._COPYING_. Name node is in safe mode.

(3)创建并执行下面的脚本

在/opt/module/hadoop-2.7.2路径上,编辑一个脚本safemode.sh

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ touch safemode.sh [atguigu@hadoop102 hadoop-2.7.2]$ vim safemode.sh

1 2 3 # !/bin/bash hdfs dfsadmin -safemode wait hdfs dfs -put /opt/module/hadoop-2.7.2/README.txt /

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ chmod 777 safemode.sh [atguigu@hadoop102 hadoop-2.7.2]$ ./safemode.sh

(4)再打开一个窗口,执行

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hdfs dfsadmin -safemode leave Safe mode is OFF

NameNode多目录配置 先停止节点服务并且删除data和logs

NameNode的本地目录可以配置成多个,且每个目录存放内容相同,增加了可靠性。

具体配置 (1)在hdfs-site.xml文件中增加如下内容

1 [atguigu@hadoop102 hadoop-2.7.2]$ vim etc/hadoop/hdfs-site.xml

1 2 3 4 <property > <name > dfs.namenode.name.dir</name > <value > file:///${hadoop.tmp.dir}/dfs/name1,file:///${hadoop.tmp.dir}/dfs/name2</value > </property >

1 [atguigu@hadoop102 hadoop-2.7.2]$ xsync etc/hadoop/

(2)停止集群,删除data和logs中所有数据。

1 2 3 [atguigu@hadoop102 hadoop-2.7.2]$ rm -rf data/ logs/ [atguigu@hadoop103 hadoop-2.7.2]$ rm -rf data/ logs/ [atguigu@hadoop104 hadoop-2.7.2]$ rm -rf data/ logs/

(3)格式化集群并启动。

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hdfs namenode –format [atguigu@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh

(4)查看结果

1 2 3 4 5 6 7 [atguigu@hadoop102 dfs]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs [atguigu@hadoop102 dfs]$ ll 总用量 12 drwx------. 3 atguigu atguigu 4096 12月 11 08:03 data drwxrwxr-x. 3 atguigu atguigu 4096 12月 11 08:03 name1 drwxrwxr-x. 3 atguigu atguigu 4096 12月 11 08:03 name2

(5)上传测试

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -put README.txt / [atguigu@hadoop102 current]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs/name2/current [atguigu@hadoop102 current]$ ll 总用量 1052 -rw-rw-r--. 1 atguigu atguigu 42 8月 8 22:07 edits_0000000000000000001-0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 1048576 8月 8 22:09 edits_inprogress_0000000000000000003 -rw-rw-r--. 1 atguigu atguigu 354 8月 8 22:05 fsimage_0000000000000000000 -rw-rw-r--. 1 atguigu atguigu 62 8月 8 22:05 fsimage_0000000000000000000.md5 -rw-rw-r--. 1 atguigu atguigu 354 8月 8 22:07 fsimage_0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 62 8月 8 22:07 fsimage_0000000000000000002.md5 -rw-rw-r--. 1 atguigu atguigu 2 8月 8 22:07 seen_txid -rw-rw-r--. 1 atguigu atguigu 206 8月 8 22:05 VERSION [atguigu@hadoop102 current]$ pwd /opt/module/hadoop-2.7.2/data/tmp/dfs/name1/current [atguigu@hadoop102 current]$ ll 总用量 1052 -rw-rw-r--. 1 atguigu atguigu 42 8月 8 22:07 edits_0000000000000000001-0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 1048576 8月 8 22:09 edits_inprogress_0000000000000000003 -rw-rw-r--. 1 atguigu atguigu 354 8月 8 22:05 fsimage_0000000000000000000 -rw-rw-r--. 1 atguigu atguigu 62 8月 8 22:05 fsimage_0000000000000000000.md5 -rw-rw-r--. 1 atguigu atguigu 354 8月 8 22:07 fsimage_0000000000000000002 -rw-rw-r--. 1 atguigu atguigu 62 8月 8 22:07 fsimage_0000000000000000002.md5 -rw-rw-r--. 1 atguigu atguigu 2 8月 8 22:07 seen_txid -rw-rw-r--. 1 atguigu atguigu 206 8月 8 22:05 VERSION

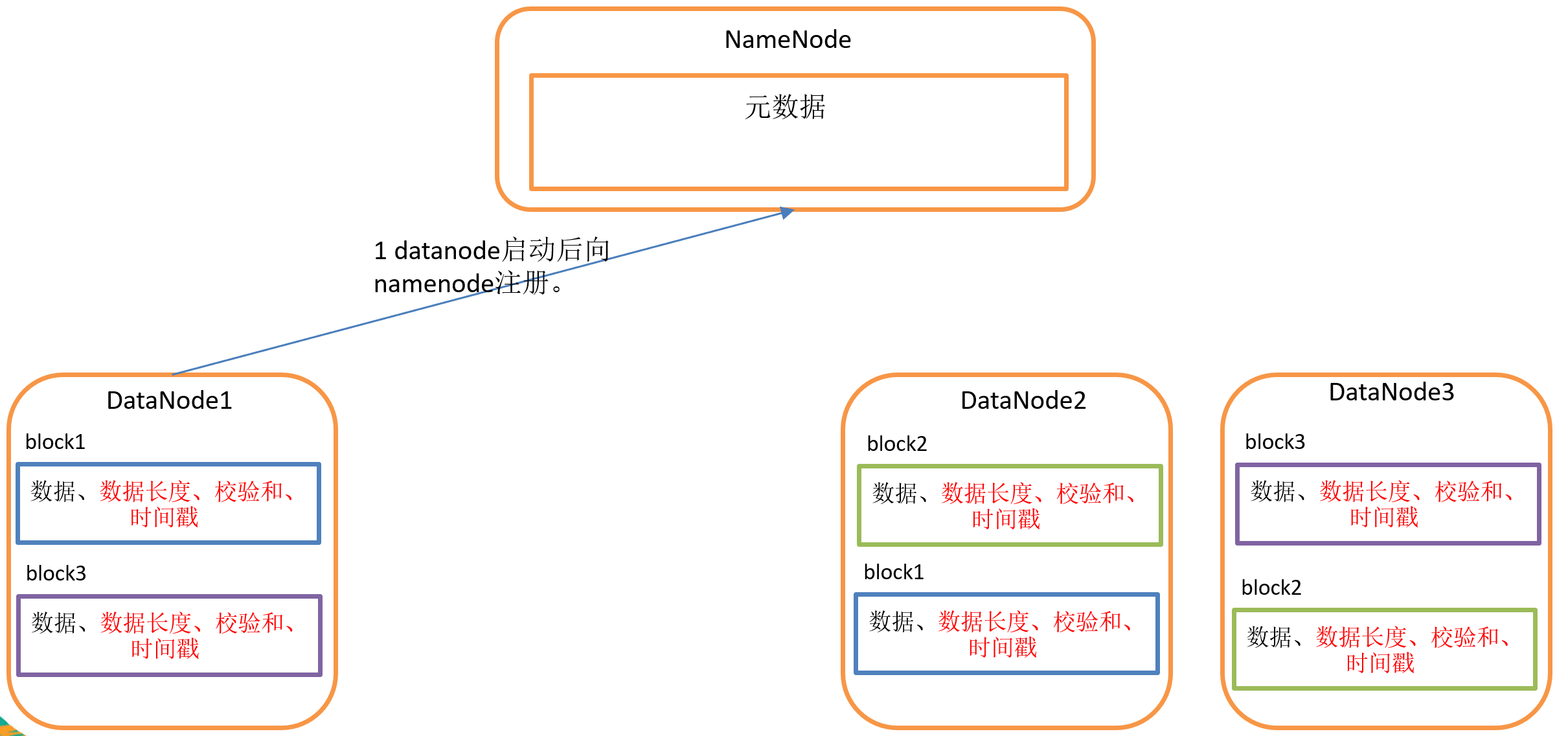

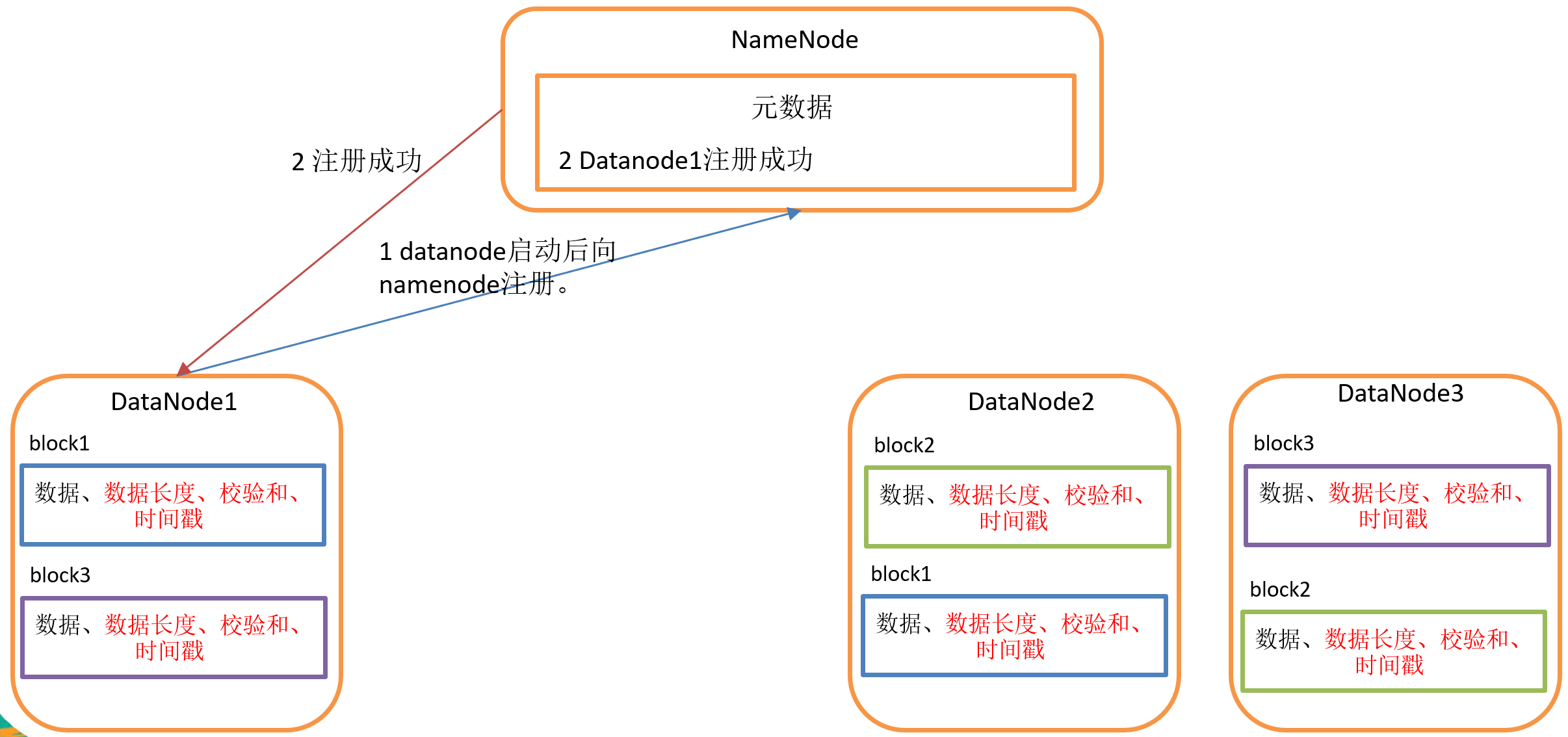

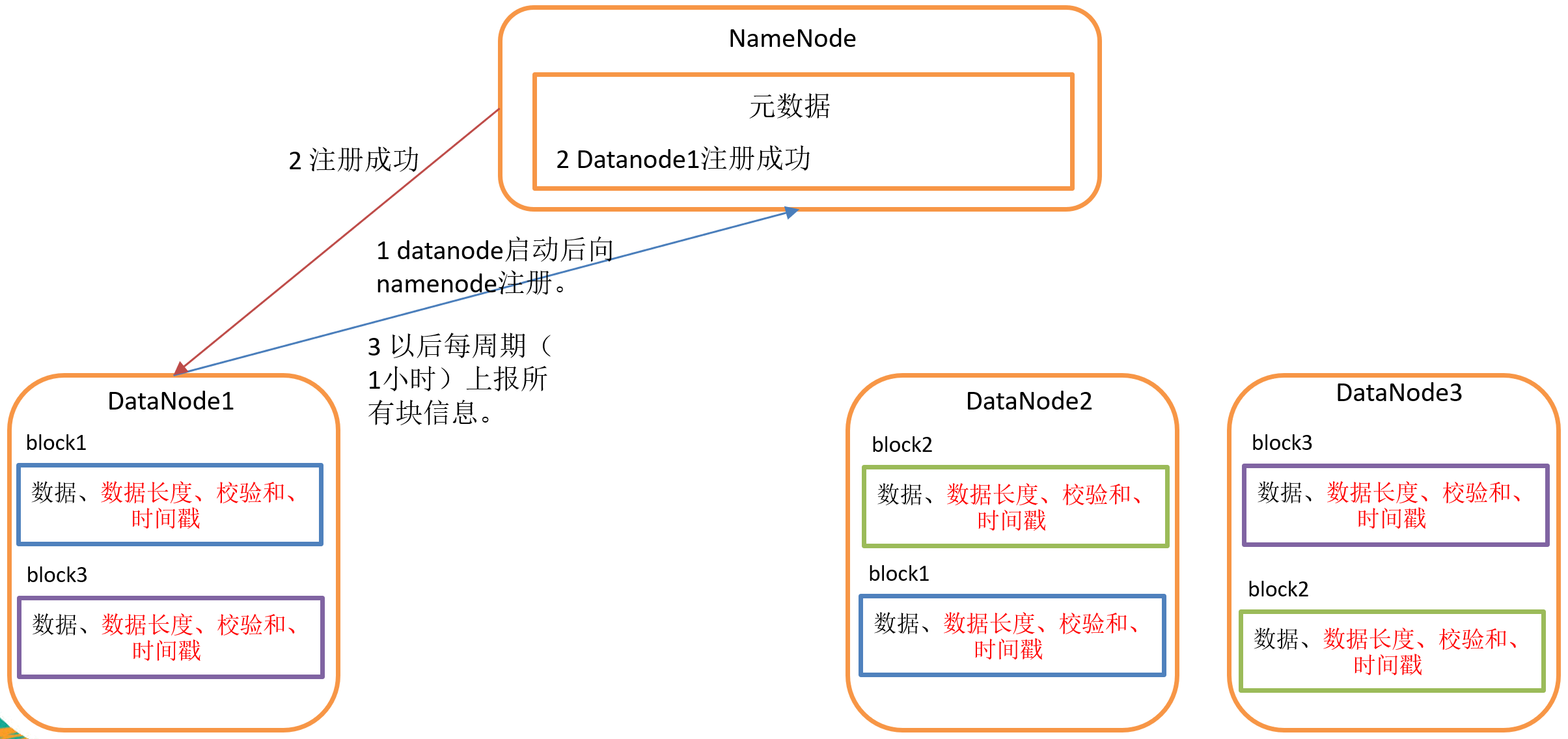

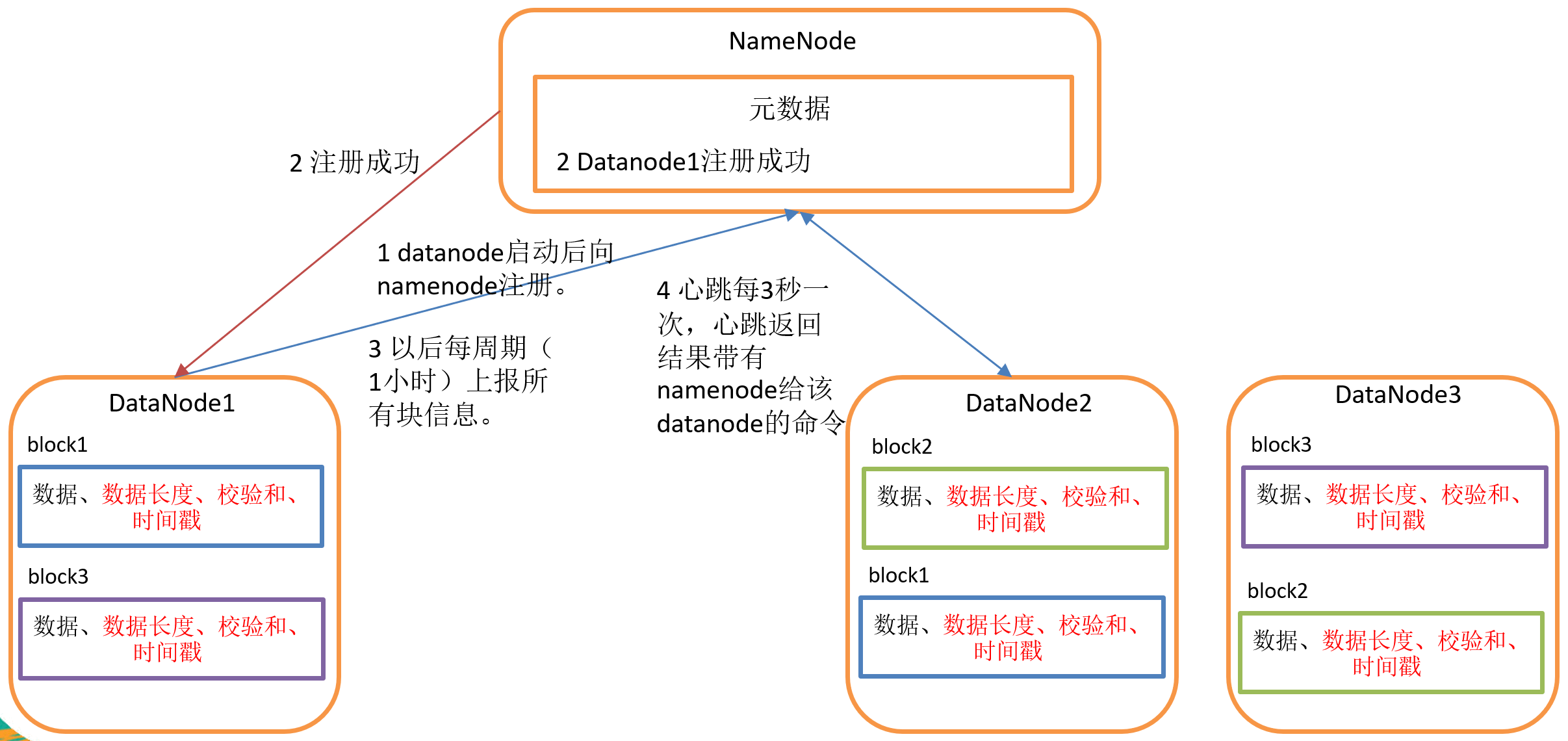

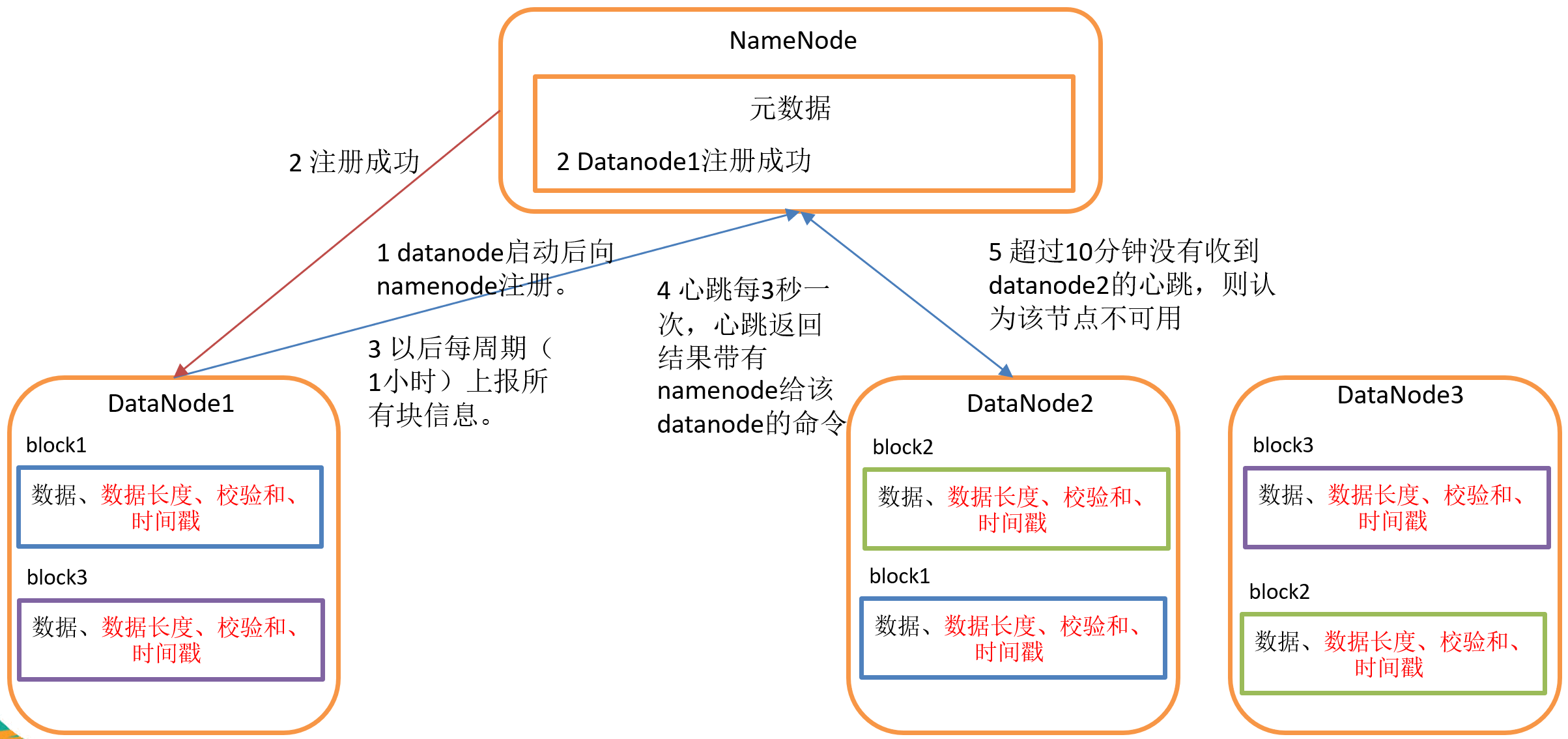

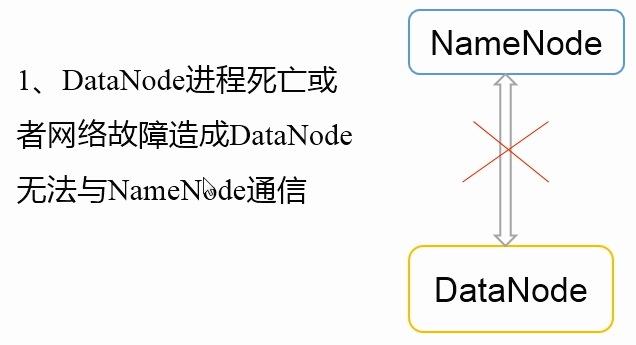

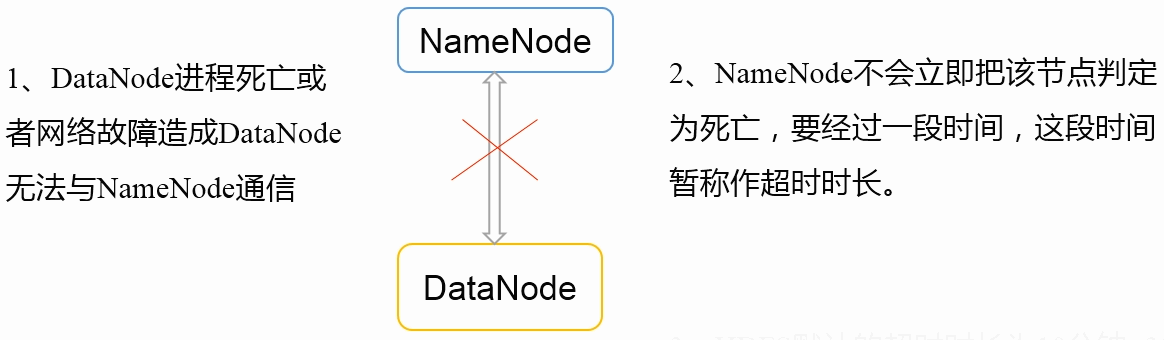

DataNode※ DataNode工作机制 1)一个数据块在DataNode上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据包括数据块的长度,块数据的校验和,以及时间戳。

2)DataNode启动后向NameNode注册,通过后,周期性(1小时)的向NameNode上报所有的块信息。

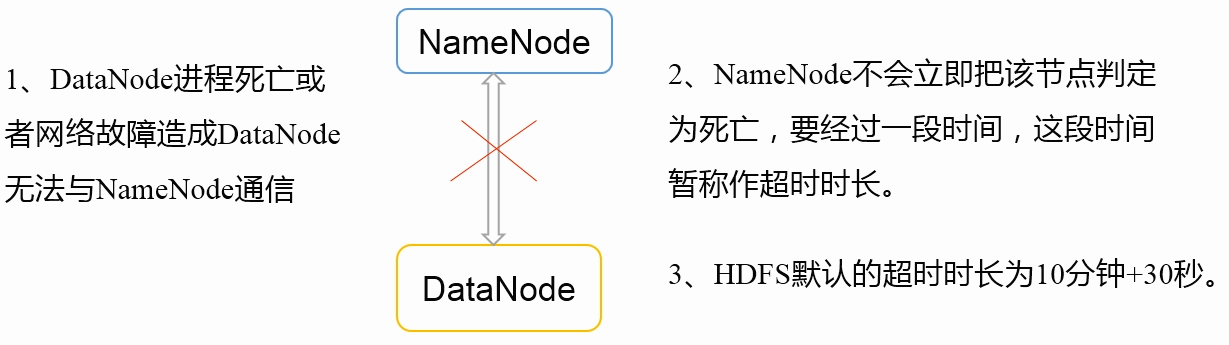

3)心跳是每3秒一次,心跳返回结果带有NameNode给该DataNode的命令如复制块数据到另一台机器,或删除某个数据块。如果超过10分钟30秒没有收到某个DataNode的心跳,则认为该节点不可用。(只有重启之后才可以工作)

4)集群运行中可以安全加入和退出一些机器。

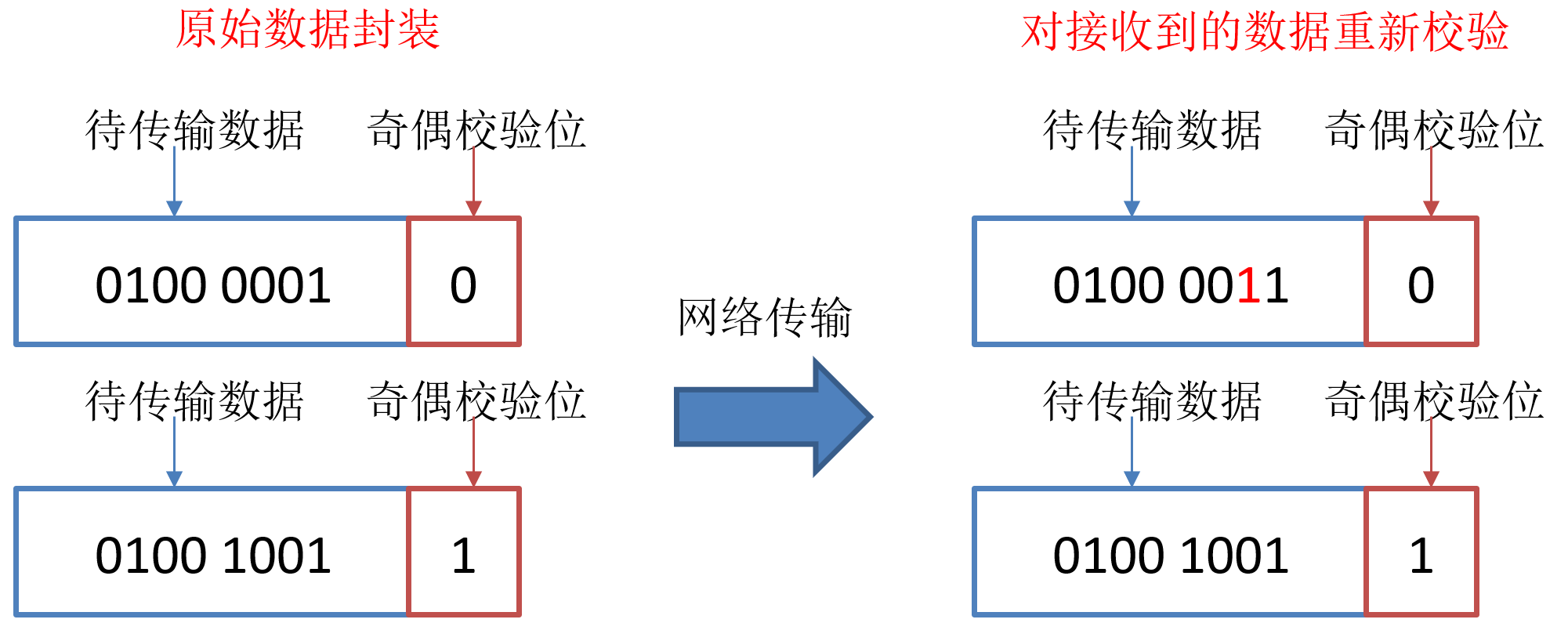

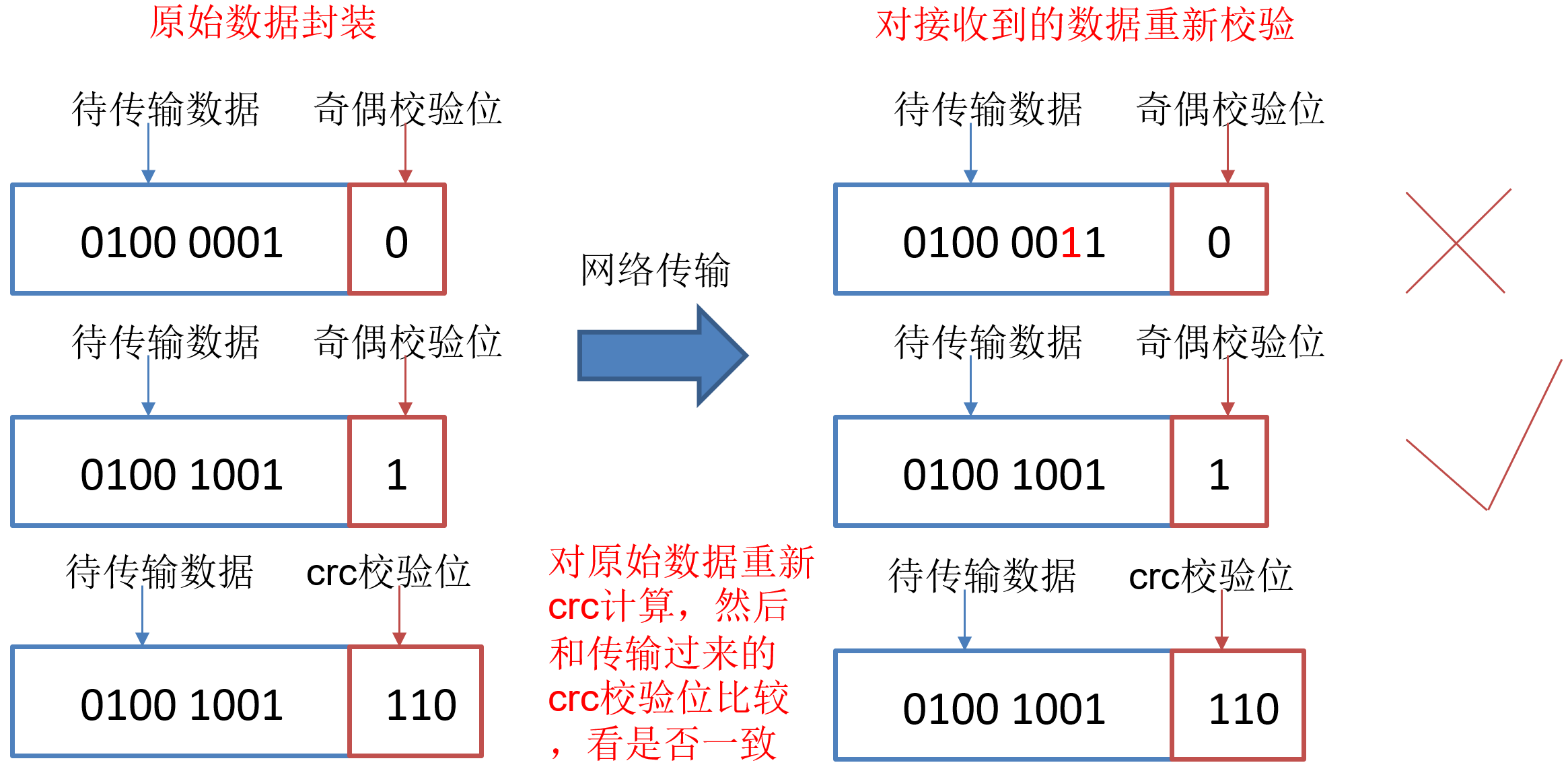

数据完整性

思考:如果电脑磁盘里面存储的数据是控制高铁信号灯的红灯信号(1)和绿灯信号(0),但是存储该数据的磁盘坏了,一直显示是绿灯,是否很危险?同理DataNode节点上的数据损坏了,却没有发现,是否也很危险,那么如何解决呢?

奇偶校验验证数据完整性:

crc校验:

如下是DataNode节点保证数据完整性的方法。

1)当DataNode读取Block的时候,它会计算CheckSum。

2)如果计算后的CheckSum,与Block创建时值不一样,说明Block已经损坏。

3)Client读取其他DataNode上的Block。

4)DataNode在其文件创建后周期验证CheckSum。

掉线时限参数设置 需要注意的是hdfs-site.xml 配置文件中的heartbeat.recheck.interval的单位为毫秒,dfs.heartbeat.interval的单位为秒。

1 2 3 4 5 6 7 8 <property > <name > dfs.namenode.heartbeat.recheck-interval</name > <value > 300000</value > </property > <property > <name > dfs.heartbeat.interval</name > <value > 3</value > </property >

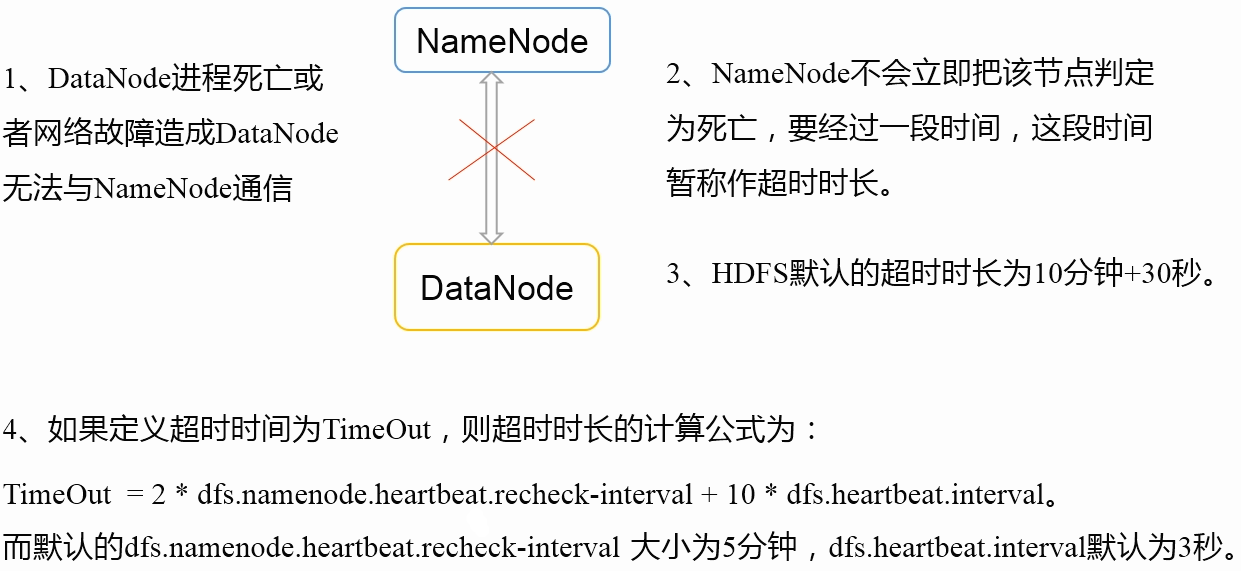

服役新数据节点 需求 随着公司业务的增长,数据量越来越大,原有的数据节点的容量已经不能满足存储数据的需求,需要在原有集群基础上动态添加新的数据节点。

环境准备 (1)在hadoop104主机上再克隆一台hadoop105主机

web浏览器端可以看到datanodes列表。在没有删除原来数据前启动hadoop105会导致,104和105会相互变化,因为104和105的配置相同。

(4)source一下配置文件

1 2 3 [atguigu@hadoop105 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start datanode [atguigu@hadoop105 hadoop-2.7.2]$ sbin/yarn-daemon.sh start nodemanager [atguigu@hadoop105 hadoop-2.7.2]$ source /etc/profile

如果想要下次启动加入该节点,需要配置集群群起步骤并设置ssh

服役新节点具体步骤 (1)直接启动DataNode,即可关联到集群

1 2 [atguigu@hadoop105 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start datanode [atguigu@hadoop105 hadoop-2.7.2]$ sbin/yarn-daemon.sh start nodemanager

(2)在hadoop105上上传文件

1 2 3 [atguigu@hadoop105 hadoop-2.7.2]$ hadoop fs -mkdir -p /user/atguigu/input [atguigu@hadoop105 hadoop-2.7.2]$ hadoop fs -put README.txt /user/atguigu/input [atguigu@hadoop105 hadoop-2.7.2]$ hadoop fs -put /opt/module/hadoop-2.7.2/LICENSE.txt /

(3)如果数据不均衡,可以用命令实现集群的再平衡

1 2 3 [atguigu@hadoop102 sbin]$ ./start-balancer.sh starting balancer, logging to /opt/module/hadoop-2.7.2/logs/hadoop-atguigu-balancer-hadoop102.out Time Stamp Iteration

如果第三方设置一台与节点相同配置的服务器,挂载后即可下载数据到本节点,存在风险漏洞。

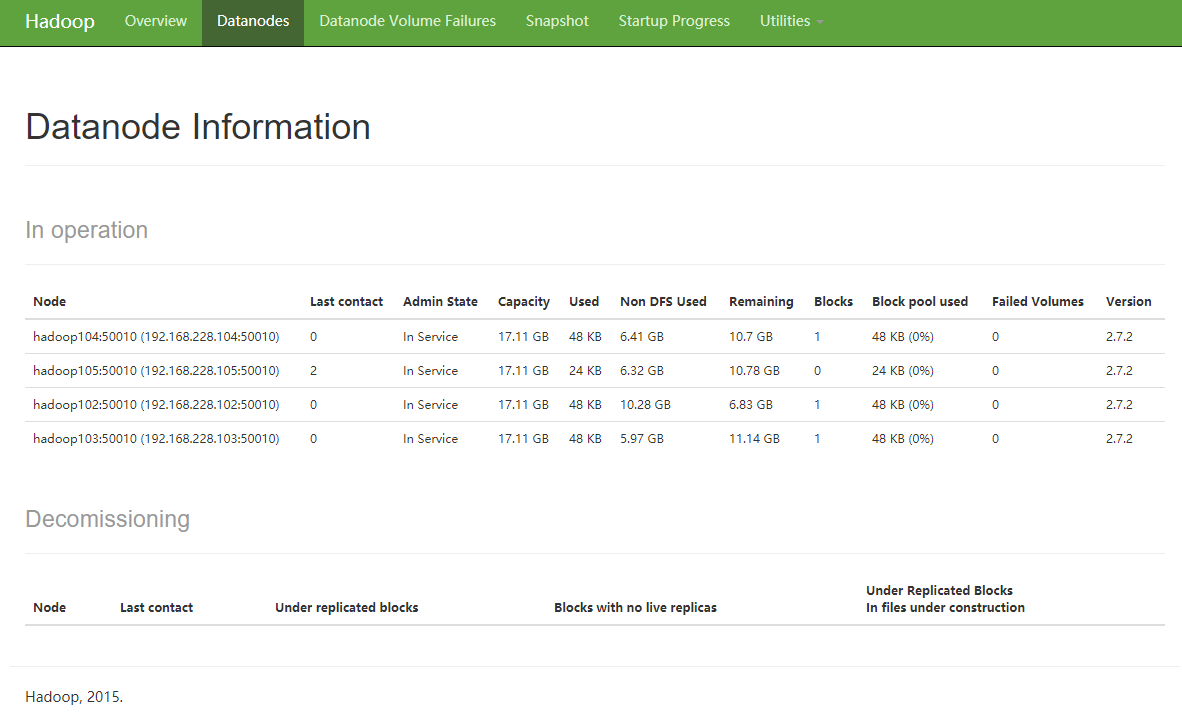

退役旧数据节点 添加白名单(较安全) 添加到白名单的主机节点,都允许访问NameNode,不在白名单的主机节点,都会被退出。

配置白名单的具体步骤如下:

(1)在NameNode的/opt/module/hadoop-2.7.2/etc/hadoop目录下创建dfs.hosts文件(文件名称可以不固定)

1 2 3 4 5 6 7 8 [atguigu@hadoop102 hadoop]$ pwd /opt/module/hadoop-2.7.2/etc/hadoop [atguigu@hadoop102 hadoop]$ touch dfs.hosts [atguigu@hadoop102 hadoop]$ vim dfs.hosts 添加如下主机名称(不添加hadoop105) hadoop102 hadoop103 hadoop104

(2)在NameNode的hdfs-site.xml配置文件中增加dfs.hosts属性

1 2 3 4 <property > <name > dfs.hosts</name > <value > /opt/module/hadoop-2.7.2/etc/hadoop/dfs.hosts</value > </property >

(3)配置文件分发

1 [atguigu@hadoop102 hadoop]$ xsync hdfs-site.xml

(4)刷新NameNode

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfsadmin -refreshNodes Refresh nodes successful

(5)更新ResourceManager节点

1 2 [atguigu@hadoop102 hadoop]$ yarn rmadmin -refreshNodes 20/08/21 23:03:01 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.228.103:8033

(6)在web浏览器上查看

hadoop105节点已经被干掉。

(7)如果数据不均衡,可以用命令实现集群的再平衡

1 2 3 [atguigu@hadoop102 sbin]$ ./start-balancer.sh starting balancer, logging to /opt/module/hadoop-2.7.2/logs/hadoop-atguigu-balancer-hadoop102.out Time Stamp Iteration

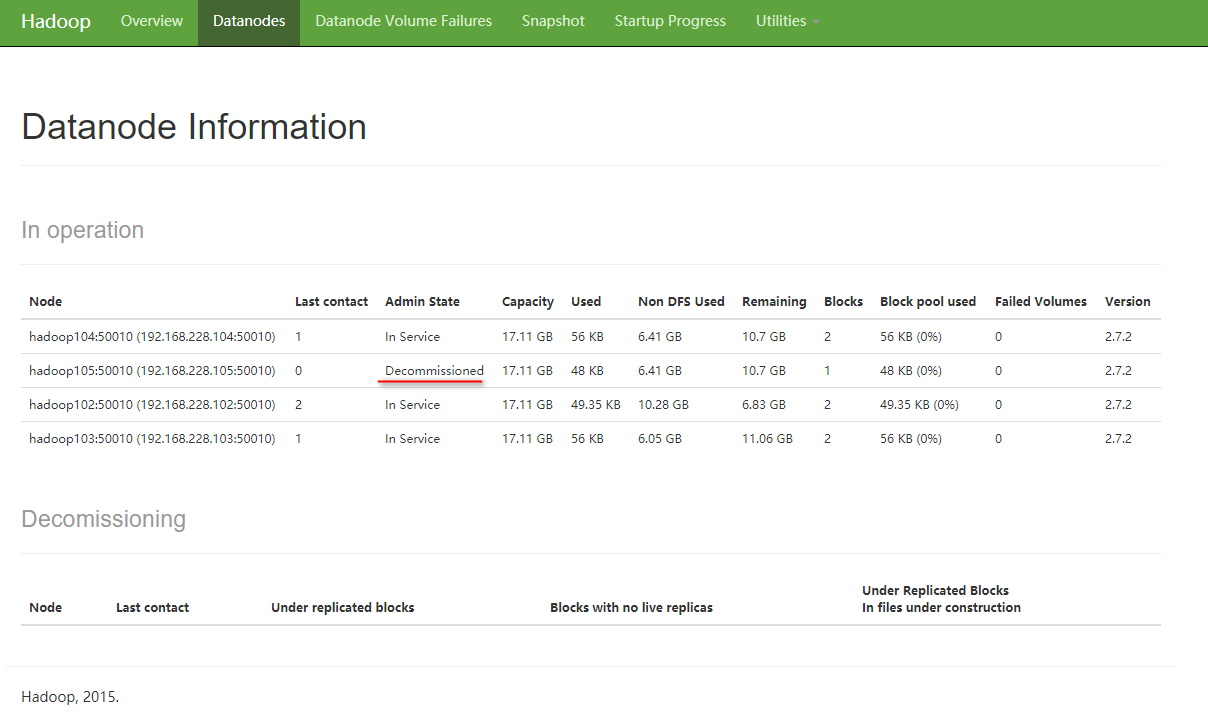

黑名单退役(标准程序) 在黑名单上面的主机都会被强制退出。

白不允许白名单和黑名单中同时出现同一个主机名称。

NameNode的/opt/module/hadoop-2.7.2/etc/hadoop目录下创建dfs.hosts.exclude文件

1 2 3 4 5 6 [atguigu@hadoop102 hadoop]$ pwd /opt/module/hadoop-2.7.2/etc/hadoop [atguigu@hadoop102 hadoop]$ touch dfs.hosts.exclude [atguigu@hadoop102 hadoop]$ vim dfs.hosts.exclude 添加如下主机名称(要退役的节点) hadoop105

2.在NameNode的hdfs-site.xml配置文件中增加dfs.hosts.exclude属性

1 2 3 4 <property > <name > dfs.hosts.exclude</name > <value > /opt/module/hadoop-2.7.2/etc/hadoop/dfs.hosts.exclude</value > </property >

3.刷新NameNode、刷新ResourceManager

1 2 3 4 5 [atguigu@hadoop102 hadoop]$ xsync hdfs-site.xml [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfsadmin -refreshNodes Refresh nodes successful [atguigu@hadoop102 hadoop]$ yarn rmadmin -refreshNodes 20/08/21 23:41:12 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.228.103:8033

检查Web浏览器,退役节点的状态为decommission in progress(退役中),说明数据节点正在复制块到其他节点。

等待退役节点状态为decommissioned(所有块已经复制完成),停止该节点及节点资源管理器。

注意:如果副本数是3,服役的节点小于等于3,是不能退役成功的,需要修改副本数后才能退役。

此时只是正常退役,但是节点列表还可以读取到。

1 2 3 4 [atguigu@hadoop105 hadoop-2.7.2]$ sbin/hadoop-daemon.sh stop datanode stopping datanode [atguigu@hadoop105 hadoop-2.7.2]$ sbin/yarn-daemon.sh stop nodemanager stopping nodemanager

关掉节点之后,开始进行last contact计时,重新启动节点之后不再显示该节点。

如果数据不均衡,可以用命令实现集群的再平衡

1 2 3 [atguigu@hadoop102 hadoop-2.7.2]$ sbin/start-balancer.sh starting balancer, logging to /opt/module/hadoop-2.7.2/logs/hadoop-atguigu-balancer-hadoop102.out Time Stamp Iteration

Datanode多目录配置

DataNode也可以配置成多个目录,每个目录存储的数据不一样。即:数据不是副本

2.具体配置如下

hdfs-site.xml

1 2 3 4 <property > <name > dfs.datanode.data.dir</name > <value > file:///${hadoop.tmp.dir}/dfs/data1,file:///${hadoop.tmp.dir}/dfs/data2</value > </property >

需要集群全部停止然后删除数据重新配置,格式化,启动服务。

HDFS 2.X新特性 集群间数据拷贝 1.scp实现两个远程主机之间的文件复制

1 2 3 scp -r hello.txt root@hadoop103:/user/atguigu/hello.txt // 推 push scp -r root@hadoop103:/user/atguigu/hello.txt hello.txt // 拉 pull scp -r root@hadoop103:/user/atguigu/hello.txt root@hadoop104:/user/atguigu //是通过本地主机中转实现两个远程主机的文件复制;如果在两个远程主机之间ssh没有配置的情况下可以使用该方式。

2.采用distcp命令实现两个Hadoop集群之间的递归数据复制

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ bin/hadoop distcp hdfs://haoop102:9000/user/atguigu/hello.txt hdfs://hadoop103:9000/user/atguigu/hello.txt

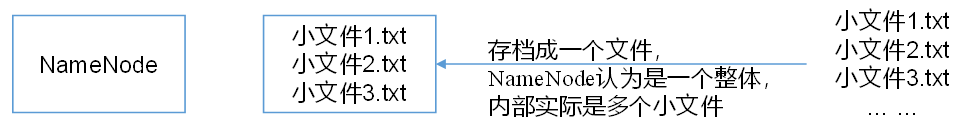

小文件存档 HDFS存储小文件弊端 每个文件均按块存储,每个块的元数据存储在NameNode的内存中,因此HDFS存储小文件会非常低效。因为大量的小文件会耗尽NameNode中的大部分内存。但注意,存储小文件所需要的磁盘容量和数据块的大小无关。

例如,一个1MB的文件设置为128MB的块存储,实际使用的是1MB的磁盘空间,而不是128MB。

解决存储小文件办法之一 HDFS存档文件或HAR文件,是一个更高效的文件存档工具,它将文件存入HDFS块,在减少NameNode内存使用的同时,允许对文件进行透明的访问。

具体说来,HDFS存档文件对内还是一个一个独立文件,对NameNode而言却是一个整体, 减少了NameNode的内存。

案例实操 (1)需要启动YARN进程

1 [atguigu@hadoop102 hadoop-2.7.2]$ start-yarn.sh

(2)归档文件

把/user/atguigu/input目录里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/user/atguigu/output路径下。

1 2 3 archive -archiveName NAME -p <parent path> <src>* <dest> create a hadoop archive [atguigu@hadoop102 hadoop-2.7.2]$ hadoop archive -archiveName input.har -p /user/atguigu/input /user/atguigu/output

(3)查看归档

har协议使用har解析,否则查看是一个整体。

1 2 3 4 5 6 7 8 9 10 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -ls -R /user/atguigu/output/input.har -rw-r--r-- 3 atguigu supergroup 0 2020-08-22 17:26 /user/atguigu/output/input.har/_SUCCESS -rw-r--r-- 5 atguigu supergroup 302 2020-08-22 17:26 /user/atguigu/output/input.har/_index -rw-r--r-- 5 atguigu supergroup 23 2020-08-22 17:26 /user/atguigu/output/input.har/_masterindex -rw-r--r-- 3 atguigu supergroup 1414 2020-08-22 17:26 /user/atguigu/output/input.har/part-0 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -ls -R har:///user/atguigu/output/input.har -rw-r--r-- 3 atguigu supergroup 1366 2020-08-22 17:23 har:///user/atguigu/output/input.har/README.txt -rw-r--r-- 3 atguigu supergroup 34 2020-08-22 17:23 har:///user/atguigu/output/input.har/kongming.txt -rw-r--r-- 3 atguigu supergroup 14 2020-08-22 17:23 har:///user/atguigu/output/input.har/liubei.txt

(4)解归档文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -cp har:///user/atguigu/output/input.har/* /user/atguigu [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -ls -R /user/atguigu -rw-r--r-- 3 atguigu supergroup 1366 2020-08-22 17:34 /user/atguigu/README.txt drwxr-xr-x - atguigu supergroup 0 2020-08-22 17:23 /user/atguigu/input -rw-r--r-- 3 atguigu supergroup 1366 2020-08-22 17:23 /user/atguigu/input/README.txt -rw-r--r-- 3 atguigu supergroup 34 2020-08-22 17:23 /user/atguigu/input/kongming.txt -rw-r--r-- 3 atguigu supergroup 14 2020-08-22 17:23 /user/atguigu/input/liubei.txt -rw-r--r-- 3 atguigu supergroup 34 2020-08-22 17:34 /user/atguigu/kongming.txt -rw-r--r-- 3 atguigu supergroup 14 2020-08-22 17:34 /user/atguigu/liubei.txt drwxr-xr-x - atguigu supergroup 0 2020-08-22 17:26 /user/atguigu/output drwxr-xr-x - atguigu supergroup 0 2020-08-22 17:26 /user/atguigu/output/input.har -rw-r--r-- 3 atguigu supergroup 0 2020-08-22 17:26 /user/atguigu/output/input.har/_SUCCESS -rw-r--r-- 5 atguigu supergroup 302 2020-08-22 17:26 /user/atguigu/output/input.har/_index -rw-r--r-- 5 atguigu supergroup 23 2020-08-22 17:26 /user/atguigu/output/input.har/_masterindex -rw-r--r-- 3 atguigu supergroup 1414 2020-08-22 17:26 /user/atguigu/output/input.har/part-0

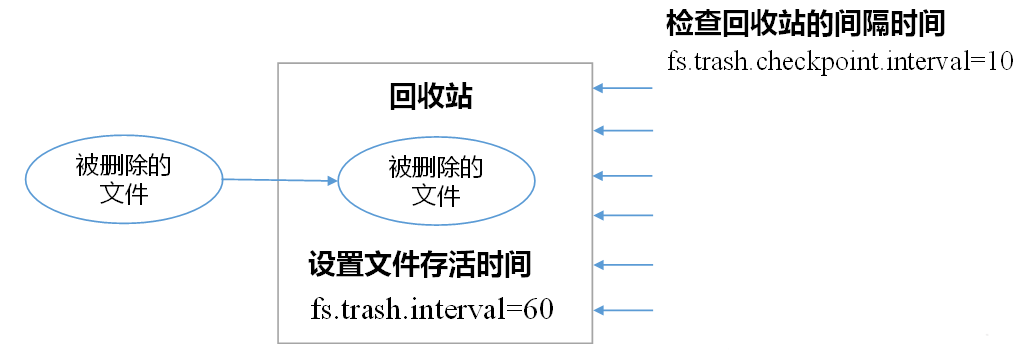

回收站 开启回收站功能,可以将删除的文件在不超时的情况下,恢复原数据,起到防止误删除、备份等作用。

回收站参数设置 开启回收站功能参数说明

默认值fs.trash.interval=0,0表示禁用回收站;其他值表示设置文件的存活时间。

默认值fs.trash.checkpoint.interval=0,检查回收站的时间间隔。如果该值为0,则该值设置和fs.trash.interval的参数值相等。

要求fs.trash.checkpoint.interval<=fs.trash.interval

回收站工作机制 启用回收站 修改core-site.xml,配置垃圾回收时间为1分钟。

1 2 3 4 <property > <name > fs.trash.interval</name > <value > 1</value > </property >

查看回收站 回收站在集群中的路径:/user/atguigu/.Trash/…

修改访问垃圾回收站用户名称 进入垃圾回收站用户名称,默认是dr.who,修改core-site.xml为atguigu用户

1 2 3 4 <property > <name > hadoop.http.staticuser.user</name > <value > atguigu</value > </property >

注意同步分发文件。

通过程序删除的文件不会经过回收站,需要调用moveToTrash()才进入回收站 1 2 3 4 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -rm /liubei.txt 20/08/22 19:30:10 INFO fs.TrashPolicyDefault: Namenode trash configuration: Deletion interval = 1 minutes, Emptier interval = 0 minutes. Moved: 'hdfs://hadoop102:9000/liubei.txt' to trash at: hdfs://hadoop102:9000/user/atguigu/.Trash/Current

执行删除操作后,文件移动至目标文件夹,一分钟后自动删除。

1 2 Trash trash = New Trash (conf) ;trash.moveToTrash(path);

恢复回收站数据 1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -mv /user/atguigu/.Trash/Current/user/atguigu/input /user/atguigu/input

清空回收站 1 [atguigu@hadoop102 hadoop-2.7.2]$ hadoop fs -expunge

按照时间戳生成包,时间到期自动删除。

快照管理 快照相当于对目录做一个备份。并不会立即复制所有文件,而是指向同一个文件。当写入发生时,才会产生新文件。

快照管理API

hdfs dfsadmin -allowSnapshot 路径,开启指定目录的快照功能。hdfs dfsadmin -disallowSnapshot 路径,禁用指定目录的快照功能,默认是禁用。hdfs dfs -createSnapshot 路径,对目录创建快照(默认使用时间戳命名)。hdfs dfs -createSnapshot 路径 名称,指定名称创建快照。hdfs dfs -renameSnapshot 路径 旧名称 新名称,重命名快照。hdfs lsSnapshottableDir,列出当前用户所有可快照目录。hdfs snapshotDiff 路径1 路径2,比较两个快照目录的不同之处。hdfs dfs -deleteSnapshot <path> <snapshotName>,删除快照。

案例实操 (1)开启/禁用指定目录的快照功能

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfsadmin -allowSnapshot /user/atguigu/input [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfsadmin -disallowSnapshot /user/atguigu/input

(2)对目录创建快照

1 2 3 4 5 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfs -createSnapshot /user/atguigu/input Created snapshot /user/atguigu/input/.snapshot/s20200822-195648.481 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfs -lsr /user/atguigu/input/.snapshot/

浏览器端访问看不到隐藏文件夹,需要手动输入目录地址才可以。

(3)指定名称创建快照

1 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfs -createSnapshot /user/atguigu/input miao170508

(4)重命名快照

1 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfs -renameSnapshot /user/atguigu/input/ miao170508 atguigu170508

(5)列出当前用户所有可快照目录

1 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs lsSnapshottableDir

(6)比较两个快照目录的不同之处

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs snapshotDiff /user/atguigu/input/ . .snapshot/atguigu170508

(7)恢复快照

1 2 [atguigu@hadoop102 hadoop-2.7.2]$ hdfs dfs -cp /user/atguigu/input/.snapshot/s20170708-134303.027 /user

HDFS HA高可用 HA概述 1)所谓HA(High Available),即高可用(7*24小时不中断服务)。

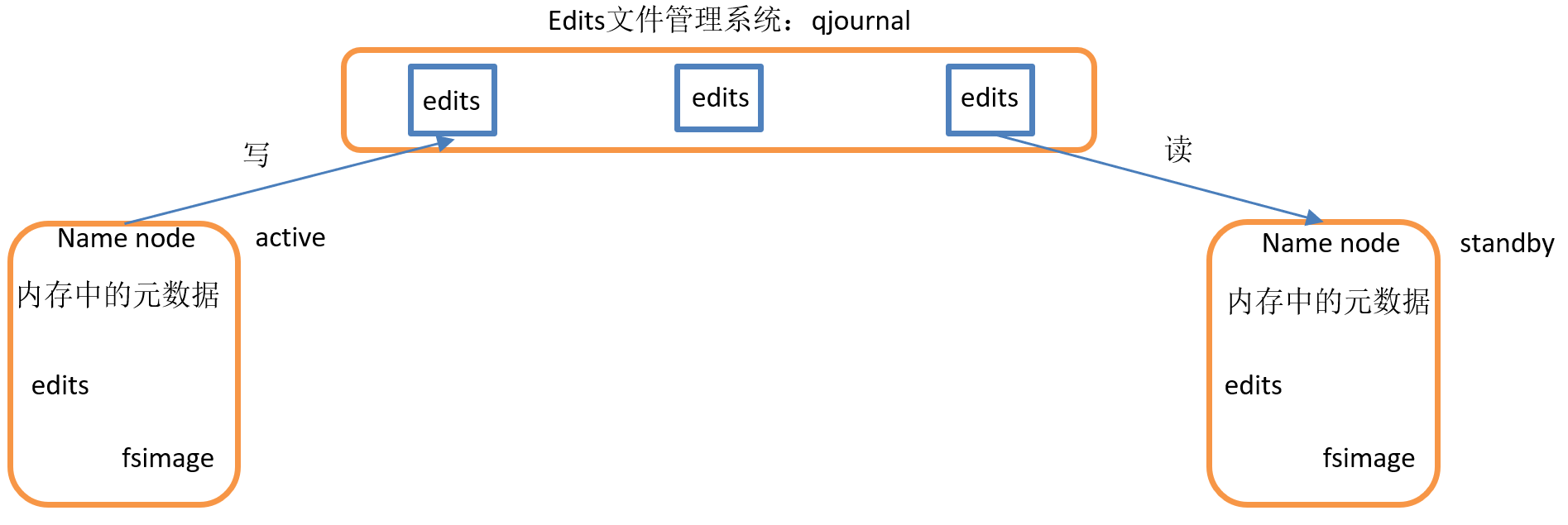

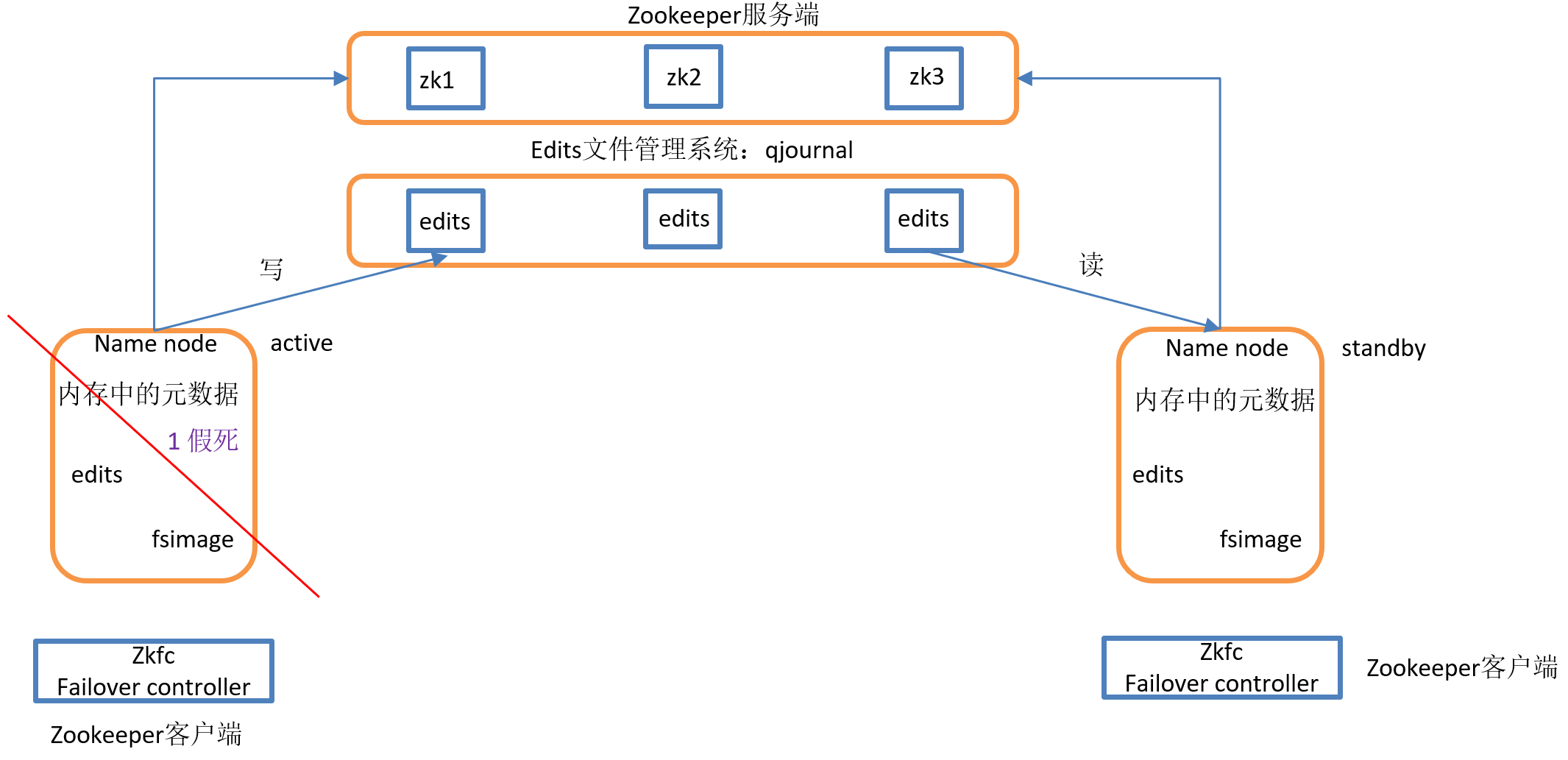

HDFS-HA工作机制 通过双NameNode消除单点故障

HDFS-HA工作要点

元数据管理方式需要改变

内存中各自保存一份元数据;

需要一个状态管理功能模块

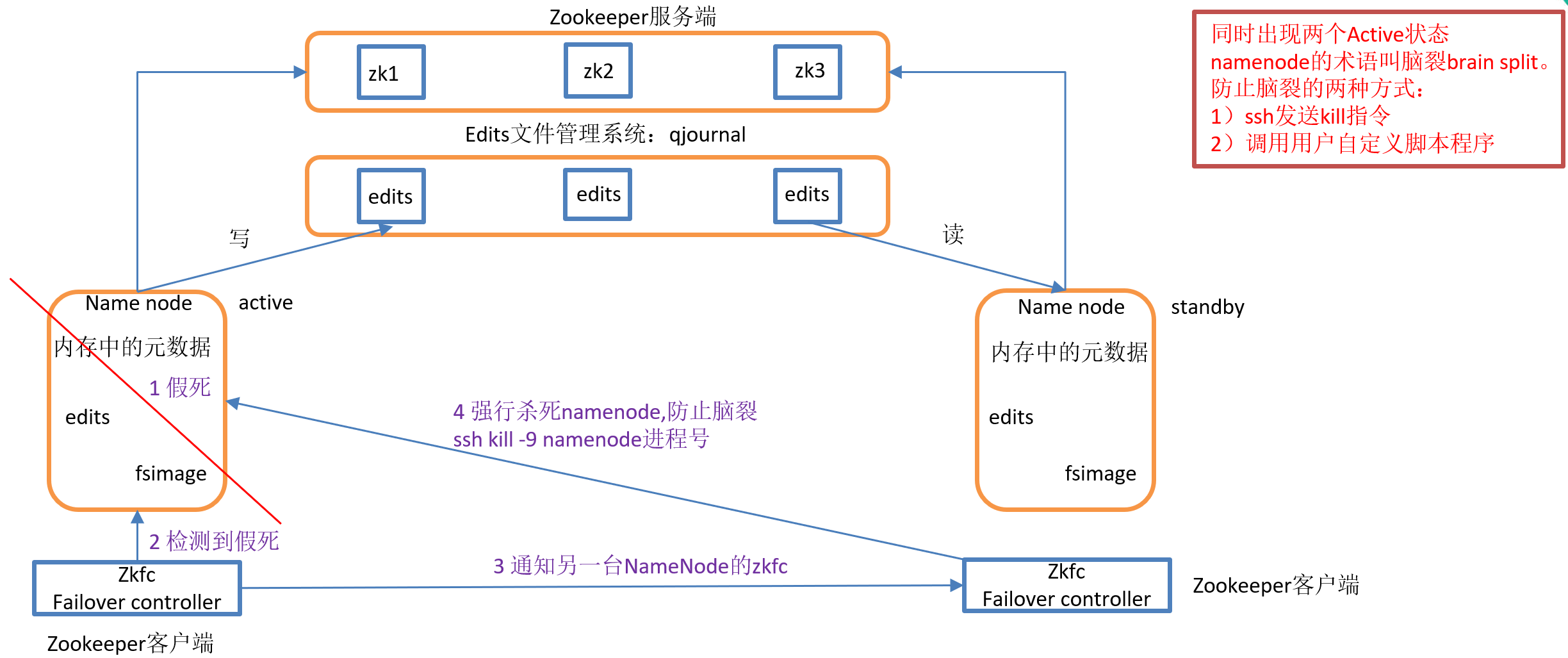

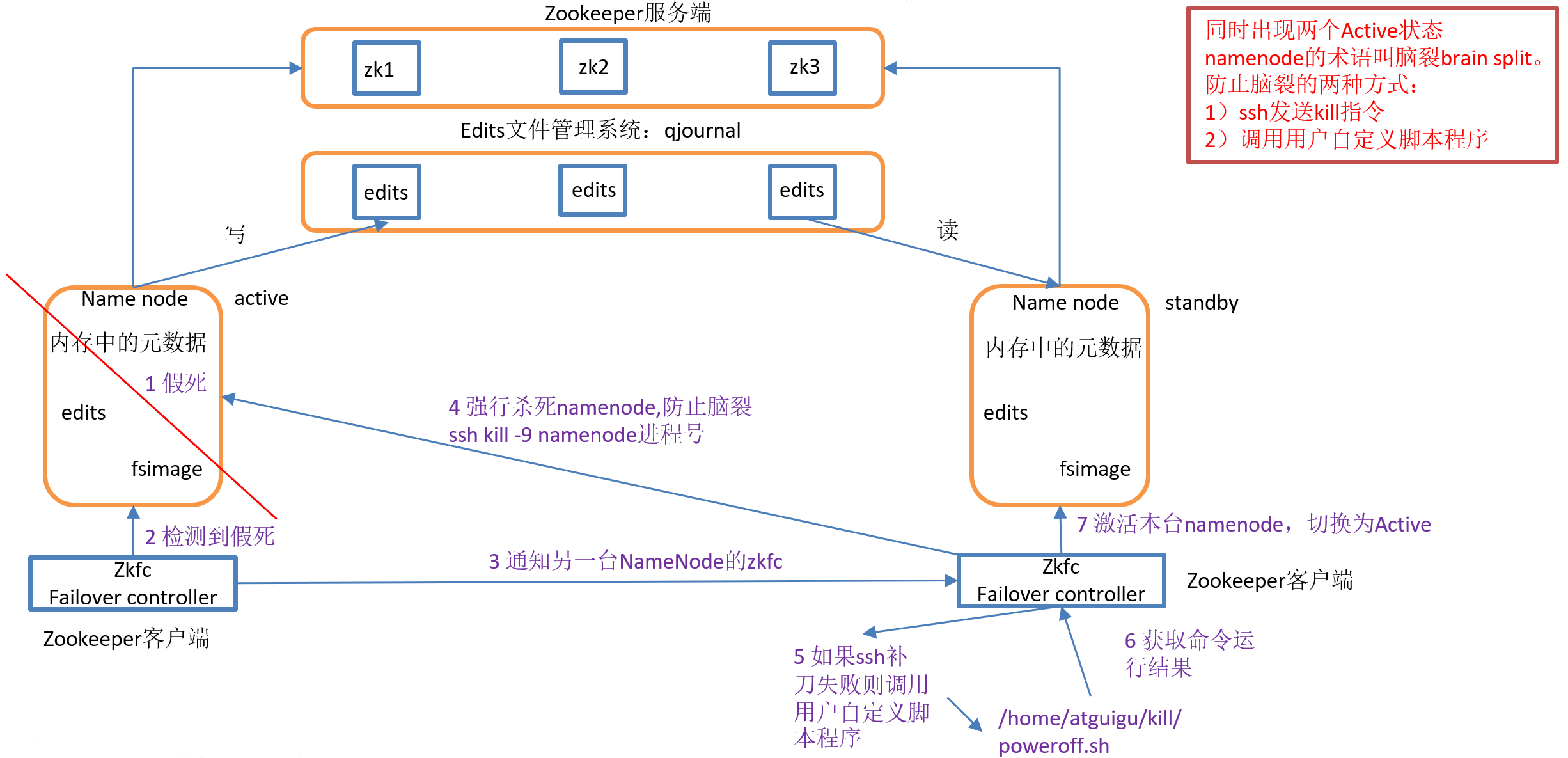

实现了一个zkfailover,常驻在每一个namenode所在的节点,每一个zkfailover负责监控自己所在NameNode节点,利用zk进行状态标识,当需要进行状态切换时,由zkfailover来负责切换,切换时需要防止brain split现象的发生。

必须保证两个NameNode之间能够ssh无密码登录

隔离(Fence),即同一时刻仅仅有一个NameNode对外提供服务

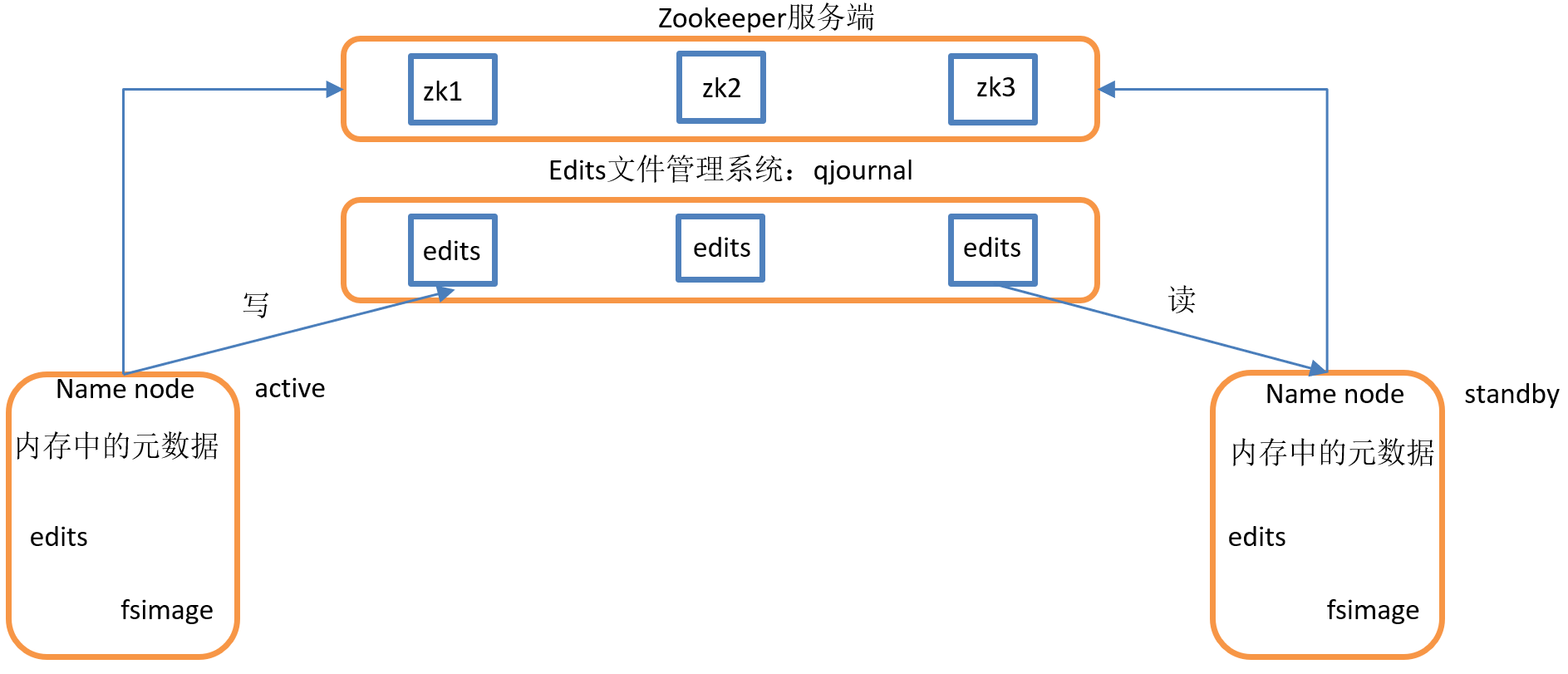

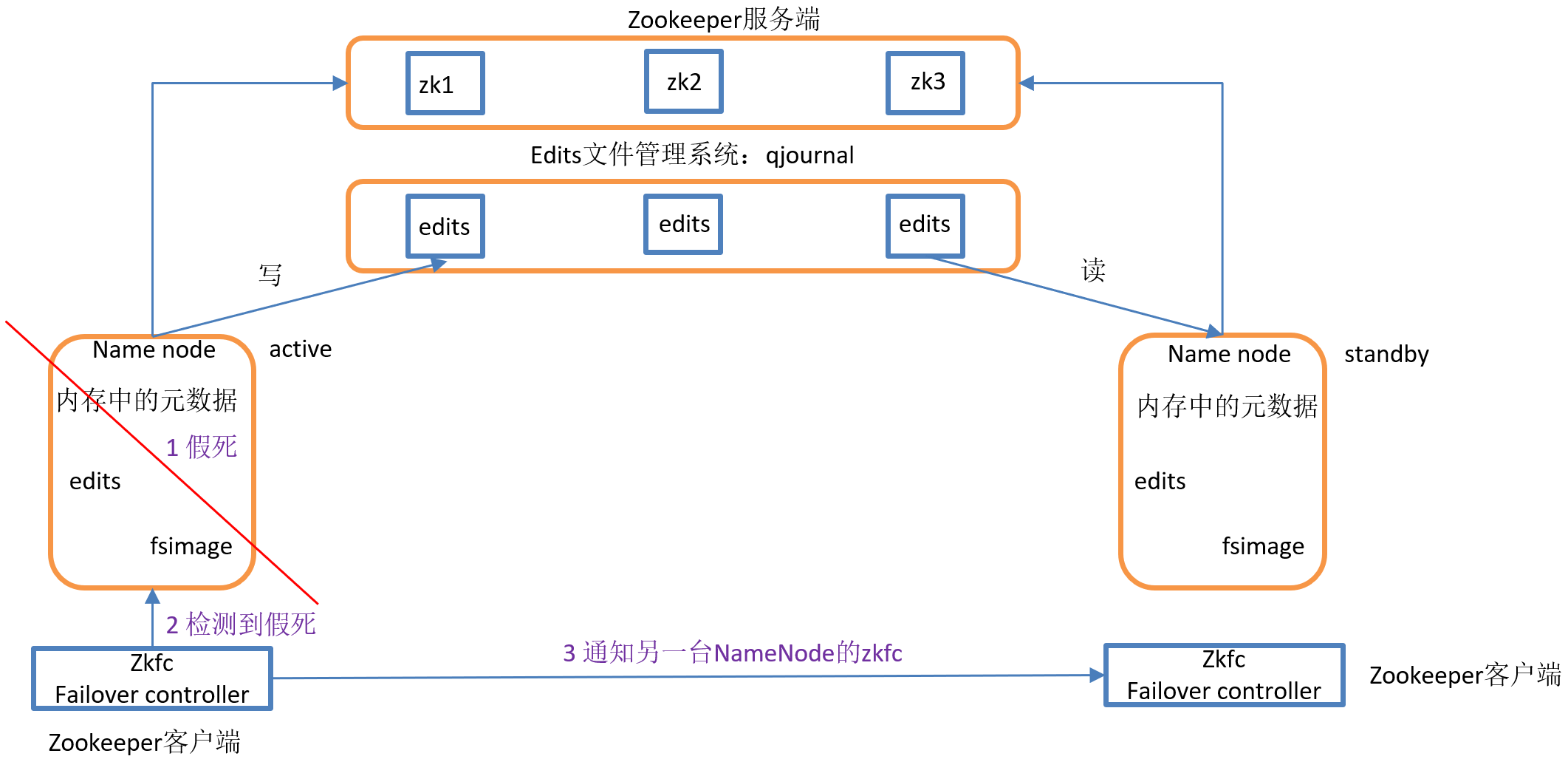

HDFS-HA自动故障转移工作机制 前面学习了使用命令hdfs haadmin -failover手动进行故障转移,在该模式下,即使现役NameNode已经失效,系统也不会自动从现役NameNode转移到待机NameNode,下面学习如何配置部署HA自动进行故障转移。

自动故障转移为HDFS部署增加了两个新组件:ZooKeeper和ZKFailoverController(ZKFC)进程。

ZooKeeper是维护少量协调数据,通知客户端这些数据的改变和监视客户端故障的高可用服务。HA的自动故障转移依赖于ZooKeeper的以下功能:

1)故障检测:集群中的每个NameNode在ZooKeeper中维护了一个持久会话,如果机器崩溃,ZooKeeper中的会话将终止,ZooKeeper通知另一个NameNode需要触发故障转移。

2)现役NameNode选择:ZooKeeper提供了一个简单的机制用于唯一的选择一个节点为active状态。如果目前现役NameNode崩溃,另一个节点可能从ZooKeeper获得特殊的排外锁以表明它应该成为现役NameNode。

1)健康监测:ZKFC使用一个健康检查命令定期地ping与之在相同主机的NameNode,只要该NameNode及时地回复健康状态,ZKFC认为该节点是健康的。如果该节点崩溃,冻结或进入不健康状态,健康监测器标识该节点为非健康的。

2)ZooKeeper会话管理:当本地NameNode是健康的,ZKFC保持一个在ZooKeeper中打开的会话。如果本地NameNode处于active状态,ZKFC也保持一个特殊的znode锁,该锁使用了ZooKeeper对短暂节点的支持,如果会话终止,锁节点将自动删除。

3)基于ZooKeeper的选择:如果本地NameNode是健康的,且ZKFC发现没有其它的节点当前持有znode锁,它将为自己获取该锁。如果成功,则它已经赢得了选择,并负责运行故障转移进程以使它的本地NameNode为Active。故障转移进程与前面描述的手动故障转移相似,首先如果必要保护之前的现役NameNode,然后本地NameNode转换为Active状态。

HDFS-HA集群配置 环境准备

修改IP

修改主机名及主机名和IP地址的映射

关闭防火墙

ssh免密登录

安装JDK,配置环境变量等

规划集群

hadoop102

hadoop103

hadoop104

NameNode

NameNode

JournalNode

JournalNode

JournalNode

DataNode

DataNode

DataNode

ZK

ZK

ZK

ResourceManager

NodeManager

NodeManager

NodeManager

配置Zookeeper集群

集群规划

在hadoop102、hadoop103和hadoop104三个节点上部署Zookeeper。

解压安装

(1)解压Zookeeper安装包到/opt/module/目录下

1 [atguigu@hadoop102 software]$ tar -zxvf zookeeper-3.4.10.tar.gz -C /opt/module/

(2)在/opt/module/zookeeper-3.4.10/这个目录下创建zkData

(3)重命名/opt/module/zookeeper-3.4.10/conf这个目录下的zoo_sample.cfg为zoo.cfg

1 mv zoo_sample.cfg zoo.cfg

配置zoo.cfg文件

(1)具体配置

1 dataDir=/opt/module/zookeeper-3.4.10/zkData

增加如下配置1 2 3 4 server.2=hadoop102:2888:3888 server.3=hadoop103:2888:3888 server.4=hadoop104:2888:3888

(2)配置参数解读

Server.A=B:C:D。

集群操作

(1)在/opt/module/zookeeper-3.4.10/zkData目录下创建一个myid的文件

添加myid文件,注意一定要在linux里面创建,在notepad++里面很可能乱码

(2)编辑myid文件

在文件中添加与server对应的编号:如2

(3)拷贝配置好的zookeeper到其他机器上

1 2 scp -r zookeeper-3.4.10/ root@hadoop103.atguigu.com:/opt/app/ scp -r zookeeper-3.4.10/ root@hadoop104.atguigu.com:/opt/app/

并分别修改myid文件中内容为3、4

(4)分别启动zookeeper

1 2 3 [root@hadoop102 zookeeper-3.4.10] [root@hadoop103 zookeeper-3.4.10] [root@hadoop104 zookeeper-3.4.10]

(5)查看状态

1 2 3 4 5 6 7 8 9 10 11 12 [root@hadoop102 zookeeper-3.4.10] JMX enabled by default Using config: /opt/module/zookeeper-3.4.10/bin/../conf/zoo.cfg Mode: follower [root@hadoop103 zookeeper-3.4.10] JMX enabled by default Using config: /opt/module/zookeeper-3.4.10/bin/../conf/zoo.cfg Mode: leader [root@hadoop104 zookeeper-3.4.5] JMX enabled by default Using config: /opt/module/zookeeper-3.4.10/bin/../conf/zoo.cfg Mode: follower

配置HDFS-HA集群

官方地址:http://hadoop.apache.org/

在opt目录下创建一个ha文件夹

将/opt/app/下的 hadoop-2.7.2拷贝到/opt/ha目录下

1 cp -r hadoop-2.7.2/ /opt/ha/

配置hadoop-env.sh

1 export JAVA_HOME=/opt/module/jdk1.8.0_144

配置core-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 <configuration > <property > <name > fs.defaultFS</name > <value > hdfs://mycluster</value > </property > <property > <name > hadoop.tmp.dir</name > <value > /opt/ha/hadoop-2.7.2/data/tmp</value > </property > </configuration >

配置hdfs-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 <configuration > <property > <name > dfs.nameservices</name > <value > mycluster</value > </property > <property > <name > dfs.ha.namenodes.mycluster</name > <value > nn1,nn2</value > </property > <property > <name > dfs.namenode.rpc-address.mycluster.nn1</name > <value > hadoop102:9000</value > </property > <property > <name > dfs.namenode.rpc-address.mycluster.nn2</name > <value > hadoop103:9000</value > </property > <property > <name > dfs.namenode.http-address.mycluster.nn1</name > <value > hadoop102:50070</value > </property > <property > <name > dfs.namenode.http-address.mycluster.nn2</name > <value > hadoop103:50070</value > </property > <property > <name > dfs.namenode.shared.edits.dir</name > <value > qjournal://hadoop102:8485;hadoop103:8485;hadoop104:8485/mycluster</value > </property > <property > <name > dfs.ha.fencing.methods</name > <value > sshfence</value > </property > <property > <name > dfs.ha.fencing.ssh.private-key-files</name > <value > /home/atguigu/.ssh/id_rsa</value > </property > <property > <name > dfs.journalnode.edits.dir</name > <value > /opt/ha/hadoop-2.7.2/data/jn</value > </property > <property > <name > dfs.permissions.enable</name > <value > false</value > </property > <property > <name > dfs.client.failover.proxy.provider.mycluster</name > <value > org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value > </property > </configuration >

拷贝配置好的hadoop环境到其他节点

启动HDFS-HA集群

在各个JournalNode节点上,输入以下命令启动journalnode服务

1 sbin/hadoop-daemon.sh start journalnode

在[nn1]上,对其进行格式化,并启动

1 2 bin/hdfs namenode -format sbin/hadoop-daemon.sh start namenode

在[nn2]上,同步nn1的元数据信息

1 bin/hdfs namenode -bootstrapStandby

启动[nn2]

1 sbin/hadoop-daemon.sh start namenode

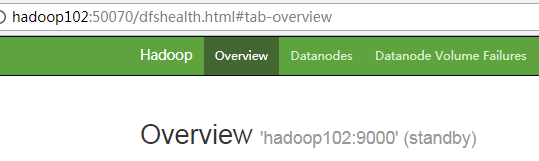

查看web页面显示

在[nn1]上,启动所有datanode

1 sbin/hadoop-daemons.sh start datanode

将[nn1]切换为Active

1 bin/hdfs haadmin -transitionToActive nn1

查看是否Active

1 bin/hdfs haadmin -getServiceState nn1

配置HDFS-HA自动故障转移

具体配置

(1)在hdfs-site.xml中增加

1 2 3 4 <property > <name > dfs.ha.automatic-failover.enabled</name > <value > true</value > </property >

(2)在core-site.xml文件中增加

1 2 3 4 <property > <name > ha.zookeeper.quorum</name > <value > hadoop102:2181,hadoop103:2181,hadoop104:2181</value > </property >

启动

(1)关闭所有HDFS服务:

(2)启动Zookeeper集群:

(3)初始化HA在Zookeeper中状态:

(4)启动HDFS服务:

(5)在各个NameNode节点上启动DFSZK Failover Controller,先在哪台机器启动,哪个机器的NameNode就是Active NameNode

1 sbin/hadoop-daemin.sh start zkfc

验证

(2)将Active NameNode机器断开网络

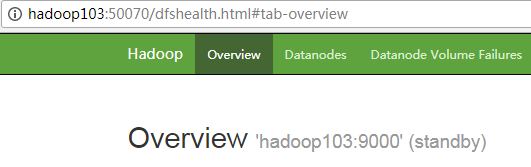

YARN-HA配置 YARN-HA工作机制

官方文档:

http://hadoop.apache.org/docs/r2.7.2/hadoop-yarn/hadoop-yarn-site/ResourceManagerHA.html

YARN-HA工作机制

配置YARN-HA集群

环境准备

(1)修改IP

规划集群

hadoop102

hadoop103

hadoop104

NameNode

NameNode

JournalNode

JournalNode

JournalNode

DataNode

DataNode

DataNode

ZK

ZK

ZK

ResourceManager

ResourceManager

NodeManager

NodeManager

NodeManager

具体配置

(1)yarn-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 <configuration > <property > <name > yarn.nodemanager.aux-services</name > <value > mapreduce_shuffle</value > </property > <property > <name > yarn.resourcemanager.ha.enabled</name > <value > true</value > </property > <property > <name > yarn.resourcemanager.cluster-id</name > <value > cluster-yarn1</value > </property > <property > <name > yarn.resourcemanager.ha.rm-ids</name > <value > rm1,rm2</value > </property > <property > <name > yarn.resourcemanager.hostname.rm1</name > <value > hadoop102</value > </property > <property > <name > yarn.resourcemanager.hostname.rm2</name > <value > hadoop103</value > </property > <property > <name > yarn.resourcemanager.zk-address</name > <value > hadoop102:2181,hadoop103:2181,hadoop104:2181</value > </property > <property > <name > yarn.resourcemanager.recovery.enabled</name > <value > true</value > </property > <property > <name > yarn.resourcemanager.store.class</name > <value > org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value > </property > </configuration >

(2)同步更新其他节点的配置信息

启动hdfs

(1)在各个JournalNode节点上,输入以下命令启动journalnode服务:

1 sbin/hadoop-daemon.sh start journalnode

(2)在[nn1]上,对其进行格式化,并启动:

1 2 bin/hdfs namenode -format sbin/hadoop-daemon.sh start namenode

(3)在[nn2]上,同步nn1的元数据信息:

1 bin/hdfs namenode -bootstrapStandby

(4)启动[nn2]:

1 sbin/hadoop-daemon.sh start namenode

(5)启动所有DataNode

1 sbin/hadoop-daemons.sh start datanode

(6)将[nn1]切换为Active

1 bin/hdfs haadmin -transitionToActive nn1

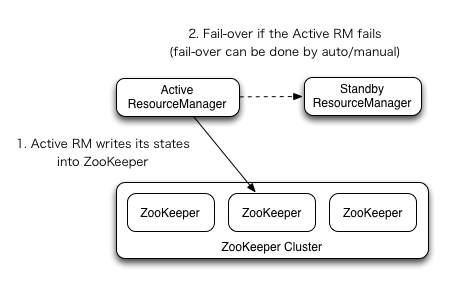

启动YARN

(1)在hadoop102中执行:

(2)在hadoop103中执行:

1 sbin/yarn-daemon.sh start resourcemanager

(3)查看服务状态。

1 bin/yarn rmadmin -getServiceState rm1

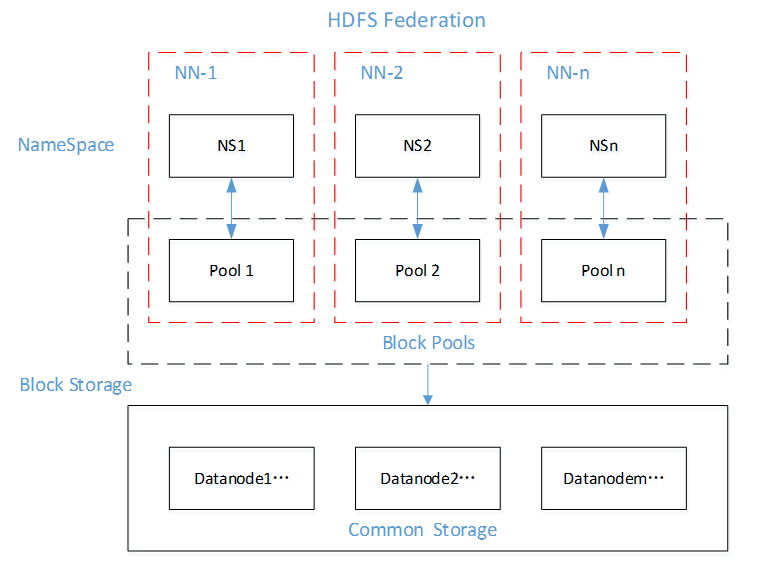

HDFS Federation架构设计

NameNode架构的局限性

(1)Namespace(命名空间)的限制

由于NameNode在内存中存储所有的元数据(metadata),因此单个NameNode所能存储的对象(文件+块)数目受到NameNode所在JVM的heap size的限制。50G的heap能够存储20亿(200million)个对象,这20亿个对象支持4000个DataNode,12PB的存储(假设文件平均大小为40MB)。随着数据的飞速增长,存储的需求也随之增长。单个DataNode从4T增长到36T,集群的尺寸增长到8000个DataNode。存储的需求从12PB增长到大于100PB。

(2)隔离问题

由于HDFS仅有一个NameNode,无法隔离各个程序,因此HDFS上的一个实验程序就很有可能影响整个HDFS上运行的程序。

(3)性能的瓶颈

由于是单个NameNode的HDFS架构,因此整个HDFS文件系统的吞吐量受限于单个NameNode的吞吐量。

HDFS Federation架构设计

能不能有多个NameNode

NameNode

NameNode

NameNode

元数据

元数据

元数据

Log

machine

电商数据/话单数据

HDFS Federation应用思考

不同应用可以使用不同NameNode进行数据管理:图片业务、爬虫业务、日志审计业务

Hadoop生态系统中,不同的框架使用不同的NameNode进行管理NameSpace。(隔离性)